Fondamenti della Teoria delle Matrici Random e applicazioni in sica Introduzione Lo studio delle...

Transcript of Fondamenti della Teoria delle Matrici Random e applicazioni in sica Introduzione Lo studio delle...

Universita degli Studi di Torino

SCUOLA DI SCIENZE DELLA NATURA

Corso di Laurea in Fisica

Fondamenti della Teoriadelle Matrici Randome applicazioni in fisica

Tesi di Laurea Triennale in Fisica

Relatore:Prof. Marco Panero

Candidato:Fabio Minniti

Anno Accademico2015-2016

“La pioggia delle foglioline del

ginko e caratterizzata dal fatto

che in ogni momento ogni

fogliolina che sta cadendo si

trova ad una altezza diversa

delle altre, per cui lo spazio

vuoto e insensibile in cui si

situano le sensazioni visive puo

essere suddiviso in una

successione di livelli in ognuno

dei quali si trova a volteggiare

una ed una sola fogliolina.”

I. Calvino

Abstract

La teoria delle matrici random (RMT) venne introdotta da Wigner nel conte-

sto della fisica nucleare, nella seconda meta dello scorso secolo. Negli ultimi

anni le previsioni della teoria sono state applicate in contesti apparentemente

molto diversi con ottimi risultati. Nell’elaborato si descrivono gli elementi

essenziali della teoria a partire dalle proprieta strutturali degli insiemi di

matrici random fino a descriverne le funzioni per le densita di probabilita

associate alle matrici appartenenti agli insiemi e agli autovalori reali. Ven-

gono poi descritti alcuni contesti nei quali la teoria si applica mettendo in

evidenza l’universalita della stessa. Si descrive il problema del car parking

introducendo dei modelli iterativi random per poi confrontare i dati con le

previsioni della teoria delle matrici random.

Introduzione

Lo studio delle matrici random venne introdotto da Wishart [1] negli anni

venti nel contesto della matematica statistica. Non prima degli anni cinquan-

ta pero, le matrici random vennero sfruttate per modellizzare la realta fisica.

In meccanica quantistica l’equazione di Schrodinger delinea esaustivamente

in linea di principio l’evoluzione dinamica dei sistemi di particelle. Nonostan-

te la forma dell’equazione suggerisca un approccio relativamente intuitivo al

problema, essa conduce a soluzioni analitiche solo in un numero molto limita-

to di casi. Considerando, ad esempio, un nucleo pesante o un generico sistema

multi-particelle, diventa rapidamente complicato aspettarsi di ottenere una

soluzione esatta al problema o anche soltanto una buona approssimazione.

L’inefficacia di uno specifico accostamento non definisce l’impossibilita di

trarre informazioni fisiche ma piuttosto rappresenta la necessita di cercare

approcci alternativi. In questo contesto Wigner, fisico e matematico unghe-

rese naturalizzato statunitense, vincitore del Premio Nobel per la fisica nel

1963, introdusse un assetto interpretativo mediante il quale avrebbe cercato

di descrivere alcuni fenomeni attraverso la definizione di insiemi di matrici

random [2]. Comprendere le ragioni per cui lo fece implica considerare il con-

testo sperimentale e teorico della fisica nella prima, e all’inizio della seconda,

meta del XX secolo.

In processi di scattering di neutroni a basse energie su nuclei pesanti vengono

osservate delle risonanze corrispondenti a stati eccitati semi-stabili associati

i

ii INTRODUZIONE

a nuovi nuclei. Questo avviene quando i neutroni incidono frontalmente con

i nuclei trasferendo la loro energia cinetica ai costituenti del nucleo bersaglio.

Quando gli stati eccitati decadono i neutroni emessi presentano un momento

diverso rispetto a quello precedente all’urto. Non tutti i neutroni vengono

assorbiti dai nuclei ma soltanto quelli con specifiche energie. Rappresentan-

do per esempio l’andamento della sezione d’urto in funzione dell’energia si

osservano dei picchi in prossimita delle energie di risonanza ognuno dei quali

rappresenta uno stato eccitato per il nucleo originale dell’elemento illumina-

to. La sequenza dei picchi non e casuale ma rappresentativa univocamente

rispetto al campione sul quale si effettua scattering. Se si conoscesse l’ha-

miltoniana del sistema risolvendo l’equazione di Schrodinger si potrebbe in

linea di principio ricavare lo spettro di energia relativo

HΨi(~x, t) = EiΨi(~x, t) (1)

dove H e l’operatore hamiltoniano e Ψi e l’autostato relativo all’autovalore

Ei. Nella maggior parte dei casi il sistema in esame non e sintetizzabile in

un’equazione agli autovalori in quanto la forma dell’hamiltoniana non e nota.

Wigner propose, nel caso in cui sia impossibile ricavare l’hamiltoniana che de-

scriva esattamente il sistema, di definire un ensemble di hamiltoniane aventi

medesime proprieta statistiche che l’hamiltoniana del sistema potrebbe avere

nel caso in cui fosse possibile esplicitarla. Piu in generale si potrebbe sperare

di ottenere proprieta generali relative agli spettri delle singole hamiltoniane

che in media approssimano le proprieta specifiche del sistema. Dyson speci-

fico ulteriormente in cosa consistesse l’interpretazione alla Wigner riferendosi

al sistema come ad una black box all’interno della quale piu particelle intera-

giscono in accordo a leggi non deducibili. Il problema consiste nel considerare

un ensemble di matrici in cui tutte le leggi di interazione siano equiprobabili

[3]. La Random Matrix Theory consiste nel definire un insieme di matrici e

trovare, partendo dall’insieme definito, proprieta medie relative allo spettro e

allo stato associato alle matrici stesse, rinunciando pero ai dettagli intrinseci

INTRODUZIONE iii

di uno specifico sistema.

La RMT (Random Matrix Theory) si e rivelata efficace non solo in mec-

canica quantistica ma anche nello studio di molti altri sistemi complessi,

dallo studio delle risonanze soniche nei cristalli di quarzo all’andamento dei

mercati finanziari. La teoria e stata applicata con successo anche nell’ambito

dei sistemi non integrabili nei quali l’evoluzione temporale risulta indipen-

dente dalle condizioni iniziali.

Nel primo capitolo dell’elaborato si definiranno formalmente le matrici ran-

dom e si classificheranno in base a specifiche simmetrie, cosı come storica-

mente venne fatto da Wigner. Inoltre, si ricavera una funzione densita di

probabilita per le matrici appartenenti agli insiemi definiti. Nel secondo

capitolo ci si soffermera, invece, sulla forma funzionale della densita di pro-

babilita congiunta relativa agli autovalori delle matrici random e su alcune

proprieta ad essi correlate. Infine, nell’ultimo capitolo si descrivera il vasto

campo di applicabilita della RMT, approfondendo in particolare il problema

del car parking.

La trattazione formale si basa essenzialmente sul lavoro di sintesi effettuato

da Mehta in [4] mentre per le applicazioni si e fatto riferimento a vari articoli

presenti in letteratura, i quali verranno specificati nel seguito.

Indice

Introduzione i

1 Insiemi di Matrici Random 1

1.1 Insiemi gaussiani di matrici . . . . . . . . . . . . . . . . . . . 1

1.1.1 Operatore di inversione temporale . . . . . . . . . . . . 1

1.1.2 Insieme Gaussiano Ortogonale (GOE) . . . . . . . . . . 3

1.1.3 Insiemi Gaussiani Unitari (GUE) e Simplettici (GSE) . 5

1.2 Funzione densita di probabilita . . . . . . . . . . . . . . . . . 8

1.2.1 Riepilogo . . . . . . . . . . . . . . . . . . . . . . . . . 13

2 Densita di probabilita congiunta per gli autovalori 15

2.1 GOE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

2.2 GUE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

2.2.1 Analogia con il gas di Coulomb . . . . . . . . . . . . . 22

2.3 Distribuzione degli autovalori . . . . . . . . . . . . . . . . . . 24

2.3.1 Spaziatura tra autovalori . . . . . . . . . . . . . . . . . 25

2.3.2 Wigner surmise . . . . . . . . . . . . . . . . . . . . . . 26

2.3.3 Densita degli stati . . . . . . . . . . . . . . . . . . . . 28

2.3.4 Riepilogo . . . . . . . . . . . . . . . . . . . . . . . . . 31

3 Applicazioni 33

3.1 RMT in fisica . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

3.1.1 Fisica Nucleare . . . . . . . . . . . . . . . . . . . . . . 33

3.1.2 Spettro dell’operatore di Dirac in QCD . . . . . . . . . 34

v

vi INDICE

3.1.3 Funzione ζ di Riemann . . . . . . . . . . . . . . . . . . 37

3.1.4 Quantum Chaos . . . . . . . . . . . . . . . . . . . . . . 39

3.1.5 Gravita quantistica . . . . . . . . . . . . . . . . . . . . 40

3.1.6 Altre applicazioni . . . . . . . . . . . . . . . . . . . . . 42

3.2 Car parking . . . . . . . . . . . . . . . . . . . . . . . . . . . . 42

3.2.1 Modellizzazione dei dati empirici . . . . . . . . . . . . 43

3.2.2 Risultati . . . . . . . . . . . . . . . . . . . . . . . . . . 47

3.2.3 Riepilogo . . . . . . . . . . . . . . . . . . . . . . . . . 51

Conclusioni 53

A Quaternioni e trasformazioni simplettiche 55

B Determinante di Vandermonde 59

C Equazioni di Dickman 61

Bibliografia 63

Capitolo 1

Insiemi di Matrici Random

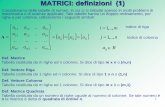

In questa prima parte dell’elaborato verranno introdotti degli insiemi

gaussiani di matrici come astrazioni matematiche per poi procedere enu-

merandone le proprieta. Inoltre, verra discusso il legame tra il concetto di

simmetria e le caratteristiche delle matrici. Successivamente si ricavera la

funzione densita di probabilita per le matrici costituenti degli insiemi.

1.1 Insiemi gaussiani di matrici

Storicamente gli insiemi gaussiani di matrici furono esposti da Wigner

facendo riferimento a specifiche simmetrie dei sistemi in analisi. In particola-

re, come gia spiegato nell’introduzione, vennero formalizzati contestualmente

allo studio degli stati di risonanza dei nuclei pesanti in processi di scattering

di neutroni a basse energie. Per completezza si descrivera nel seguito l’ope-

ratore di inversione temporale e si restringera il dominio nel quale verranno

definiti gli insiemi di matrici, dipendentemente a diverse simmetrie.

1.1.1 Operatore di inversione temporale

Vengono qui ricordate alcune nozioni basilari riguardanti l’operatore di

inversione temporale (che nel seguito si indichera con T ), applicato nel con-

testo della meccanica quantistica, e l’invarianza rispetto ad esso.

1

2 1. Insiemi di Matrici Random

Da semplici considerazioni fisiche T risulta essere antiunitario

T = KC (1.1)

dove K e un operatore unitario fissato e C effettua l’operazione di complessa

coniugazione sullo stato al quale viene applicato. Considerando un’opportuna

base di autostati, l’applicazione di T ad un generico stato Ψ decomposto

rispetto alla base produce un ulteriore stato ΨR il cui legame con lo stato

originale e definito da

ΨR = TΨ = KΨ∗ (1.2)

dove Ψ∗ rappresenta il complesso coniugato di Ψ. Dalla condizione

(Φ, AΨ) = (ΨR, ARΦR) (1.3)

per ogni coppia di stati Ψ e Φ si deduce la legge di trasformazione per un

operatore A soggetto all’azione di T

AR = KATK−1 (1.4)

dove AT rappresenta la trasposta di A. L’operatore si dice autoduale se

AR = A. Considerando il caso specifico di sistemi descritti da un operatore

Hamiltoniano H, essi godono di invarianza rispetto all’azione di T se H

risulta essere hermitiano

H† = H (1.5)

Quando la rappresentazione di uno stato viene modificata dall’azione di una

1.1 Insiemi gaussiani di matrici 3

trasformazione unitaria Ψ −→ UΨ l’operatore T si trasforma a sua volta

come

T −→ KTK−1 = KTK† (1.6)

dove il secondo passaggio e giustificato dalla definizione di operatore unitario

KK† = K†K = 1. Applicando due volte l’operatore T ci si aspetta esso

corrisponda a meno di un fattore di fase all’operatore identita

T 2 = α1 (1.7)

con |α| = 1. Dalla definizione di T si puo anche scrivere

T 2 = KCKC = KK∗CC = KK∗ = α1 (1.8)

Inoltre, essendo K unitario

K∗KT = 1 (1.9)

per cui dalle due equazioni si ottiene

K = αKT = α(αKT )T = α2K (1.10)

A seguito delle considerazioni precedenti non puo che essere α2 = 1 o α = ±1.

La matrice K dunque, oltre ad essere hermitiana e anche o simmetrica o

antisimmetrica a seconda del valore assunto da α.

1.1.2 Insieme Gaussiano Ortogonale (GOE)

L’insieme gaussiano di matrici ortogonali (indicato da qui in avanti con

l’acronimo GOE, dall’inglese Gaussian Orthogonal Ensemble) e definito ri-

4 1. Insiemi di Matrici Random

ferendosi a sistemi invarianti rispetto a inversioni temporali per cui valga

U = 1. Se l’operatore unitario coincide con l’identita, l’Hamiltoniana H del

sistema oltre ad essere hermitiana sara anche simmetrica. In altre parole

ad ogni sistema invariante rispetto ad inversioni temporali e associata una

matrice reale e simmetrica in un’opportuna base di autostati.

Il motivo per cui agli ensembles viene associato l’aggettivo “gaussiano” dipen-

de dalla distribuzione di probabilita rispetto alla quale sono definiti randomi-

camente gli elementi di matrice. Ricordando l’espressione della distribuzione

gaussiana

f(x) =1√

2πσ2e

−(x−µ)2

2σ2 (1.11)

con µ valor medio e σ2 varianza, associando ad ogni elemento di matrice aij,

con i, j = 1, 2, ..., N , la funzione f(aij) in modo indipendente, l’elemento di

matrice diventa l’argomento della distribuzione di probabilita.

Proprieta del GOE

Si consideri lo spazio delle matrici reali e simmetriche T1G di dimensioni

N ×N tali che A = AT ∀A ∈ T1G, o alternativamente per cui valga aij = aji

con i, j = 1, 2, ..., N . L’insieme gaussiano delle matrici ortogonali E1G e de-

finito in T1G e verifica le seguenti proprieta:

(1) Invarianza rispetto a trasformazioni ortogonali

T :T1G −→ T1G (1.12)

H 7−→ OTHO (1.13)

dove O e una matrice ortogonale reale.

(2) Indipendenza statistica degli elementi matriciali Hkj con k ≤ j.

Rispettivamente le due proprieta si possono esprimere formalmente come

1.1 Insiemi gaussiani di matrici 5

segue:

(1) La probabilita P (H)dH che una matrice di E1G appartenga al volume

multidimensionale dH =∏

k≤j dHkj e invariante rispetto a trasformazioni

ortogonali

P (H ′)dH ′ = P (H)dH (1.14)

dove

H ′ = OTHO (1.15)

per cui valga OTO = OOT = 1.

(2) La funzione densita di probabilita P (H) e definita dal prodotto di funzioni

reali di variabile reale

P (H) =∏k≤j

fkj(Hkj) (1.16)

1.1.3 Insiemi Gaussiani Unitari (GUE) e Simplettici

(GSE)

A differenza dell’insieme ortogonale gaussiano (GOE), l’insieme unitario

gaussiano (GUE) e l’insieme simplettico gaussiano (GSE) sono costituiti ri-

spettivamente da elementi complessi e quaternioni reali. Nel seguito verranno

descritte in modo esaustivo le principali proprieta del GUE e si forniranno

alcuni elementi relativi al GSE.

6 1. Insiemi di Matrici Random

Proprieta del GUE

L’insieme delle matrici gaussiane unitarie, indicato con E2G, e definito

nello spazio delle matrici hermitiane T2G, cioe matrici per cui valga A† = A

∀A ∈ T2G, con le due seguenti proprieta:

(1) La probabilita P (H)dH che una matrice dell’insieme E2G appartenga

al volume

dH =∏k≤j

dH(0)kj

∏k<j

dH(1)kj (1.17)

dove H(0)kj e H

(1)kj sono rispettivamente la parte reale e immaginaria dell’ele-

mento di matrice Hkj, e invariante rispetto all’automorfismo

U :T2G −→ T2G (1.18)

H 7−→ U−1HU (1.19)

dove la matrice U e unitaria.

(2) Le componenti linearmente indipendenti di H sono statisticamente in-

dipendenti.

Esattamente come fatto in precedenza nel caso del GOE le due proprieta

vengono esplicitate:

(1)

P (H ′)dH ′ = P (H)dH (1.20)

se

H ′ = U−1HU (1.21)

1.1 Insiemi gaussiani di matrici 7

dove U e una matrice unitaria.

(2) P (H) e il prodotto di funzioni di singola variabile reale

P (H) =∏k≤j

f(0)kj (H

(0)kj )∏k<j

f(1)kj (H

(1)kj ) (1.22)

Proprieta del GSE

L’insieme delle matrici gaussiane simplettiche E4G e definito nello spazio

delle matrici hermitiane autoduali T4G con le seguenti proprieta:

(1) E4G e invariante rispetto ad ogni automorfismo

S :T4G −→ T4G (1.23)

H 7−→ W−1HW (1.24)

dove W e una matrice simplettica.

(2) Le componenti di H sono anch’esse statisticamente indipendenti.

Le due proprieta si esplicitano come di seguito:

(1) La probabilita P (H)dH che l’insieme E4G si trovi nel volume

dH =∏k≤j

dH(0)kj

3∏λ=1

∏k<j

dH(λ)kj (1.25)

e invariante rispetto a trasformazioni simplettiche

P (H ′)dH ′ = P (H)dH (1.26)

8 1. Insiemi di Matrici Random

se

H ′ = WRHW (1.27)

dove

WRW = 1 (1.28)

dove λ varia rispetto alle componenti del quaternione Hkj con k ≤ j1.

(2) P (H) e il prodotto di funzioni di singola variabile reale

P (H) =∏k≤j

f(0)kj (H

(0)kj )

3∏λ=1

∏k<j

f(λ)kj (H

(λ)kj ) (1.29)

1.2 Funzione densita di probabilita

Si voglia a questo punto definire la funzione densita di probabilita asso-

ciata alle matrici degli insiemi. Come verra esposto nel seguito la richiesta

di invarianza e di indipendenza statistica tra gli elementi della matrice fissa

univocamente la forma funzionale della P (H).

L’invarianza restringe P (H) a dipendere soltanto da un numero finito di

tracce di potenze di H. Il concetto si puo esprimere sotto forma di lemma

[5].

Lemma 1.2.1. Le quantita invarianti di una matrice (N × N) H soggetta

alla trasformazione

H −→ H ′ = AHA−1 (1.30)

possono essere espresse in termini delle tracce delle prime N potenze di H.

1Per maggiori dettagli si veda l’Appendice A.

1.2 Funzione densita di probabilita 9

La traccia della j-esima potenza di H e data dalla somma delle j potenze

degli autovalori λk, k = 1, 2, ..., N , di H

trHj =N∑k=1

λjk ≡ pj (1.31)

e ogni funzione simmetrica dei λk puo essere espressa in termini dei primi pj

con j = 1, 2, ..., N (vedere per esempio [6, 7]).

Invece, l’indipendenza statistica delle componenti esclude tutte le tracce ad

eccezione delle prime due potenze, vincolando la P (H) ad essere proporzio-

nale ad un esponenziale.

Si esaminano nel seguito le conseguenze relative all’indipendenza statistica

delle varie componenti della matrice H. Si consideri la trasformazione

H = U−1H ′U (1.32)

dove

U =

cos θ sin θ 0 · · · 0

− sin θ cos θ 0 · · · 0

0 0 1 · · · 0...

......

. . ....

0 0 0 · · · 1

(1.33)

e contemporaneamente una trasformazione simplettica, unitaria e ortogonale.

Differenziando la (1.32) rispetto a θ si ricava

∂H

∂θ=∂U−1

∂θH ′U + U−1H ′

∂U

∂θ(1.34)

=∂UT

∂θH ′U + UTH ′

∂U

∂θ

=∂UT

∂θUH +HUT ∂U

∂θ

10 1. Insiemi di Matrici Random

dove nel secondo passaggio si e sfruttata l’unitarieta UT = U−1. Rica-

vando dalla (1.33) l’espressioni esplicite per UT , ∂U∂θ

e ∂UT

∂θsi ottiene

∂H

∂θ= AH +HAT (1.35)

dove

A =∂UT

∂θU (1.36)

esplicitando i prodotti tra matrici

A =∂

∂θ

cos θ − sin θ 0 · · · 0

sin θ cos θ 0 · · · 0

0 0 1 · · · 0...

......

. . ....

0 0 0 · · · 1

cos θ sin θ 0 · · · 0

− sin θ cos θ 0 · · · 0

0 0 1 · · · 0...

......

. . ....

0 0 0 · · · 1

=

− sin θ − cos θ 0 · · · 0

cos θ − sin θ 0 · · · 0

0 0 0 · · · 0...

......

. . ....

0 0 0 · · · 0

cos θ sin θ 0 · · · 0

− sin θ cos θ 0 · · · 0

0 0 1 · · · 0...

......

. . ....

0 0 0 · · · 1

=

− sin θ cos θ + cos θ sin θ −(sin2 θ + cos2 θ) 0 · · · 0

cos2 θ + sin2 θ cos θ sin θ − sin θ cos θ 0 · · · 0

0 0 0 · · · 0...

......

. . ....

0 0 0 · · · 0

=

0 −1 0 · · · 0

1 0 0 · · · 0

0 0 0 · · · 0...

......

. . ....

0 0 0 · · · 0

(1.37)

1.2 Funzione densita di probabilita 11

Se la funzione densita di probabilita

P (H) =∏(α)

∏j≤k

f(α)kj (H

(α)kj ) (1.38)

e invariante rispetto alla trasformazione U , con α che indicizza parte reale

α = 0 e parte immaginaria α = 1 rispettivamente, la sua derivata fatta

rispetto alla variabile indipendente θ da contributo nullo

∑k,j

1

f(α)kj

∂f(α)kj

∂H(α)kj

∂H(α)kj

∂θ= 0 (1.39)

il motivo per cui la derivata e scalata di un fattore 1/f(α)kj dipende dall’aver

considerato la derivata logaritmica.

Si esplicita l’espressione della derivata nel caso unitario. Gli elementi di

matrice sono complessi Hkj = H(0)kj + iH

(1)kj , inoltre essendo H hermitiana

vale Hkj = H∗jk, ovvero H(0)kj = H

(0)jk e H

(1)kj = −H(1)

jk . Applicando la relazione

(1.35) e la (1.39) si ottiene[(− 1

f(0)11

∂f(0)11

∂H(0)11

+1

f(0)22

∂f(0)22

∂H(0)22

)(2H

(0)12 ) +

1

f(0)12

∂f(0)12

∂H(0)12

(H(0)11 −H

(0)22 )

]+

+N∑k=3

(− 1

f(0)1k

∂f(0)1k

∂H(0)1k

H(0)2k +

1

f(0)2k

∂f(0)2k

∂H(0)2k

H(0)1k

)

+N∑k=3

(− 1

f(1)1k

∂f(1)1k

∂H(1)1k

H(1)2k +

1

f(1)2k

∂f(1)2k

∂H(1)2k

H(1)1k

)= 0 (1.40)

dove ogni addendo dipende da un set di parametri mutuamente esclusivi. La

somma di tutti gli addendi deve essere uguale a zero, pertanto

−H(0)2k

f(0)1k

∂f(0)1k

∂H(0)1k

+H

(0)1k

f(0)2k

∂f(0)2k

∂H(0)2k

= C0k (1.41)

12 1. Insiemi di Matrici Random

con C0k costanti, dividendo per H

(0)1k e H

(0)2k si ottiene un espressione in cui

ogni termine dipende singolarmente da un’unica variabile indipendente, per

cui si ricava

1

H(0)1k

1

f(0)1k

∂f(0)1k

∂H(0)1k

=1

H(0)2k

1

f(0)2k

∂f(0)2k

∂H(0)2k

= −2a (1.42)

dove −2a e una costante arbitraria. Si ottengono due equazioni differenziali

del primo ordine a variabili separabili nella forma

1

H(0)ik

1

f(0)ik

∂f(0)ik

∂H(0)ik

= −2a (1.43)

con i = 1, 2. Integrando si ottiene, nel caso del primo membro

f(0)1k (H

(0)1k ) = exp [−a(H

(0)1k )2] (1.44)

Negli altri due casi si ricavano espressioni analoghe. Considerando il fatto

che gli elementi al di fuori della diagonale principale compaiono al quadrato

nell’esponenziale e tutti gli invarianti sono esprimibili in termini di tracce

delle potenze di H, la P (H) risulta proporzionale ad un esponenziale in cui

ad esponente compare al piu la traccia della seconda potenza di H. La forma

generale per P (H) e

P (H) = ec∏j

exp (bH(0)jj )∏k≤j

exp [−a(H(0)kj )2]

3∏λ=1

∏k<j

exp [−a(H(λ)kj )2] (1.45)

dove le costante a e reale e positiva e b e c sono reali, in modo tale da rendere

normalizzabile e reale l’espressione di P (H). Il risultato ottenuto venne gia

derivato da Porter e Rosenzweig [8] nel 1960 ed esplicitato formalmente come

nel seguito.

1.2 Funzione densita di probabilita 13

Teorema 1.2.2. Per i tre insiemi introdotti in precedenza, P (H) e della

forma

P (H) = exp (−a trH2 + b trH + c) (1.46)

dove a e reale e positiva e b e c sono reali.

1.2.1 Riepilogo

La densita di probabilita P (H) di una matrice random H e proporzio-

nale a exp (−a trH2 + b trH + c), con a, b e c costanti reali, nei seguenti casi:

(1) Se H e una matrice random hermitiana e simmetrica, i suoi elementi

Hjk, con j ≤ k, sono statisticamente indipendenti, e P (H) e invariante ri-

spetto a trasformazioni ortogonali reali di H (GOE).

(2) Se H e una matrice random hermitiana, gli elementi Hjj della diagonale

e parte reale e immaginaria degli elementi Hjk, con j < k, sono statistica-

mente indipendenti, e P (H) e invariante rispetto a trasformazioni unitarie

di H (GUE).

(3) Se H e una matrice random hermitiana autoduale, gli elementi della dia-

gonale Hjj e le quattro componenti dei quternioni degli elementi Hjk, con

j < k, sono statisticamente indipendenti e la P (H) e invariante rispetto a

trasformazioni simplettiche di H (GSE).

In tutti i casi considerati, il concetto di invarianza e introdotto sulla base

di considerazioni fisiche e dipendentemente dalle simmetrie relative all’Ha-

miltoniana del sistema in esame. L’indipendenza statistica e stata assunta

per semplicita.

Capitolo 2

Densita di probabilita

congiunta per gli autovalori

Nel capitolo verra ricavata la funzione densita di probabilita congiunta

(j.p.d.f., Joint Probability Density Function) per gli insiemi di matrici gaus-

siani ortogonali (GOE) e unitari (GUE). Verranno esposte alcune proprieta

predicibili dal modello relative agli autovalori, e successivamente si discutera

l’analogia con il gas di Coulomb rispetto alla distribuzione degli stessi.

2.1 GOE

La j.p.d.f. per gli autovalori θ1, θ2,...,θN si puo ottenere esprimendo le

varie componenti di H in funzione dei θj e di altre variabili mutuamente

indipendenti pµ, le quali insieme agli autovalori reali costituiscono un set

completo di parametri indipendenti. La funzione descrive la probabilita che

gli autovalori reali θi e i parametri pµ siano contenuti nel volume multidi-

mensionale∏N

j=1 dθj∏l

µ=1 dpµ, con l numero dei parametri indipendenti. In

una matrice N × N reale e simmetrica il numero di variabili indipendenti

sufficienti ad esplicitare tutti gli elementi Hkj della matrice e N(N + 1)/2. Il

numero di parametri pµ si ricava da

15

16 2. Densita di probabilita congiunta per gli autovalori

l =N(N + 1)

2−N =

N(N − 1)

2(2.1)

Inoltre da (1.31) risulta

trH2 =N∑j=1

θ2j , trH =N∑j=1

θj (2.2)

per cui la densita di probabilita relativa agli N autovalori e ai parametri

indipendenti pµ, intorno ai valori θ1,...,θN e p1,...,pl, si ottiene dalla (1.45)

P (θ1, ..., θN ; p1, ..., pl) = exp

(−a

N∑j=1

θ2j + bN∑j=1

θj + c

)J(θ, p) (2.3)

dove J(θ, p) e lo Jacobiano di H(θ, p), con θ = (θ1, ..., θN) e p = (p1, ..., pl)

J(θ, p) =

∣∣∣∣∂(H11, H12, ..., HNN)

∂(θ1, ..., θN , p1, ..., pl)

∣∣∣∣ (2.4)

il quale e definito in questo caso dal determinante di una matrice di dimen-

sioni N(N + 1)/2 × N(N + 1)/2. Scegliendo i parametri pµ in modo che lo

Jacobiano della (2.4) possa esprimersi come il prodotto di una funzione f

dipendente esclusivamente dai θj e una funzione g dei pµ, la j.p.d.f., ottenu-

ta integrando la (2.3), avrebbe la forma del prodotto dell’esponenziale della

(2.3) con una costante.

Per definire i parametri pµ si ricorda che ogni matrice reale e simmetrica

si puo diagonalizzare con una matrice ortogonale

H = UΘU−1 (2.5)

= UΘUT

2.1 GOE 17

dove Θ e una matrice diagonale in cui compaiono sulla diagonale principale

i θj, e U e una matrice ortogonale

UUT = UTU = 1 (2.6)

le cui colonne rappresentano gli autovettori normalizzati della matrice H, i

quali sono ortonormali in un’opportuna base. Differenziando la (2.6) rispetto

ai pµ

∂UT

∂pµU + UT ∂U

∂pµ= 0 (2.7)

poiche i termini della (2.7) sono l’uno l’hermitiano coniugato dell’altro, la

matrice definita di seguito e antisimmetrica

S(µ) = UT ∂U

∂pµ= −∂U

T

∂pµU (2.8)

Differenziando, invece, la (2.5) sempre rispetto ai pµ

∂H

∂pµ=∂U

∂pµΘUT + UΘ

∂UT

∂pµ(2.9)

moltiplicando a sinistra per UT e a destra per U

UT ∂H

∂pµU = UT ∂U

∂pµΘ + Θ

∂UT

∂pµU (2.10)

= S(µ)Θ−ΘS(µ)

In termini delle sue componenti la (2.10) si scrive

∑jk

∂Hjk

∂pµUjαUkβ = S

(µ)αβ (θβ − θα) (2.11)

18 2. Densita di probabilita congiunta per gli autovalori

Analogamente, differenziando la (2.5) rispetto ai θj

∂H

∂θγ= U

∂Θ

∂θγUT (2.12)

moltiplicando a sinistra per UT e a destra per U ed esprimendo in componenti

∑jk

∂Hjk

∂θγUjαUkβ =

∂Θαβ

∂θγ= δαβδαγ (2.13)

La matrice associata allo Jacobiano puo essere scritta in forma partizionata

[MJ ](θ, p) =

[∂Hjj∂θγ

∂Hjk∂θγ

∂Hjj∂pµ

∂Hjk∂pµ

](2.14)

con indici 1 ≤ j < k ≤ N , γ = 1, ..., N e µ = 1, ..., N(N−1)/2. Moltiplicando

a destra la [MJ ](θ, p) per la matrice

[V ] =

[(UjαUjβ)

(2UjαUkβ)

](2.15)

con 1 ≤ j < k ≤ N e 1 ≤ α ≤ β ≤ N , sfruttando le (2.11) e (2.13)

[MJ ][V ] =

[∂Hjj∂θγ

∂Hjk∂θγ

∂Hjj∂pµ

∂Hjk∂pµ

][(UjαUjβ)

(2UjαUkβ)

]=

[δαβδαγ

S(µ)αβ (θβ − θα)

](2.16)

da cui si ricava calcolando il prodotto di matrici [MJ ][V ][∂Hjj∂θγ

UjαUjβ 2∂Hjk∂θγ

UjαUkβ∂Hjj∂pµ

UjαUjβ 2∂Hjk∂pµ

UjαUkβ

]=

[δαβδαγ

S(µ)αβ (θβ − θα)

](2.17)

Calcolando il determinante di ambo i membri si ricava

J(θ, p) detV =∏α<β

(θβ − θα) det

[δαβδαγ

Sµαβ

](2.18)

2.2 GUE 19

dove si e applicata la formula del determinante di Vandermonde1. Per cui lo

Jacobiano e definito come

J(θ, p) =∏α<β

|θβ − θα|f(p) (2.19)

in quanto sia il detV che il det

[δαβδαγ

Sµαβ

]sono funzioni delle sole pµ. Sosti-

tuendo la (2.19) nella (2.3) e integrando rispetto alle pµ si ottiene l’espressione

della densita di probabilita per gli autovalori θj

P (θ1, ..., θN) = exp

[−

N∑j=1

(aθ2j − bθj − c)

]∏j<k

|θk − θj| (2.20)

Inoltre, traslando l’origine di θ di b2a

e scalando il generico autovalore θj di

un fattore costante√

2a

θj 7−→1√2axj +

b

2a(2.21)

l’espressione (2.20) si puo semplificare, ottenendo

P (x1, ..., xN) = CN1 exp

(−1

2

N∑j=1

x2j

)∏j<k

|xk − xj| (2.22)

dove CN1 e una costante.

2.2 GUE

I risultati ottenuti per il caso ortogonale si possono riprodurre in analogia

a quanto fatto agli insiemi unitari. Oltre agli autovalori reali il numero di

parametri indipendenti pµ sufficienti a fissare univocamente tutti gli elementi

1Si veda l’Appendice B.

20 2. Densita di probabilita congiunta per gli autovalori

di matrice risulta essereN(N−1). Le relazioni (1.31) e (2.3) sono le medesime

anche per gli insiemi unitari, mentre l’espressione dello Jacobiano si adatta

alla struttura degli elementi di matrice

J(θ, p) =

∣∣∣∣∣∂(H(0)11 , ..., H

(0)NN , H

(0)12 , H

(1)12 , ..., H

(0)N−1,N , H

(1)N−1,N)

∂(θ1, ..., θN , p1, ..., pl)

∣∣∣∣∣ (2.23)

dove H(0)jk e H

(1)jk rappresentano rispettivamente la parte reale e immagi-

naria dell’elemento Hjk. Ricordando che per una matrice hermitiana vale

U = U † = (U∗)T e riscrivendo la (2.5) e la (2.6) sostituendo UT con U † si ri-

cavano le seguenti espressioni, relative agli elementi di matrice della derivata

di H fatta rispetto agli autovalori reali θγ e ai parametri indipendenti pµ, in

componenti

∑jk

∂Hjk

∂pµU∗jαUkβ = S

(µ)αβ (θβ − θα) (2.24)

∑jk

∂Hjk

∂θγU∗jαUkβ =

∂Θαβ

∂θγ= δαβδαγ (2.25)

La matrice associata allo Jacobiano si riscrive in forma partizionata come

∂Hjj∂θγ

∂H(0)jk

∂θγ

∂H(1)jk

∂θγ

∂Hjj∂pµ

∂H(0)jk

∂pµ

∂H(1)jk

∂pµ

v w

A(0) B(0)

A(1) B(1)

=

=

[ργα σ

(0)γ,αβ σ

(1)γ,αβ

ε(µ)α S

(0µ)αβ (θβ − θα) S

(1µ)αβ (θβ − θα)

](2.26)

1 ≤ j < k ≤ N

1 ≤ α < β ≤ N

1 ≤ µ ≤ N(N − 1)

1 ≤ γ ≤ N

2.2 GUE 21

dove S(0µ)αβ e S

(1µ)αβ sono la parte reale e immaginaria di S

(µ)αβ . Vengono espli-

citate le dimensioni delle matrici

∂Hjj

∂θγ, v, ρ N ×N

∂H(λ)jk

∂θγ, σ

(λ)γ,αβ N ×N(N − 1)/2

A(λ) N(N − 1)/2×N

∂H(λ)jk

∂pµ, S

(λµ)αβ N(N − 1)×N(N − 1)/2

B(µ) N(N − 1)/2×N(N − 1)

∂Hjj

∂pµ, ε(µ)α N(N − 1)×N

w N ×N(N − 1)

Indipendentemente dalla forma esplicita delle matrici v, w, A(µ), ρ, ε, σ(λ)

l’aspetto rilevante risulta essere l’aver costruito le matrici dalle componenti

della U o alternativamente l’aver differenziato Θ in funzione delle θj avendo

cosı ottenuto una dipendenza dalle sole pµ. Analogamente le matrici Sµ sono

indipendenti dagli autovalori reali. Dunque, considerando il determinante

di ambo i membri si ottiene lo Jacobiano, espresso come prodotto di due

funzioni dipendenti rispettivamente dai θj e dalle pµ separatamente

J(θ, p) =∏α<β

(θβ − θβ)2f(p) (2.27)

la cui espressione se sostituita nella (2.3), integrando rispetto ai pµ permette

di ottenere la densita di probabilita per gli autovalori reali

P (θ1, ..., θN) = exp

[−

N∑j=1

(aθ2j − bθj − c)

]∏j<k

(θk − θj)2 (2.28)

22 2. Densita di probabilita congiunta per gli autovalori

Esattamente come per l’insieme ortogonale, traslando l’origine e scalando per

una quantita costante, l’espressione si semplifica

P (x1, ..., xN) = CN2 exp

(−

N∑j=1

x2j

)∏j<k

(xk − xj)2 (2.29)

I risultati ottenuti possono essere formalizzati enunciando il seguente teore-

ma.

Teorema 2.2.1. La funzione densita di probabilita congiunta (j.p.d.f.) per

gli autovalori delle matrici appartenenti agli insiemi gaussiani ortogonali,

unitari e simplettici e data da

PNβ(x1, ..., xN) = CNβ exp

(−1

2β

N∑j=1

x2j

)∏j<k

(xk − xj)β (2.30)

dove β = 1 se l’insieme e ortogonale, β = 2 se e unitario e β = 4 se e sim-

plettico. La costante CNβ e scelta in modo tale che la PNβ sia normalizzata

all’unita ∫ ∞∞· · ·∫ ∞∞

PNβ(x1, ..., xN)dx1...dxN = 1 (2.31)

L’elemento β viene chiamato indice di Dyson. L’espressione esplicita per

CNβ puo essere calcolata sfruttando l’integrale di Selberg [4] ottenendo

C−1Nβ = (2π)N/2β−N/2−βN(N−1)/4[Γ(1 + β/2)]−NN∏j=1

Γ(1 + βj/2) (2.32)

2.2.1 Analogia con il gas di Coulomb

La forma funzionale della (2.30) non puo che suggerire un’analogia con il

gas di Coulomb. Considerando infatti un sistema di N particelle interagenti

a fissata temperatura T con energia potenziale

V (~r1, ..., ~rN) (2.33)

2.2 GUE 23

la probabilita che esse si trovino in (~r1, ..., ~rN) risulta

P (~r1, ..., ~rN) =1

Ze−βV (~r1,...,~rN ) (2.34)

dove e−βV (~r1,...,~rN ) rappresenta il fattore di Boltzmann e Z la funzione di

partizione definita da

Z =

∫· · ·∫d~r1, ..., d~rNe

−βV (~r1...~rN ) (2.35)

dove l’integrazione e effettuata sulla regione di spazio nella quale sono pre-

senti le particelle. Se il potenziale e espresso nella forma

V (~r1, ..., ~rN) =1

2

N∑i=1

|~ri|2 −∑i<j

ln |~ri − ~rj| (2.36)

le equazioni (2.30) e (2.34) coincidono a meno di un fattore β. Identificando

β = 1kBT

, con kB la costante di Boltzmann, la funzione densita di proba-

bilita congiunta coincide con il fattore di Boltzmann per tre valori diversi

dell’inverso della temperatura. Pensando agli elementi del gas come ad N

distribuzioni lineari di carica su un piano bidimensionale, una carica posta

a distanza ~rj dalla sorgente in ~ri risente di un campo elettrico proporzionale

all’inverso dalla distanza tra le due cariche

Eij(|~ri − ~rj|) ∝1

|~ri − ~rj|(2.37)

sommando su tutte le N componenti e integrando sul dominio spaziale si

ricava

V ∝ −∑i<j

ln |~ri − ~rj| (2.38)

per cui il secondo termine del potenziale e giustificato dall’interazione elet-

trostatica tra componenti. L’interazione caratterizza un sistema di cariche

poste su un piano bidimensionale. Se si considerasse una distribuzione di

cariche nello spazio tridimensionale, il potenziale dipenderebbe dall’inverso

della distanza tra sorgente e carica, e in linea di principio somministrando

una quantita finita di energia si potrebbe portare a distanza infinita la carica

24 2. Densita di probabilita congiunta per gli autovalori

soggetta al potenziale rispetto alla sorgente. Il potenziale logaritmico, invece,

risulta confinante, per cui le cariche non possono mai essere portate mutua-

mente ad una distanza infinita. Gli autovalori reali delle matrici random si

possono immaginare come soggetti a tale potenziale nonostante siano tutti

vincolati a giacere su una retta. Il primo termine del potenziale compare

ipotizzando che le particelle siano immerse in un potenziale armonico.

L’analogia con il gas di Coulomb genera una sorta di univocita concettuale

per cui gli autovalori di una matrice random, appartenenti ad uno degli insie-

mi gaussiani definiti in precedenza, si comportano come se fossero delle par-

ticelle cariche le quali si respingono mutuamente con una forza proporzionale

all’inverso della distanza tra loro.

2.3 Distribuzione degli autovalori

Negli anni sono stati introdotti numerosi strumenti per studiare analitica-

mente le proprieta degli insiemi gaussiani di matrici. In questa breve sezione

si descriveranno qualitativamente alcune di queste proprieta.

Le proprieta delle sequenze di autovalori si suddividono in linea di principio

in due classi: proprieta globali e locali. Le prime mirano ad una descrizione

generale della sequenza tralasciando i dettagli relativi ai singoli autovalori,

mentre le proprieta locali descrivono porzioni della successione e forniscono

informazioni sulla posizione reciproca tra autovalori. Sequenze descritte da

differenti densita medie di autovalori possono presentare idealmente medesi-

me proprieta locali, e viceversa. Nel caso degli insiemi di matrici random, ad

ogni matrice di un insieme gaussiano corrispondera un insieme di autovalori

o alternativamente una sequenza di autovalori. La principale congettura su

cui si basa la teoria delle matrici random riguarda la corrispondenza tra le

proprieta delle sequenze di autovalori relativi a specifici sistemi e le carat-

teristiche globali di un insieme di successioni di autovalori di un opportuno

2.3 Distribuzione degli autovalori 25

insieme di matrici. Prima di descrivere alcune proprieta delle sequenze degli

autovalori reali delle matrici appartenenti agli insiemi gaussiani si descri-

vera uno strumento utile per descrivere statisticamente generiche sequenze

di autovalori indipendentemente dalla natura delle stesse.

2.3.1 Spaziatura tra autovalori

Che si tratti di sequenze di autovalori casuali, sequenze di numeri pri-

mi, o risonanze neutroniche, o ancora la successione degli zeri della funzione

ζ di Riemann sulla retta Rez = 1/2, alcune proprieta statistiche sono co-

muni a tutte le successioni, indipendentemente dalla diversa densita degli

autovalori. Facendo riferimento ad una eventuale sequenza di livelli energe-

tici, si consideri la successione E1 ≤ E2 ≤ E3 ≤ ... contenuta nell’intervallo

δE. Se Si = Ei+1 − Ei, cioe se Si rappresenta la distanza relativa tra livelli

consecutivi, con i = 1, 2, ...N , e D il valor medio∑

i Si/N , definendo

si =SiD

(2.39)

si introduce naturalmente la densita di probabilita p(s), tale per cui p(s)ds

rappresenta la probabilita che si sia compreso tra s e s+ ds. Nel caso in cui

i livelli non siano correlati tra di loro, dividendo s in n intervalli di uguale

ampiezza p(s)ds si puo esprimere come

p(s)ds = limn→∞

(1− s

n

)n= e−sds, (2.40)

la quale prende il nome di distribuzione di Poisson.

Empiricamente, fu facile constatare quanto questa distribuzione di pro-

babilita si discostasse da quella seguita dai livelli energetici nucleari a fissati

spin e parita, cosı come differiva significativamente da quella degli autovalo-

ri di matrici random hermitiane a valori reali (cf. Fig. 2.1). Si considero,

inoltre, come la distribuzione di probabilita degli autovalori di tali matrici

fosse consistente con quella dei livelli energetici nucleari; analogamente, fu

osservato che molti altri sistemi fisici seguivano tale distribuzione di proba-

bilita, come ad esempio il biliardo di Sinai, o un atomo di idrogeno immerso

26 2. Densita di probabilita congiunta per gli autovalori

Figura 2.1: Si puo notare come la distribuzione di Poisson non sia quella seguitadagli autovalori di una matrice simmetrica a valori reali (GOE), ne approssimiopportunamente l’istogramma, relativo ad un insieme sufficientemente grande dilivelli energetici, associati a 27 nuclei differenti [9].

in un intenso campo magnetico. Oltre a questi sistemi fisici, ce ne sono molti

altri che seguono una distribuzione di probabilita lecitamente approssimabile

a quella degli autovalori di una matrice hermitiana a valori reali, lasciando

ipotizzare una sorta di universalita della distribuzione dei livelli energetici

dei sistemi complessi e non integrabili.

2.3.2 Wigner surmise

Wigner, osservando l’andamento dei dati sperimentali, relativi ai livelli

energetici di nuclei atomici, formulo una congettura, nota come “Wigner

surmise”, rispetto all’espressione di p(s). Per insiemi di matrici ortogonali

(GOE) ipotizzo che la forma della funzione potesse essere la seguente

pW1(s) =π

2se−

π4s2 (2.41)

Come esposto in [4], in seguito venne definita una soluzione esplicita per

la distribuzione degli autovalori delle matrici di insiemi ortogonali (GOE),

tale soluzione sorprendentemente presenta un andamento analogo a quello

previsto dal “Wigner surmise” (cf. Fig. 2.2). Anche per gli insiemi (GUE) e

(GSE) formulo delle ipotesi ottenendo degli ottimi risultati, in accordo alle

attuali soluzioni analitiche, di seguito si riportano le due espressioni

2.3 Distribuzione degli autovalori 27

pW2(s) = 32π2 s

2e−4πs2

pW4(s) = 218

36π3 s4e−

649πs2

(2.42)

I coefficienti numerici della (2.41) e delle (2.42) vennero introdoti in modo

tale da rendere le espressioni normalizzabili

∫ ∞0

pWβ(s)ds = 1 (2.43)

e valesse per il valore medio∫ ∞0

spWβ(s)ds = 1. (2.44)

con β = 1, 2, 4.

Figura 2.2: Si osserva un ottimo accordo tra le due distribuzioni nonostante sianostate ottenute su premesse diverse [10].

E possibile generalizzare le espressioni congetturate da Wigner [11] con

pβ(s) = aβsβe−bβs

2

(2.45)

con i valori di aβ e bβ definiti dalle

28 2. Densita di probabilita congiunta per gli autovalori

aβ(s) = 2Γβ+1

(β+22

)Γβ+1

(β+12

) (2.46)

bβ(s) =Γ2(β+22

)Γ2(β+12

)

Figura 2.3: Andamento delle Wigner surmises per i tre insiemi gaussiani.

2.3.3 Densita degli stati

Un’altra proprieta relativa agli autovalori di una matrici random riguar-

da la densita degli stati σ(x). Attraverso la (2.30) e possibile calcolare la

probabilita P (x1, ..., xN) che il set di autovalori della matrice si trovi in un

intorno infinitesimo di x1, ..., xN . La densita dei livelli

σ(x) = N

∫ ∞−∞· · ·∫ ∞−∞

P (x, x2, ..., xN)dx2...dxN (2.47)

puo essere calcolata per ogni valore di N tramite integrazione. La soluzione

del problema e non banale, ma puo essere affrontata analiticamente attraver-

so diversi approcci quali, ad esempio, il metodo del punto a sella, il metodo

dei polinomi ortogonali o attraverso il calcolo supersimmetrico [4]. Nel segui-

to si semplifichera il problema considerando il limite per N → ∞, in modo

che il corrispondente gas di Coulomb si possa considerare come un fluido

2.3 Distribuzione degli autovalori 29

classico con una densita macroscopica continua. Piu precisamente valgono i

seguenti due assunti:

(1) L’energia potenziale V data dalla (2.36) puo essere approssimata dal

funzionale

V (σ) =1

2

∫ ∞−∞

dxx2σ(x)− 1

2

∫ ∞−∞

dxdyσ(x)σ(y) ln |x− y|. (2.48)

(2) La densita dei livelli sara tale da minimizzare la (2.48), con il vincolo

∫ ∞−∞

dxσ(x) = N (2.49)

e con

σ(x) ≥ 0. (2.50)

Il primo termine dell’integrale riproduce, nel limite di N →∞, esattamente

la sommatoria del primo termine della (2.36). Non si puo dire esattamente la

stessa cosa per il secondo integrale, in quanto sono stati trascurati eventuali

correlazioni relative all’interazione tra primi vicini; nonostante cio nel limite

di N grande tali correlazioni si possono considerare trascurabili.

Per trovare i punti stazionari del funzionale V (σ) ci si riconduce all’equazione

integrale

−1

2x2 +

∫ ∞−∞

dyσ(y) ln |x− y| = C (2.51)

dove C e una costante di Lagrange. Differenziando rispetto a x e conside-

rando la parte principale dell’integrale1 si ricava

P

∫ ∞−∞

dyσ(y)

x− y= x (2.52)

nel seguito non si risolvera analiticamente il problema ma verra fornito di-

rettamente il risultato. Considerando

1Per parte principale si intende limε→0

(∫ x−ε−∞ dy +

∫∞x+ε

dy)σ(y) ln |x− y|.

30 2. Densita di probabilita congiunta per gli autovalori

σ(y) =

C(A2 − y2)1/2, |y| < A

0, |y| > A(2.53)

dalla (2.52) si ricava

C =1

π(2.54)

e dalla (2.49)

1

π

π

2A2 = N (2.55)

Per cui, considerando come variabile indipendente la x, la (2.53) si scrive

come

σ(x) =

1π(2N − x2)1/2, |x| < (2N)1/2

0, |x| > (2N)1/2(2.56)

dove x denota la posizione degli autovalori di una matrice hermitiana di

dimensioni N×N di un insieme gaussiano. La densita σ(x) fornisce il numero

medio di livelli in un intervallo di ampiezza dx centrato in x quando N →∞.

Figura 2.4: Legge del semicerchio ricavata da Wigner. Essa esprime la den-sita media dei livelli di una sequenza di autovalori di una matrice di un insiemegaussiano. Gli assi sono scalati opportunamente.

2.3 Distribuzione degli autovalori 31

La forma della densita σ(x) dell’equazione (2.56) e la ragione per cui il

risultato e noto come “legge del semicerchio” (dall’inglese semicircle law, cf.

Fig. 2.4).

2.3.4 Riepilogo

Sulla base degli insiemi gaussiani di matrici hermitiane random introdotti

nel Capitolo 1, si e derivata la funzione densita di probabilita congiunta

ottenendo proporzionalita con il fattore

∏1≤j<k≤N

|xk − xj|β exp

(−1

2β

N∑j=1

x2j

)(2.57)

dove β dipende dall’insieme considerato. Si e considerata, inoltre, l’analo-

gia con il gas di Coulomb in termini della forma funzionale, in particolare

il fattore di Boltzmann per un gas di particelle interagenti coincide a meno

di β alla densita di probabilita congiunta relativa agli autovalori di un in-

sieme di matrici random. Inoltre, e stata esposta la congettura di Wigner

(Wigner surmise), la quale nel caso di matrici random dell’insieme gaussiano

ortogonale (GOE) risulta essere

pW1(s) =π

2se−

π4s2 (2.58)

Si e enunciata la legge del semicerchio relativa alla densita media degli

autovalori di una matrice random

σ(x) =

1π(2N − x2)1/2, |x| < (2N)1/2

0, |x| > (2N)1/2(2.59)

Capitolo 3

Applicazioni

In questo capitolo si discutera la compatibilita di alcuni fenomeni con le

previsioni della teoria delle matrici random, soffermandosi sull’universalita

della stessa. In particolare, nella prima parte, si osservera come essa sia

applicabile a contesti apparentemente diversi ottenendo risultati notevoli.

Una seconda parte verra invece dedicata all’attuale tema del “car parking”.

3.1 RMT in fisica

Il campo di applicabilita della teoria delle matrici random risulta essere

molto ampio ed eterogeneo in termini di domini fenomenologici. Nei prossimi

paragrafi verranno enumerate soltanto alcune delle moltissime applicazioni

in cui la teoria trova applicazione, cercando di seguire l’evoluzione storica.

3.1.1 Fisica Nucleare

Come gia menzionato in precedenza, fu nel contesto della fisica nucleare

che la teoria delle matrici random venne per la prima volta applicata in fisi-

ca, da parte di Wigner. Inoltre, i dati raccolti all’inizio della seconda meta

del ’900 fornirono verifiche empiriche rispetto alle previsioni della teoria. Nel

1960 Porter e Rosenzweig [8] confrontarono i livelli energetici relativi a di-

versi nuclei con la distribuzione relativa alla spaziatura dei livelli prevista dal

33

34 3. Applicazioni

GOE. Come si puo facilmente osservare dalla Fig. 3.1, l’aumento della com-

plessita del sistema e indicativo rispetto alla convergenza alla distribuzione

degli autovalori di matrici random.

Figura 3.1: Diagrammi relativi alla spaziatura dei primi vicini per diversi assor-timenti di nuclei atomici. Le tre categorie differiscono per le dimensioni dei nucleipartendo da nuclei di piccole (a), medie (b) e grandi (c) dimensioni. Si osservacome le distribuzioni relative a nuclei di piccole dimensioni siano consistenti con unandamento poissoniano mentre all’aumentare della dimensione i dati converganoal GOE.

3.1.2 Spettro dell’operatore di Dirac in QCD

Negli ultimi anni la RMT e stata applicata con successo anche in cromo-

dinamica quantistica1 (QCD, quantum chromodynamics).

1Per i dettagli si vedano [12, 13].

3.1 RMT in fisica 35

La QCD e la teoria che, nel Modello Standard delle particelle elementari,

descrive le interazioni forti tra i componenti dei nucleoni: quark e gluoni.

Essa postula che queste particelle abbiano un grado di liberta interno di

“colore”, e si basa sull’invarianza locale (ovvero di “gauge”) rispetto a tra-

sformazioni nel gruppo SU(3) del “colore”. La QCD e una teoria quantistica

e relativistica e, in quanto tale, si basa sulla “seconda quantizzazione”: la

teoria non prevede una descrizione in termini della funzione d’onda di una

singola particella, bensı di un numero intero arbitrario di particelle (e anti-

particelle) e la quantizzazione dei campi che le descrivono. Nel formalismo

degli “integrali di cammino” di Feynman, l’evoluzione quantistica di quark e

gluoni e descritta dall’integrale funzionale

Z =

∫DADΨDΨ exp

(i

}

∫dt

∫d3xL[A,Ψ, Ψ]

)(3.1)

dove L e la “densita lagrangiana”, funzione dei campi A (campi vettoriali

che descrivono i gluoni), Ψ e Ψ (campi di spin 1/2 che descrivono quark e

antiquark); queste sono funzioni dello spazio e del tempo, e gli integrali DA,

DΨ e DΨ sono integrali funzionali. Nella densita lagrangiana L, l’interazione

tra i gluoni e i quark e descritta da un termine del tipo:

∑f

Ψf (x, t)[iγµ(∂µ − igAµ)−mf ]Ψf (x, t), (3.2)

dove l’indice f denota i vari tipi (o “sapori”) di quark (up, down, strange,

charm, bottom e top), di massa mf , mentre g e la costante di accoppiamento

dell’interazione forte e le γµ sono le quattro matrici gamma di Dirac. La

quantita tra parentesi quadre e l’operatore di Dirac: nel “limite chirale”

mf → 0 (che e una buona approssimazione per i quark piu leggeri, up e

down, e in una certa misura anche per lo strange) esso si riduce a:

iγµ(∂µ − igAµ)def= iγµDµ

def= i /D (3.3)

36 3. Applicazioni

dove Dµ = ∂µ − igAµ e la “derivata covariante”, e la notazione /D indica la

sua contrazione con le matrici gamma.

Figura 3.2: Distribuzione degli autovalori piccoli dell’operatore di Dirac per quat-tro diverse dimensioni del reticolo [14]. La curva in rosso rappresenta l’istogrammarelativo ai dati della simulazione numerica su reticolo mentre la curva tratteggiatale predizioni della RMT.

Al fine di dare una definizione matematicamente rigorosa e generale di Z

si puo “regolarizzare” la teoria su un reticolo quadridimensionale, sostituendo

lo spazio-tempo continuo con una griglia di punti discreti. Questo permette

anche di studiare Z numericamente, mediante calcoli con un elaboratore.

Tali calcoli permettono, tra l’altro, di studiare esplicitamente l’operatore di

Dirac nel limite chirale. Considerazioni generali sulle sue simmetrie globali

suggeriscono che esso possa essere modellizzato in termini di matrici random

con una struttura a blocchi del tipo

3.1 RMT in fisica 37

[0 W

W † 0

](3.4)

(“chiral gaussian unitary ensemble”) e che i suoi autovalori siano compatibili

con le previsioni del GUE. Queste previsioni sono effettivamente confermate

da studi numerici su reticolo (cf. Fig. 3.2).

3.1.3 Funzione ζ di Riemann

La funzione ζ di Riemann riveste fondamentale importanza nella teoria

analitica dei numeri e presenta notevoli risvolti in fisica, teoria delle proba-

bilita e statistica. Erano gia stati ottenuti dei risultati riguardo alla funzione

nel diciottesimo secolo, da Leonhard Euler, ma il riferimento a Bernhard Rie-

mann risulta giustificato dalla sua celebre congettura, pubblicata nel 1858 in

Uber die Anzahl der Primzahlen unter einer gegebenen Grosse, sull’eventuale

relazione tra numeri primi e la distribuzione degli zeri della funzione.

Figura 3.3: Grafico del modulo della funzione di Riemann ζ(a+ib) per 0 ≤ a ≤ 3e 0.1 ≤ b ≤ 200.

La funzione Zeta di Riemann e definita dalla serie

38 3. Applicazioni

ζ(z) =∞∑n=1

1

nz(3.5)

dove z ∈ C con Rez > 1. Per altri valori di z la funzione ζ e definita per

continuazione analitica. Fu nel 1876 che Riemann formulo la sua congettura

sulla distribuzione degli zeri non banali. In particolare egli suppose che “La

parte reale di ogni radice non banale e 1/2”, dunque, dovrebbero trovarsi

tutte su una retta, detta “linea critica”, parametrizzata come

z =1

2+ iγn (3.6)

con γn ∈ R. La successione dei γn avra la forma di una sequenza di numeri

reali, con n ∈ N. In Fig. 3.4. e mostrato l’andamento della spaziatura tra

primi vicini per la sequeza dei {γn}n∈[1022,1022+104]. Il confronto dell’istogram-

ma delle frequenze con la distribuzione (GUE) mostra una compatibilita

accentuata tra le due distribuzioni. Risulta, dunque, ragionevole suppor-

re che l’andamento degli zeri non banali della funzione ζ di Riemann sia

statisticamente descritto da un insieme gaussiano unitario (GUE).

Figura 3.4: Istogramma delle frequenze della spaziatura dei primi vicini prodottoconsiderando la sequenza della parte complessa di 10000 zeri non banali dellafunzione ζ di Riemann.

3.1 RMT in fisica 39

3.1.4 Quantum Chaos

Nel 1984, Bohigas, Giannoni e Schmit [15] formularono una congettura

mediante la quale esposero una corrispondenza tra la descrizione dei sistemi

caotici e la teoria delle matrici random. Per caotico si intende un sistema

in cui traiettorie che caratterizzano il moto, inizialmente vicine, divergono

esponenzialmente le une dalle altre al trascorrere del tempo. La RMT ini-

zialmente venne considerata nel contesto dei sistemi multi-particelle con un

grande numero di gradi di liberta, dunque potrebbe risultare peculiare con-

frontare le proprieta statistiche ottenute dalla stessa rispetto a sistemi caotici

con, ad esempio, soltanto due gradi di liberta.

Una particella libera di muoversi su di un piano, senza attrito e vincola-

ta all’interno di un dominio finito rispetto al quale puo urtare elasticamente,

sotto opportune condizioni a contorno, puo rappresentare un sistema caotico.

Costruendo biliardi con superfici diverse si possono realizzare praticamente

configurazioni caotiche per una particella libera.

Figura 3.5: Biliardi di forme diverse. In alto a destra lo stadio di Bunimovich,il biliardo di Sinai in alto a destra, la lumaca Pascaliana (o biliardo a forma dicardioide) in basso a sinistra e in basso a destra il biliardo anulare.

40 3. Applicazioni

Considerando ad esempio i biliardi di Sinai e a forma di cardioide, i li-

velli energetici del sistema quantistico corrispondente dovrebbero in linea di

principio aderire alla statistica del GOE. In [16] e [17] vengono illustrate

alcune distribuzioni relative alla spaziatura tra autovalori dei sistemi mec-

canici quantistici analoghi a specifiche configurazioni delle superfici. Se la

configurazione del biliardo e circolare i livelli energetici del modello quanti-

stico analogo (confinamento di una particella libera all’interno di un dominio

della stessa forma) presentano un andamento poissoniano, mentre nel caso

del dominio a forma di cardioide la densita relativa alla spaziatura tra i livelli

converge al GOE (cf. Fig. 3.6).

Figura 3.6: Sono rappresentati due istogrammi di frequenze inerenti alla spazia-tura tra primi vicini degli autovalori di una hamiltoniana che descrive un particellalibera in un dominio bidimensionale finito. A sinistra, imponendo condizioni alcontorno circolari si osserva come la distribuzione di Poisson descriva bene l’anda-mento dei dati, e stato mostrato che la considerazione in generale vale per i sistemiquantistici integrabili [17]. La descrizione del moto balistico di una particella, in cuivengono imposte condizioni a contorno relative alla forma a cardioide del dominio(a destra), e il suo analogo quantistico, vengono approssimate dalla statistica pre-vista dal GOE (in accordo a quanto congetturato da Bohigas, Giannoni e Schmit[15]).

3.1.5 Gravita quantistica

La teoria delle matrici random trova applicazione anche in gravita quanti-

stica nell’ambito dei modelli topologici. In particolare la teoria delle stringhe

3.1 RMT in fisica 41

fornisce una connessione con la RMT inerentemente alle superfici random

(c.f. Fig. 3.7, per maggiori dettagli si veda [18]). Si consideri uno spazio d-

dimensionale nel quale le funzioni Xµ(ξ0, ξ1), con µ = 1, ..., d, parametrizzano

la posizione delle stringhe su di un piano bidimensionale. Per la descrizione

dinamica delle stringhe risulta conveniente usare l’azione di Polyakov per la

stringa

S =1

2

∫d2ξ√|g|gαβ∂αXµ∂βXµ (3.7)

dove gαβ(ξ0, ξ1) con α = 0, 1 rappresenta il campo gravitazionale a due di-

mensioni. La funzione di partizione dell’azione di una stringa e data dal

seguente integrale funzionale

Z =

∫DX

∫Dg exp (−S) (3.8)

il quale puo essere risolto numericamente ricorrendo ad una discretizzazione

della superficie rispetto alla quale viene effettuata l’integrazione. E in questo

contesto che la teoria delle matrici random si applica, descrivendo alcune

proprieta delle superfici random.

Figura 3.7: Triangolazione random di un toro (sinistra). Porzione di superficiedel toro e rappresentazione del reticolo duale (destra).

42 3. Applicazioni

3.1.6 Altre applicazioni

Numerosi sono i campi in cui la teoria si applica. Oltre a quelli citati

si ricordano la finanza, nella quale la RMT viene applicata per descrivere

il rumore di campionamento in matrici di correlazione finanziarie, le neuro-

scienze, dove le matrici random vengono sfruttate per modellizzare la rete di

connessioni sinaptiche tra neuroni nel cervello, l’ottimizzazione dei sistemi di

trasmissione nell’ambito della teoria della comunicazione e molti altri.

3.2 Car parking

Il car parking problem indica il fenomeno relativo alla distribuzione e

all’ampiezza delle spaziature tra vetture contigue in un parcheggio. Le pro-

prieta teoriche del car parking vennero introdotte attraverso modelli iterativi,

in particolare mediante il modello di assorbimento sequenziale casuale, me-

glio noto in letteratura come il “random car parking model”. Il processo

di selezione casuale consiste nel considerare ogni auto partecipante indipen-

dente dalle altre e avente lunghezza l0. Sia L la lunghezza della strada con

L � l0. Il primo step consiste semplicemente nel selezionare casualmente

una posizione x sulla strada. Se l’intervallo (x − l0/2, x + l0/2) non e occu-

pato, l’auto puo essere parcheggiata corrispondentemente all’intervallo. Se

invece l’intervallo e gia occupato, dev’essere scelto casualmente un altro x′.

Quando il numero di auto parcheggiate raggiungera un certo limite critico,

tale per cui non siano presenti intervalli liberi di lunghezza l0, non potranno

essere aggiunte ulteriori vetture. Nel limite in cui L → ∞ e stato prova-

to da Renyi [19] che il limite critico si raggiunge quando N = qL/l0 con

q = 0.74759.... La distanza media tra auto nel caso di saturazione risulta

D = l0(1 − q)/q ≈ 0.3376...l0. Nel seguito si riprodurra il modello descritto

da Seba in [20].

3.2 Car parking 43

3.2.1 Modellizzazione dei dati empirici

Una quantita di dati significativi vennero raccolti da Rawal e Rodgers

[21] nel centro di Londra. Ci si accorse di come essi si discostassero si-

gnificativamente dalla distribuzione della distanza tra primi vicini ottenuta

teoricamente tramite il modello del parcheggio casuale. Nel caso continuo il

modello prevedeva un andamento per la distribuzione delle spaziature P (D)

come

P (D) ≈ 0.4217[1− 2 lnD − (1−D)(1.379− 0.365D)] (3.9)

per D piccolo. Di conseguenza l’espressione diverge, ovvero P (D) → ∞ se

D → 0. I dati empirici raccolti nel contesto londinese dimostrano chiaramen-

te come P (D)→ 0 quando D → 0. Inoltre, Abul-Magd [22] mise in evidenza

come la distribuzione spaziale delle cariche di un gas monodimensionale di

particelle interagenti in equilibrio termico, e di conseguenza la distribuzione

degli autovalori di un insieme di matrici random, ben descriva l’andamento

dei dati raccolti. A differenza dell’approccio di Abul-Magd al problema, il

quale anticipo si potesse supporre un’interazione effettiva tra vetture (poten-

ziale repulsivo logaritmico −∑

i<j ln |xi − xj|, nel limite di distanze piccole),

Rawal e Rodgers sfruttarono un modello basato sull’assorbimento casuale che

non prevedeva in una sua prima versione particolari interazioni tra le auto.

Nuove misure hanno portato a concludere che non sia possibile definire dei

risultati universalmente validi. In [20] si osserva, sulla base dei dati raccolti

in Repubblica Ceca, come la situazione relativa al traffico implichi una dif-

ferenziazione per strada delle distribuzioni delle spaziature tra vetture. Lo

stesso fenomeno e stato osservato a Ann Arbor (USA) [23] dove si e dimo-

strato che l’indice di Dyson dipende dalla strada considerata.

Diversamente dal modello di Abul-Magd [22], quello proposto di seguito non

prevede vengano premesse interazioni effettive tra le vetture. Si considerino

auto di medesima lunghezza l0, le quali vengono parcheggiate in una strada

di lunghezza L, dove L � l0. Sia Xi la posizione del centro dell’i-esima

vettura, inoltre le auto siano contate partendo da destra in modo tale che

44 3. Applicazioni

Figura 3.8: Istogramma delle frequenze dei dati raccolti da Rawal e Rodgers

[21], relativo alla distribuzione delle gaps che intervallano vetture contigue, con-

frontato con la distribuzione delle spaziature del GUE (curva continua). La linea

tratteggiata e ricavata dal model B della referenza [21].

Xi+1 > Xi. Se una macchina esce dal parcheggio oppure una ulteriore viene

parcheggiata, le posizioni delle auto Xi vanno riassegnate. Il modello si basa

su step temporali discreti. Si comincia con due auto parcheggiate, rispetti-

vamente all’inizio e alla fine della strada: X1 = 0 e X2 = L. Si suppone che

le due auto poste alle estremita del parcheggio non si muovano durante gli

step iterativi. Tutte le altre automobili partecipano nel modello. Ogni step

si puo sintetizzare in due parti:

Parte 1. Una vettura arriva nei pressi della strada e tenta di parcheggiare.

La lunghezza degli slot e data da Dk = Xk+1−Xk− l0. Di conseguenza, una

vettura di lunghezza l0 potra parcheggiare nello slot Dk soltanto se Dk > l0.

Se lo slot e disponibile l’auto puo parcheggiare arbitrariamente all’interno

dello stesso, scegliendo una posizione a cui ci si riferisce con l’indice k0. La

posizione nella quale la vettura verra parcheggiata si puo descrivere mediante

X = Xk0 + l0 + a(Dk0 − l0) (3.10)

3.2 Car parking 45

dove a ∈ (0, 1) assume valori casuali rispetto alla distribuzione P (a). Si

distinguono tre casi: X = Xk0 + l0, a = 0

X = 12(Xk0+1 −Xk0), a = 1

2

X = Xk0+1 − l0, a = 1

(3.11)

i quali corrispondono rispettivamente al caso in cui l’auto sia posizionata

all’estremo destro dello slot, al centro o a sinistra. Se non ci sono slot dispo-

nibili la parte 1 del processo viene saltata.

Parte 2. Ogni vettura esce dal parcheggio con probabilita p. Se non ci

sono altre macchine parcheggiate oltre a quelle posizionate alle estremita

X = 0 e X = L del dominio questo step viene saltato.

Il numero massimo di auto nel parcheggio risulta essere Nmax = L/l0. Se

Np > 1 piu di un’auto puo partire dal parcheggio durante uno step iterati-

vo e il numero massimo di macchine parcheggiate fluttua intorno al valore

massimo N = 1/p. Si e interessati pero al caso in cui N ≈ Nmax, per cui

p ≤ 1/L. La funzione P (a) rappresenta la tendenza dell’utente a posizionarsi

in una specifica coordinata all’interno dello slot. Se P (a) tende ad δ(a−1/2)

le auto parcheggeranno con probabilita accentuata al centro dello slot. Nel

seguito si assumeranno le seguenti condizioni:

(1) La funzione P (a) risulta simmetrica P (a) = P (1− a).

(2) Tutti gli slot sono occupati. Una vettura puo essere parcheggiata solo

quando un’altra auto parte dal parcheggio.

(3) Il modello descrive uno stato di equilibrio in cui non varia la distribuzione

delle spaziature nel tempo.

(4) Per semplificare la trattazione non si considereranno casi in cui piu di

un’auto esca dal parcheggio.

46 3. Applicazioni

Si consideri il caso in cui le auto parcheggiate siano tre, le cui posizioni

sono individuate rispettivamente da Xn+1, Xn e Xn−1. Si possono definire

due spaziature di lunghezza D1 = Xn − Xn−1 − l0 e D2 = Xn+1 − Xn − l0.Si supponga che la vettura in Xn esca dallo slot relativo. Le due spaziature

convergono ad un unico slot di ampiezza

D = D1 +D2 + l0 (3.12)

Quando un’altra auto parcheggia nello slot di ampiezza D, tale intervallo

viene suddiviso in due nuove spaziature D1 = a(D−l0) e D2 = (1−a)(D−l0).Sostituendo nelle due espressioni la (3.12) si ottieneD1 = a(D1 +D2)

D2 = (1− a)(D1 +D2)(3.13)

Per la simmetria della funzione P (a) le variabili a e 1 − a presentano la

medesima distribuzione di probabilita. Dopo alcuni step la vettura in Xn+1

esce dal parcheggio e viene sostituita da un’altra macchina. Questo rom-

pe l’indipendenza statistica di a e 1 − a per cui si puo scrivere per le due

spaziature D1 , a(D1 +D2)

D2 , b(D1 +D2)(3.14)

dove a e b sono due variabili random mutuamente indipendenti con la me-

desima distribuzione di probabilita. Le variabili D1, D2, D1 e D2 sono con-

siderate come copie statisticamente indipendenti delle spaziature tra le auto

e il simbolo , indica che la distribuzione di probabilita per il membro di

sinistra e la medesima per quello di destra. Le (3.14) si dicono distribu-

tional fixed point equations e sono state studiate esaustivamente nell’am-

bito della teoria dei numeri (vedere per esempio [24, 25]). La soluzione si

puo esprimere iterativamente. Inserendo l’espressione di D2 in D1 si ottiene

D1 , a1(D1 + a2(D1 + a3(D1 + ...))) dalla quale esplicitando la D1 si ricava

D1 , a1 + a1a2 + a1a2a3 + a1a2a3a4 + ... (3.15)

3.2 Car parking 47

dove a1, a2, a3, a4,... sono statisticamente indipendenti con medesima di-

stribuzione di probabilita P (a). Un’equazione analoga si ottiene per D2. La

relazione (3.15) si puo riscrivere come [26]

D , a(D + 1) (3.16)

Si osserva che le relazioni (3.14) non dipendono da l0, per cui il modello e

valido indipendentemente dalla lunghezza l0 delle vetture.

3.2.2 Risultati

Non e uno degli obiettivi dell’elaborato descrivere i dettagli relativi al-

la soluzione analitica mediante la quale si esplicita una funzione densita di

probabilita per D. La soluzione per le equazioni (3.15) e (3.16), quando a

e una variabile random in [0, 1] indipendente ed identicamente distribuita

(i.i.d, independent and identically distributed), e descritta dalla distribuzio-

ne di Dickman. Come risulta evidente (cf. Fig. 3.9) la distribuzione presenta

un andamento costante ρ(D) ≈ 0.5614... per D < 1.

Figura 3.9: Distribuzione di Dickman.

Nonostante possa risultare singolare la connessione tra la teoria dei nume-

ri e le spaziature dei primi vicini nel contesto del car parking, la distribuzione

48 3. Applicazioni

presenta un’ambiguita rispetto all’eventuale distribuzione effettiva delle vet-

ture. Infatti, ci si aspetta che sia nulla la probabilita che due vetture siano

immediatamente contigue, o presentino mutuamente spaziature tendenti a

zero, affinche sia garantito lo spazio sufficiente per le manovre. Oltre all’ana-

logia con la distribuzione di Dickman si e osservato che l’equazione (3.16) si

puo considerare legata ad una certa classe di equazioni differenziali note come

equazioni differenziali di Dickman. Sotto opportune condizioni relativamente

alla distribuzione di probabilita per a, le equazioni descrivono l’evoluzione

della densita ρ(D). Le equazioni si ricavano definendo una funzione di di-

stribuzione cumulativa1 R(t) di D e considerando P (a) = 6a(1 − a) (detta

distribuzione β(2, 2))

t3d2

dt2

(ρ(t)

t

)= 6ρ(t− 1) (3.17)

L’equazione differenziale non ammette una soluzione analitica ma puo essere

risolta iterativamente dividendo il dominio su cui varia la variabile indipen-

dente. Per t ∈ [0, 1] si ha ρ(t−1) = 0 (non sono previste spaziature negative)

per cui la soluzione per ρ(t) = c1t + c2t2, con c1 e c2 costanti. Ricavando la

soluzione per ρ(t− 1) e sostituendola nell’equazione differenziale, si definisce

una soluzione per l’intervallo t ∈ [1, 2]

ρ(t) = 3(c2 − c1) + 3(2c2 − c1)t ln (t) + 6c2t2(ln (t)− 1) + c3t

2 + c4t (3.18)

dove le costanti c3 e c4 si ricavano imponendo la continuita di ρ(t) e ρ′(t) in

t = 1, rispettivamente c3 = 3c1−8c2 e c4 = c1+12c2. Iterando per i successivi

intervalli di t si ottengono sempre costanti che dipendono da quelle definite

nello step precedente, per cui la soluzione e completamente determinata da

c1 e c2. La corrispondenza tra l’andamento della ρ e le soluzioni analitiche

degli insiemi GOE e GUE e sorprendente (cf. Fig. 3.10).

Il risultato garantisce una relazione tra la teoria delle matrici random e

la soluzione di equazioni analoghe alla (3.16). Le considerazioni vanno ben

1La funzione di distribuzione cumulativa e definita come R(t) := prob[D ≤ t] =∫ t0ρ(s)ds. Per maggiori dettagli su come si possano derivare le equazioni differenziali

di Dickman si veda l’Appendice C.

3.2 Car parking 49

Figura 3.10: Le soluzioni ottenute dall’equazione differenziale (3.17) (curva con-

tinua) per P (a) = β(2, 2) sono praticamente indistinguibili dalla distribuzione re-

lativa alla spaziatura dei livelli del GOE. Scegliendo P (a) = β(3.3, 3.3) la soluzione

converge al GUE.

oltre il dominio del car parking, l’equazione descrive il processo dello “split-

and-merge” caratteristico di una serie di altri fenomeni quali i processi di

Poisson-Dirichelet (processi stocastici che simulano il manifestarsi di eventi

che siano indipendenti l’uno dall’altro e che accadano continuamente nel tem-

po), la distribuzione GEM (studio di variabili aleatorie), la ricombinazione

genomica, ed altri (per maggiori dettagli si vedano ad esempio [27-31]).

Ritornando al problema dei parcheggi, in [20] sono esposti i dati sperimenta-

li raccolti in due strade differenti nel centro di Hradec Kralove (Repubblica

Ceca). Una delle due strade e a doppio senso di marcia e le auto vengono

parcheggiate sul lato destro della strada, mentre la seconda e a senso unico

e le vetture vengono parcheggiate sul lato sinistro. Sono state effettuate per

entrambi i casi 1200 misure. Si e osservato come sia piu semplice parcheggia-

re sul lato sinistro, in quanto si ha una visibilita migliore sulla ruota motrice,

per cui la P (a) dipende in una certa misura dalla locazione del parcheggio.

In generale si puo supporre che nei parcheggi sul lato sinistro della strada

50 3. Applicazioni

le utenze siano disposte a sfruttare anche slots mediamente piu stretti. In

Figura 3.11: I dati relativi ai parcheggi sul lato destro della strada (croci)

confrontati con le previsioni del GUE (linea tratteggiata) e con la soluzione del-

l’equazione (3.16) ottenuta con la distribuzione di probabilita P (a) plottata a

fianco.

Fig. 3.11 e 3.12 e mostrato il confronto dei dati sperimentali con l’andamento

previsto dai GOE, GUE e dal modello iterativo illustrato nella prima par-

te. Nonostante l’accordo dei dati con la teoria delle matrici random non sia

perfetto, si osserva comunque come esso sia migliore rispetto alle soluzioni

ottenute tramite il modello iterativo. Nei due casi per definire le P (a) si e

fatto riferimento all’intervallo a ∈ (0, 0.5). La prima distribuzione e definita

da

P (a) ≈ a

(0.5− a)α(3.19)

con α = 0.2, la distribuzione mostra chiaramente una singolarita in a = 0.5.

Nel secondo caso la distribuzione risulta avere una forma approssimativa-

mente triangolare P (a) ≈ aα con α = 0.92. In entrambi i casi le due di-

stribuzioni vengono estese all’intervallo a ∈ (0, 1) sfruttando la simmetria

P (a) = P (1− a).

3.2 Car parking 51

Figura 3.12: Confronto analogo al grafico precedente (cf. Fig. 3.11), per i dati

relativi al parcheggio posto sul lato sinistro della strada, con le previsioni del GOE.

3.2.3 Riepilogo

E stato mostrato che il fenomeno del car parking puo essere descritto in

modo esaustivo dal modello basato sulla soluzione delle fixed point equations

mediante il quale si ottiene una certa distribuzione ρ(D). I risultati sono stati

confrontati [20] con i dati raccolti nel centro di Hradec Kralove, confronto dal

quale e emersa soltanto una lieve discrepanza tra dati e la teoria delle matrici

random, demandabile alla diversa propensione dei conducenti a parcheggiare

all’interno degli slots disponibili. Inoltre, e stato dimostrato come il modello

conduca a soluzioni strettamente compatibili con l’andamento della distri-

buzione delle spaziature tra autovalori reali di insiemi gaussiani di matrici

ortogonali GOE e unitarie GUE.

Conclusioni e prospettive

La teoria delle matrici random, introdotta inizialmente da Wigner per

descrivere i livelli energetici dei nuclei atomici, si e rivelata essere un potente

strumento per interpretare statisticamente alcune proprieta relative a classi

di fenomeni, quali ad esempio la distribuzione degli autovalori. Nella prima

parte dell’elaborato, dopo aver definito formalmente gli insiemi gaussiani di

matrici e stata ricavata la densita di probabilita per le matrici costituenti gli

insiemi, esplicitandone la forma funzionale. Successivamente si e caratteriz-

zata la funzione densita di probabilita congiunta per gli autovalori reali ed e

stata illustrata l’analogia con il gas di Coulomb. Confrontando i risultati pre-

visti dalla RMT con la congettura di Wigner si e osservata la compatibilita

tra le due espressioni. E stata definita, inoltre, la densita media di autova-