Appunti su alcune classi importanti di matrici e gruppi di...

Transcript of Appunti su alcune classi importanti di matrici e gruppi di...

INDICE 1

Appunti su alcune classi importanti di matrici e gruppi di matrici.

Roberto Catenacci

Versione del 26 Luglio 2013

Argomenti scelti sulle matrici e sui gruppi di matrici complessivamente trattati nei corsi diGeometria 1A , Geometria 1B e Teoria dei Gruppi.

Testi di riferimento consigliati per questi argomenti:

M.L. Curtis, Matrix Groups, Universitext, Springer-Verlag, Berlino 1979A. Baker, Matrix Groups, Springer Undergraduate Mathematics Series, Springer-Verlag,

Berlino 2002S.Lang, Algebra Lineare, Boringhieri, Torino 1989

Indice

1 Matrici normali 21.1 Matrici simmetriche e hermitiane . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2 Gruppi di Matrici 4

3 Gruppi Ortogonali e Unitari 63.1 Matrici ortogonali e unitarie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 83.2 Autovalori delle matrici hermitiane e unitarie . . . . . . . . . . . . . . . . . . . 93.3 Scomposizione polare . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 103.4 Il teorema spettrale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

4 Spazio tangente all’identita 124.1 Matrici antisimmetriche e antihermitiane . . . . . . . . . . . . . . . . . . . . . . 17

5 Esponenziale, Logaritmo e Algebre di Lie 185.1 Algebre di Lie reali di dimensione due . . . . . . . . . . . . . . . . . . . . . . . . 275.2 Alcune algebre tridimensionali (so(3), su(2), sl(2,R), so(2, 1)) . . . . . . . . . . . 305.3 Sottogruppi ad un parametro . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

6 Considerazioni topologiche 346.1 Connessione e suriettivita dell’esponenziale . . . . . . . . . . . . . . . . . . . . . 346.2 Il caso di O(n) e SO(n) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 386.3 Quaternioni e rotazioni: SU(2)→ SO(3) . . . . . . . . . . . . . . . . . . . . . . 406.4 Il caso di GL(n,R) e GL(n,C) . . . . . . . . . . . . . . . . . . . . . . . . . . . . 446.5 Il caso di SL(2,R) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 466.6 Introduzione all’omotopia dei gruppi . . . . . . . . . . . . . . . . . . . . . . . . 51

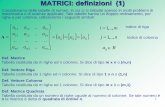

1 MATRICI NORMALI 2

1 Matrici normali

In questa sezione iniziamo lo studio di alcune importanti classi di matrici, usate in moltissimicampi della matematica e della fisica. Daremo per noti i piu semplici risultati di algebra lineareutilizzati. Indichiamo con Mn(R) e Mn(C) rispettivamente gli insiemi delle matrici n× n realio complesse (se non importa indicare esplicitamente il campo di numeri considerato, useremosemplicemente il simbolo Mn). E’ noto che Mn(R) e Mn(C) sono spazi vettoriali reali (didimensione n2 e 2n2 rispettivamente) e che con il prodotto righe × colonne, sono anelli noncommutativi con unita. Ricordiamo anche che in Rn si definisce il prodotto scalare standard :

(x, y) = xty =n∑i=1

xiyi

Dove x =

x1

x2

.xn

, y =

y1

y2

.yn

e xt denota la matrice trasposta di x. Analogamente, in Cn si

definisce il prodotto hermitiano standard :

(x, y) = xty =n∑i=1

xiyi

Definizione 1.1 Sia A una matrice reale o complessa, si definisce aggiunta (o coniugatahermitiana) di A, la matrice A∗ = At.

Osservazione 1.1 E’ chiaro che (A∗)∗ = A. Inoltre, per le matrici reali, l’aggiunta esemplicemente la matrice trasposta.

Lemma 1.1 In Rn e in Cn (con i prodotti standard) vale la formula: (Ax, y) = (x,A∗y).

Prova. Basta ricordare le proprieta algebriche della operazione di trasposizione e ledefinizioni di aggiunta di una matrice, di prodotto scalare e hermitiano:

(Ax, y) = (Ax)ty = xtAty = xtAty = (x,A∗y)

La formula del lemma 1.1 , ma con un arbitrario prodotto hermitiano, puo essere presacome definizione di aggiunta di una matrice:

Definizione 1.2 Si definisce aggiunta di una matrice A rispetto ad un prodotto hermitiano<,>, l’unica matrice A∗ tale che, ∀x, y ∈ Cn

< Ax, y >=< x,A∗y > .

Se B e la matrice del prodotto hermitiano dato, cioe se < x, y >= xtBy, si ottieneimmediatamente la formula:

A∗ = B−1AtB

1 MATRICI NORMALI 3

Osservazione 1.2 Si noti che la matrice B e I per il prodotto hermitiano standard, e quindisi riproduce la prima definizione data. (vedi definizione 1.1)

Definizione 1.3 Una matrice A si dice normale se commuta con la sua aggiunta: AA∗ =A∗A.

Alcune proprieta interessanti degli autovalori e degli autospazi delle matrici normali sonodate dai seguenti teoremi:

Teorema 1.1 Se A e una matrice normale, e se α e un autovalore di A con autovettore v,allora α e autovalore di A∗con lo stesso autovettore.

Prova. Occorre mostrare che:

Av = αv ⇒ A∗v = αv

Calcoliamo usando ripetutamente AA∗ = A∗A e il lemma 1.1

‖A∗v − αv‖2 = (A∗v − αv, A∗v − αv) =

= (A∗v,A∗v)− (αv, A∗v)− (A∗v, αv) + (αv, αv) =

= (v, AA∗v)− α (v, A∗v)− α(A∗v, v) + αα (v, v) =

= (v, A∗Av)− α (Av, v)− α(v, Av) + αα (v, v) =

= (v, A∗αv)− α (αv, v)− α(v, αv) + αα (v, v) =

= (Av, αv)− αα (v, v)− αα(v, v) + αα (v, v) =

= (αv, αv)− αα (v, v)− αα(v, v) + αα (v, v) = 0

Essendo quindi ‖A∗v − αv‖2 = 0 abbiamo la tesi.

Teorema 1.2 Se A e una matrice normale, e se α e β sono autovalori distinti di A allora icorrispondenti autospazi sono ortogonali tra loro.

Prova. Sia Ax = αx e Ay = βy: Si ottiene: (Ax, y) = (αx, y) = α(x, y) e (Ax, y) =(x,A∗y) = (x, βy) = β(x, y)⇒ (α−β)(x, y) = 0⇒ (x, y) = 0 (nel calcolo abbiamo usato ancheil teorema precedente).

Definizione 1.4 Una applicazione lineare si dice normale se la matrice A, ad essa associatain una base ortonormale, e una matrice normale.

Osservazione 1.3 Questa definizione e corretta in quanto osserveremo piu sotto (vedi il lemma3.4 della sezione 3.1) che se la matrice associata e normale in una certa base ortonormale lo eanche in qualsiasi altra base ortonormale.

Il risultato principale relativo alle matrici normali e il cosiddetto Teorema spettrale:

2 GRUPPI DI MATRICI 4

Teorema 1.3 Se l’applicazione lineare ϕ : Cn → Cn e normale, allora esiste una baseortonormale di autovettori.

Prova. Per la dimostrazione rimandiamo alla sezione 3.4Dal teorema spettrale segue immediatamente che:

Teorema 1.4 Le matrici normali sono diagonalizzabili (come matrici complesse) tramite unamatrice i cui vettori colonna sono tra loro tutti ortogonali e di norma uno.

Osservazione 1.4 Tali matrici sono dette matrici unitarie (vedi sezione 3.1)

1.1 Matrici simmetriche e hermitiane

Nell’ambito delle matrici normali assumono particolare interesse le matrici simmetriche e quellehermitiane.

Definizione 1.5 Una matrice reale A si dice simmetrica se coincide con la sua trasposta:A = At

Definizione 1.6 Una matrice A si dice hermitiana se coincide con la sua aggiunta:A = A∗

Analogamente alla definizione 1.4 possiamo dare le seguenti definizioni:

Definizione 1.7 Una applicazione lineare si dice simmetrica (hermitiana) se la matrice A, adessa associata in una base ortonormale, e una matrice simmetrica (hermitiana).

Osservazione 1.5 Questa definizione e corretta: dimostreremo piu sotto (vedi il lemma 3.5della sezione 3.1) che se la matrice associata e simmetrica o hermitiana in una certa baseortonormale lo e anche in qualsiasi altra base ortonormale.

2 Gruppi di Matrici

In questa sezione iniziamo lo studio dei principali gruppi di matrici (reali o complesse), comeintroduzione alla teoria dei gruppi di Lie; daremo per noti i principali risultati di algebra lineareutilizzati. Indichiamo ancora con Mn(R) e Mn(C) rispettivamente gli insiemi delle matricin×n reali o complesse (se non importa indicare esplicitamente il campo di numeri considerato,useremo semplicemente il simbolo Mn). E’ noto che Mn(R) e Mn(C) sono spazi vettoriali realidi dimensione n2 e 2n2 rispettivamente; e noto anche che su Mn(R) e Mn(C) si puo definire unprodotto, il cosiddetto prodotto righe × colonne: se A,B ∈Mn con elementi Aij, Bij, allora:

(AB)ij =k=n∑k=1

AikBkj

La matrice prodotto C = AB e ancora ∈ Mn. Ricordiamo anche che una matrice A ∈ Mn

e invertibile se e solo se det(A) 6= 0 e, in questo caso, ∃ una unica matrice A−1 tale che

2 GRUPPI DI MATRICI 5

AA−1 = A−1A = I (dove I e una matrice con elementi Iij = 1 se i = j e Iij = 0 se i 6= j).Ricordando le seguenti proprieta del determinante:

det(AB) = detA detB e det(A)−1 = (detA)−1,

possiamo ora dare le seguenti definizioni:

Definizione 2.1 Il gruppo generale lineare reale, denotato con GL(n,R) e l’insieme dellematrici invertibili ∈Mn(R) con il prodotto righe × colonne. Il gruppo speciale lineare reale,denotato con SL(n,R) e il sottogruppo delle matrici A ∈ GL(n,R) tali che detA = 1.

Definizione 2.2 Il gruppo generale lineare complesso, denotato con GL(n,C) e l’insiemedelle matrici invertibili ∈ Mn(C) con il prodotto righe × colonne. Il gruppo speciale linearecomplesso, denotato con SL(n,C) e il sottogruppo delle matrici A ∈ GL(n,C) tali che detA =1.

Teorema 2.1 I gruppi speciali lineari sono sottogruppi normali dei gruppi generali lineari,inoltre: GL(n,R)/SL(n,R) = R∗ (e analoga per C).

Prova. La dimostrazione e identica per il caso reale e complesso. Dalle proprieta deldeterminante segue che l’applicazione det : GL(n,R) → R∗ e un omomorfismo suriettivo dinucleo Ker(det) = SL(n,R). Dal fatto che il nucleo di un omomorfismo e un sottogrupponormale e dal teorema di isomorfismo segue l’asserto.

Descriveremo ora alcuni casi particolari per piccoli n.

Esempio 2.1 GL(1,R) = R∗ e GL(1,C) = C∗.

Esempio 2.2 GL(1,C) e sottogruppo di GL(2,R). Infatti si puo definire il seguenteomorfismo iniettivo:

ρ(x+ iy) =

(x −yy x

)Notare che det

(x −yy x

)= x2 + y2.

Esempio 2.3 H∗(il gruppo moltiplicativo dei quaternioni non nulli) e sottogruppo di GL(2,C).Infatti si puo definire il seguente omorfismo iniettivo:

ρ(x+ iy + jz + kt) =

(x+ iy −z − itz − it x− iy

)

Notare che det

(x+ iy −z − itz − it x− iy

)= x2 + y2 + z2 + t2.

3 GRUPPI ORTOGONALI E UNITARI 6

3 Gruppi Ortogonali e Unitari

Studiamo ora i piu importanti sottogruppi dei gruppi generali lineari: i gruppi ortogonali eunitari.

Lemma 3.1 Una matrice A ∈ GL(n,R) tale che A−1 = At preserva il prodotto scalare:(Ax,Ay) = (x, y) per ogni x, y ∈ Rn; viceversa, se preserva il prodotto scalare per ogni x, yallora A−1 = At. Una matrice A ∈ GL(n,C) tale che A−1 = A∗ = At preserva il prodottohermitiano: (Ax,Ay) = (x, y) per ogni x, y ∈ Cn e viceversa.

Prova. La dimostrazione e analoga nei due casi: osserviamo che, per il lemma 1.1 (Ax, y) =(x,A∗y); si ottiene allora (Ax,Ay) = (x,A∗Ay) = (x, y). Viceversa, se (Ax,Ay) = (x, y) allora(Ax)t(Ay) = xty e quindi, (per le proprieta note della trasposizione) xtAtAy = xty. Essendoverificata per ogni x e y, deve essere AtA = I, cioe, coniugando, A∗A = I.

Il lemma 3.1 e le note proprieta dell’aggiunzione:

(A∗)∗ = A, (AB)∗ = B∗A∗, (A−1)∗ = (A∗)−1, detA∗ = detA

consentono di dare le seguenti definizioni:

Definizione 3.1 Il gruppo ortogonale O(n) e il sottogruppo delle matrici di GL(n,R) chepreservano il prodotto scalare: O(n) = A ∈ GL(n,R)|A−1 = At.

Definizione 3.2 Il gruppo unitario U(n) e il sottogruppo delle matrici di GL(n,C) chepreservano il prodotto hermitiano: U(n) = A ∈ GL(n,C)|A−1 = A∗.

Definizione 3.3 Il gruppo delle rotazioni (detto anche gruppo speciale ortogonale) SO(n)e dato da SO(n) = O(n) ∩ SL(n,R).

Definizione 3.4 Il gruppo speciale unitario SU(n) e dato da U(n) ∩ SL(n,C).

Definizione 3.5 La sfera n− 1 dimensionale e l’insieme Sn−1 = x ∈ Rn|(x, x) = 1

Osservazione 3.1 Dalla relazione A∗A = I segue che se A ∈ O(n), detA = ±1; se A ∈ U(n),detA = z con zz = 1 e quindi detA ∈ S1.(Naturalmente non e vero il viceversa).

Teorema 3.1 I gruppi speciali ortogonale e unitario sono sottogruppi normali rispettivamentedei gruppi ortogonali e unitari (con lo stesso n). Si ha inoltre:

O(n)/SO(n) = Z2 e U(n)/SU(n) = S1

In particolare, O(1) = Z2 = S0 e U(1) = S1.

Prova. Dalle proprieta del determinante e dall’osservazione 3.1 segue che l’applicazionedet : O(n) → Z2 e un omomorfismo suriettivo di nucleo Ker(det) = SO(n). Dal fatto cheil nucleo di un omomorfismo e un sottogruppo normale e dal teorema di isomorfismo seguel’asserto. Per U(n) si procede analogamente.

3 GRUPPI ORTOGONALI E UNITARI 7

Osservazione 3.2 Segue dal teorema precedente che ci sono solo due laterali di SO(n) inO(n) : il laterale SO(n) che contiene I e il laterale O(n) − SO(n) che contiene la matriceC tale che C11 = −1 e Cij = δij se i 6= 1 e j 6= 1; per tale matrice, detC = −1. Segueimmediatamente che ogni matrice B ∈ O(n) − SO(n) puo essere scritta come B = AC conA ∈ SO(n) (A = BC−1)

Esempio 3.1 O(2), SO(2) e U(1).

Una matrice A di O(2) deve verificare:

A−1 =

(a bc d

)−1

=

(d

detA− b

detA

− cdetA

adetA

)= At =

(a cb d

)Si distinguono ora due casi:

i) detA = 1, allora A ∈ SO(2) e A =

(a −bb a

)con a2 + b2 = 1 e quindi possiamo porre

a = cos θ, b = sin θ. La matrice A rappresenta una rotazione (nel piano cartesiano x, y)in senso antiorario di un angolo θ. Prendendo l’omomorfismo ρ dell’esempio 2.2 si ottieneρ(cos θ + i sin θ) = A; e anche chiaro che, in questo caso, ρ e suriettivo, e quindi si ha unisomorfismo:

SO(2) = U(1) = S1

ii) detA = −1, allora A ∈ O(2)− SO(2) e A =

(−a −b−b a

)con a2 + b2 = 1 e quindi possiamo

porre a = cos θ, b = sin θ. Si ottiene(− cos θ − sin θ− sin θ cos θ

)=

(cos θ − sin θsin θ cos θ

)(−1 00 1

)

La matrice

(−1 00 1

)rappresenta una riflessione (nel piano cartesiano x, y) rispetto al-

l’asse delle y e la matrice

(cos θ − sin θsin θ cos θ

)una rotazione di angolo θ. Segue che ogni

A ∈ O(2)− SO(2) rappresenta una riflessione nel piano x, y rispetto a una retta passan-te per l’origine. Si noti che la composizione di due riflessioni risulta sempre essere unarotazione (il determinante vale 1).

Esempio 3.2 SU(2) = S3 = Sp(1) (il gruppo moltiplicativo dei quaternioni di norma 1).

Le matrici di SU(2) devono verificare la relazione:

A−1 =

(a bc d

)−1

=

(d −b−c a

)= A∗ =

(a cb d

)

3 GRUPPI ORTOGONALI E UNITARI 8

Segue che una matrice di SU(2) si puo scrivere:

A =

(a −bb a

)con aa+ bb = 1

Se poniamo a = x + iy e b = z + it si ottiene che (x, y, z, t) ∈ S3. La sfera S3 puo essereidentificata col gruppo dei quaternioni di norma uno: Sp(1) = q ∈ H | qq = 1. E’ facileverificare che l’immagine dell’omomorfismo ρ dell’esempio 2.3 e proprio SU(2). Infatti, posto

q = x + iy + jz + kt si ottiene ρ(q)(ρ(q))∗ =

(1 00 1

). Per la suriettivita basta ricordare la

rappresentazione trovata sopra delle matrici di SU(2) e osservare che ρ(x + iy + jz + kt) =(a −bb a

). Si conclude osservando che un omomorfismo iniettivo e un isomorfismo sulla sua

immagine.

Osservazione 3.3 S0, S1 e S3 sono le uniche sfere a cui si puo dare una struttura di gruppo.

3.1 Matrici ortogonali e unitarie

Studiamo ora alcune proprieta algebriche (della massima importanza) delle matrici appartenentiai gruppi ortogonali e unitari.

Definizione 3.6 Le matrici appartenenti rispettivamente ai gruppi ortogonali o unitari sonodette matrici ortogonali o unitarie.

Lemma 3.2 Le matrici ortogonali e le matrici unitarie sono matrici normali.

Prova. Basta ovviamente dimostrarlo nel caso unitario. Se U−1 = U∗ segue subito: UU∗ =I = U∗U .

Lemma 3.3 Le colonne delle matrici ortogonali e delle matrici unitarie hanno norma unitariae sono tra loro ortogonali.

Prova. Queste matrici infatti trasformano basi ortonormali in basi ortonormali, percheconservano il prodotto scalare o il prodotto hermitiano.

Lemma 3.4 Se A e una matrice normale, lo e anche ogni matrice simile ad A tramite unamatrice unitaria.

Prova. Sia B = U−1AU simile ad A, con U unitaria. Si ottiene:

BB∗ = U∗AU (U∗AU)∗ = U∗A (UU∗)A∗U = U∗AA∗U

B∗B = (U∗AU)∗ U∗AU = U∗A∗ (UU∗)AU = U∗A∗AU

Essendo A normale, segue la tesi: BB∗ = B∗B.

3 GRUPPI ORTOGONALI E UNITARI 9

Osservazione 3.4 Segue immediatamente da questo lemma che se una applicazione lineare erappresentata in una base ortonormale da una matrice normale, e rappresentata da una matricenormale in ogni altra base ortonormale.

Lemma 3.5 Se A e una matrice hermitiana, lo e anche ogni matrice simile ad A tramite unamatrice unitaria.

Prova. Sia B = U−1AU simile ad A, con U unitaria. Si ottiene:

B = U∗AU

B∗ = (U∗AU)∗ = U∗A∗U

Essendo A hermitiana, segue la tesi: B = B∗

Osservazione 3.5 Segue immediatamente da questo lemma che se una applicazione linearee rappresentata in una base ortonormale da una matrice hermitiana, e rappresentata da unamatrice hermitiana in ogni altra base ortonormale.

3.2 Autovalori delle matrici hermitiane e unitarie

Studiamo in questa sezione le principali proprieta degli autovalori e degli autovettori per leclassi di matrici normali di nostro interesse.

Teorema 3.2 Gli autovalori di una matrice hermitiana sono numeri reali.

Prova. Sia Ax = αx. Allora: (Ax, y) = (x,A∗y) = (x,Ay) ⇒ (αx, x) = (x, αx) ⇒α(x, x) = α(x, x)⇒ α = α

Segue ovviamente il seguente risultato non banale (ma difficile da ricavare guardando soloil polinomio caratteristico!):

Teorema 3.3 Gli autovalori di una matrice simmetrica sono numeri reali.

Teorema 3.4 Gli autovalori di una matrice unitaria sono numeri complessi di norma 1.

Prova. Sia Ux = αx.Allora (vedi lemma 3.1) (Ux, Ux) = (x, x) ⇒ (αx, αx) = (x, x) ⇒αα = 1

Segue ovviamente anche il seguente risultato, anch’esso non banale:

Teorema 3.5 Gli autovalori di una matrice ortogonale possono essere solo ±1.

Riportiamo ora un importante corollario del Teorema Spettrale (per la cui dimostrazionevedi 1.3)

Teorema 3.6 :

1. Le matrici hermitiane sono diagonalizzabili mediante matrici unitarie.

3 GRUPPI ORTOGONALI E UNITARI 10

2. Le matrici simmetriche sono diagonalizzabili mediante matrici ortogonali.

3. Le matrici unitarie sono diagonalizzabili mediante matrici unitarie.

Definizione 3.7 Una matrice simmetrica (o hermitiana) si dice definita positiva se ha tuttigli autovalori strettamente maggiori di zero.

Lemma 3.6 Data A definita positiva e simmetrica, esiste una matrice B, anch’essa definitapositiva e simmetrica tale che A = B2 (analogo risultato vale per le matrici hermitiane positive).

Prova. La matrice A e diagonalizzabile tramite matrici ortogonali, e sulla diagonale hanumeri reali strettamente positivi. Sia D una sua forma diagonale, e sia E la matrice diagonaleche ha sulla diagonale le radici positive degli autovalori di A:

D = C−1AC = E2

Si ottiene quindi, posto B ≡ CEC−1:

A = CDC−1 = CE2C−1 =(CEC−1

) (CEC−1

)= BB = B2.

La matrice B e simmetrica. Infatti, essendo C−1 = Ct e E diagonale, si ha:

Bt =(CECt

)t= CEtCt = B

Osservazione 3.6 Data A invertibile, AtA e definita positiva. Infatti AtA e simmetrica,ed inoltre se AtAv = λv si ottiene:

0 < (Av,Av) =(v, AtAv

)= (v, λv) = λ(v, v) = λ ‖v‖2

perche A e invertibile e v 6= 0. Si ha quindi λ > 0. Lo stesso vale nel caso complesso: data Ainvertibile, A∗A e hermitiana definita positiva.

3.3 Scomposizione polare

Concludiamo il paragrafo con una interessante proprieta delle matrici invertibili:

Teorema 3.7 Ogni matrice reale invertibile A si puo scrivere come il prodotto di una matriceortogonale R e una matrice simmetrica S definita positiva. Un risultato analogo vale per lematrici complesse: ogni matrice complessa invertibile si puo scrivere come il prodotto di unamatrice unitaria U e una matrice hermitiana definita positiva H.

3 GRUPPI ORTOGONALI E UNITARI 11

Prova. Dimostriamolo nel caso reale. Consideriamo la matrice AtA (simmetrica e definitapositiva per l’osservazione 3.6 ); per il lemma 3.6 esiste una matrice S simmetrica e definitapositiva tale che S2 = AtA; si ottiene quindi

A =(At)−1

S2 =((At)−1

S)S ≡ RS

Osserviamo ora che R = (At)−1S e ortogonale:

R−1 =((At)−1

S)−1

= S−1At = S−1(S2A−1

)= SA−1

Rt =((At)−1

S)t

= StA−1 = SA−1

La dimostrazione nel caso complesso e perfettamente analoga.

Osservazione 3.7 La scomposizione polare nel caso complesso, A = UH, con U unitaria eH hermitiana definita positiva, nel caso di matrici 1 × 1, invertibili, cioe numeri complessi6= 0, riproduce, ovviamente, la usuale rappresentazione trigonometrica z = eiθ|z|, con eiθ ∈U(1), |z| > 0.

Osservazione 3.8 Se la matrice A reale ha determinante positivo, la scomposizione e: A = RScon detR = 1.

3.4 Il teorema spettrale

In questa sezione dimostriamo il risultato principale sulle matrici normali: la lorodiagonalizzabilita.

Partiamo dai due seguenti semplici lemmi.

Lemma 3.7 Ogni applicazione lineare f definita su un sottospazio complesso V di Cn, a valoriin V stesso, ha sicuramente un autovettore.

Prova. Infatti, se V ha dimensione r, e si scrive la matrice della restrizione di f a V, sitrova una matrice r × r. Questa ha almeno un autovalore complesso, e, conseguentemente, fha almeno un autovettore appartenente a V.

Lemma 3.8 Siano A e B due matrici complesse n × n tali che AB = BA. Allora esiste unelemento non nullo di Cn che e autovettore sia di A, sia di B.

Prova. Sia λ un autovalore di A, e sia Vλ il corrispondente autospazio. Se −→v ∈ Vλ,abbiamo:

A(B(−→v )) = B(A(−→v )) = B(λ−→v ) = λB(−→v ).

Quindi B(−→v ) ∈ Vλ. B e un’applicazione lineare di Vλ in se stesso. Per il lemma precedente,questa ha almeno un autovettore −→w ∈ Vλ. Abbiamo concluso: −→w sta in Vλ, dunque e unautovettore di A, e −→w e anche autovettore di B.

4 SPAZIO TANGENTE ALL’IDENTITA 12

Teorema 3.8 Teorema spettrale. Sia 〈〉 il prodotto Hermitiano standard su Cn, e sia Auna matrice normale n×n. Allora, esiste una base ortonormale di Cn costituita da autovettoridi A.

Prova. Procediamo per induzione sulla dimensione n. Il teorema e ovvio per n = 1 (Ae una matrice 1× 1). Dobbiamo dimostrare il teorema spettrale in dimensione n, supponendoche esso sia vero in dimensione n − 1. Poiche A commuta con A∗, A e A∗ hanno almeno unautovettore in comune per il lemma 3.8: indichiamolo con −→v1 . Dividendolo per la sua norma,potremo supporre che −→v1 abbia lunghezza 1. Ora, siano V1 = span −→v1, e W = (V1)⊥. Amanda W in se stesso: se −→w ∈ W ,

〈A−→w ;−→v1〉 = 〈−→w ;A∗−→v1〉 = µ 〈−→w ;−→v1〉 = 0

La penultima uguaglianza si ottiene ricordando che −→v1 e un autovettore anche per A∗ (indicandocon µ l’autovalore associato). L’ultima uguaglianza si ottiene ricordando che −→w ∈ W = (V1)⊥.Dunque, A−→w e ortogonale a −→v1 , e cioe A−→w ∈ W . A puo essere vista come un’applicazionelineare di W in se stesso. Ma W ha dimensione n − 1, dunque si puo applicare l’ipotesiinduttiva. Sia −→v2 ; ...;−→vn la base ortonormale di W . Allora, essendo −→v1 ortogonale ad ognivettore di W , −→v1 ;−→v2 ; ...;−→vn e la base cercata di Cn.

Osservazione 3.9 Nella base ortonormale composta da autovettori la matrice risulta diagona-le. Una matrice diagonalizzante e una matrice le cui colonne sono costituite da autovettori esulla diagonale abbiamo gli autovalori.

Osservazione 3.10 Abbiamo visto che tutte le matrici complesse normali possono esserediagonalizzate in C con una base ortonormale di autovettori. Tuttavia, questo non si verificanel caso reale. Infatti, una matrice normale reale potrebbe avere autovalori complessi, e quindinon essere diagonalizzabile in campo reale (pur rimanendo ovviamente diagonalizzabile in campocomplesso). Tale cosa non si verifica per le matrici reali simmetriche che risultano, quindi,tutte diagonalizzabili; il teorema 3.2, valido per le matrici hermitiane, vero in particolareanche per tutte le matrici simmetriche, afferma infatti che esse possono avere solo autovalorireali.

4 Spazio tangente all’identita

Iniziamo in questa sezione lo studio delle proprieta geometriche e topologiche dei gruppiortogonali e unitari.

Definizione 4.1 Sia V uno spazio vettoriale reale di dimensione finita, una curva in V e unafunzione differenziabile γ : (a, b)→ V, dove (a, b) ⊂ R e un intervallo aperto contenente 0.

Definizione 4.2 Sia u = γ(c) con c ∈ (a, b). Un vettore v tangente in u a V e v =

limh→0γ(c+h)−γ(c)

h

4 SPAZIO TANGENTE ALL’IDENTITA 13

Se (e1, e2, ..., en) e una base di V, si ottiene subito che v = γ′(c) = (γ′1(c)...γ′n(c)). Come Vconsidereremo d’ora in avanti Mn.

Definizione 4.3 Sia G un sottogruppo di GL(n,R) (o GL(n,C)). Una curva in G passanteper l’identita e una curva in GL(n,R) (o GL(n,C) tale che, ∀c ∈ (a, b), γ(c) ∈ G e γ(0) = I.

Definizione 4.4 Siano α e β due curve in G passanti per l’identita, la curva prodotto e lacurva (in G e passante per l’identita) η(c) = (αβ)(c) = α(c)β(c)

Osservazione 4.1 Si ottiene subito (facendo attenzione all’ordine in cui si moltiplicano glielementi di G):

(αβ)′(c) = α(c)β′(c) + α′(c)β(c)

Definizione 4.5 Lo spazio tangente a G nell’identita e l’insieme T (G) = v ∈Mn|v = γ′(0),essendo γ una curva in G passante per l’identita.

Lemma 4.1 T (G) e un sottospazio vettoriale di Mn.

Prova. Siano α′(0), β′(0) ∈ T (G), allora

(αβ)′(0) = α(0)β′(0) + α′(0)β(0) = α′(0) + β′(0)

e quindi, dato che (αβ)′(0) ∈ T (G) per la definizione di curva prodotto, anche α′(0) + β′(0) ∈T (G). Sia ora α′(0) ∈ T (G) e sia u un numero reale; posto σ(t) = α(ut) si trova immediatamenteche σ e una curva in G passante per l’identita e che σ′(0) = uα′(0) e quindi uα′(0) ∈ T (G).

Esempio 4.1 T (GL(1,C)) = C = R2, T (GL(2,R)) = M2(R) = R4. Basta infatti osservareche i valori delle derivate in zero di funzioni reali sono arbitrari numeri reali.

Esempio 4.2 T (SO(2)) = R. Sia (vedi esempio 3.1)

α(t) =

(cos f(t) − sin f(t)sin f(t) cos f(t)

)con f(0) = 0

una curva in SO(2) passante per I. Essendo f ′(0) un arbitrario numero reale, si vede subitoche:

T (SO(2)) = matrici 2× 2 di tipo α′(0) =

(0 −aa 0

), a ∈ R

E quindi T (SO(2)) e, come spazio vettoriale reale, isomorfo a R. Il lettore farebbe bene a

verificare in tutti i dettagli che

(0 −aa 0

), a ∈ R

e uno spazio vettoriale reale di dimensione

1.

Definizione 4.6 La dimensione di G (dim(G)) e la dimensione di T (G) come spazio vettorialereale.

4 SPAZIO TANGENTE ALL’IDENTITA 14

Definizione 4.7 Un omomorfismo differenziabile ϕ : H → G e un omomorfismo tale cheβ(t) = ϕ(α(t)) = (ϕ α)(t) e una curva in G per ogni α curva in H.

Osservazione 4.2 Si noti che se α passa per l’identita di H necessariamente (ϕα) passa perl’identita di G in virtu del fatto che un omomorfismo manda l’identita nell’identita. Il puntochiave della definizione e la differenziabilita della funzione composta. Tutti gli omomorfismiconsiderati in questa sezione sono differenziabili perche si ottengono da prodotti e somme tranumeri reali, numeri complessi (visti come coppie di numeri reali) e quaternioni (visti comequaterne di numeri reali).

Definizione 4.8 Il differenziale dϕ di un omomorfismo differenziabile e l’applicazione dϕ :T (H)→ T (G):

dϕ(α′(0)) = β′(0) = (ϕ α)′(0)

In particolare, il differenziale dell’omomorfismo identita e l’applicazione identita tra T (H)e T (G).

Esempio 4.3 Consideriamo il caso dell’omomorfismo ρ dell’esempio 2.2. Sia α(t) = x(t) +iy(t) una curva in GL(1,C) passante per I. Si ottiene subito che

(ρ α)(t) =

(x(t) −y(t)y(t) x(t)

)e quindi:

(ρ α)′(0) =

(x′(0) −y′(0)y′(0) x′(0)

)Ora x′(0) e y′(0) sono due arbitrari numeri reali, diciamo a e b; risulta quindi dalla definizione4.8 e dall’esempio 4.1 che dρ : R2→M2(R)

dρ :

(ab

)∈ R2 →

(a −bb a

)∈M2(R)

Si osservi che dρ e una applicazione lineare iniettiva di rango 2, la sua immagine e il sottospazio

bidimensionale di M2(R) generato da

(1 00 1

)e

(0 −11 0

).

Esempio 4.4 Se restringiamo ρ alle matrici di U(1) cioe ai numeri complessi di norma 1,x′(0) non puo piu essere arbitrario. Infatti, se x(t)2 + y(t)2 = 1 si ottiene

2x(t)x′(t) + 2y(t)y′(t) = 0,

ma x(0) + iy(0) = 1 e quindi deve essere x′(0) = 0. Ne segue che:

dρ : b ∈ R→(

0 −bb 0

)∈ T (SO(2)) ⊂M2(R)

In altri termini (vedi l’esempio 4.2), dρ e un isomorfismo di spazi vettoriali reali traT (U(1)) e T (SO(2)). Sappiamo anche (vedi l’esempio 3.1) che ρ e un isomorfismo di gruppitra U(1) e SO(2). La situazione descritta in questo esempio si generalizza nel seguente lemma:

4 SPAZIO TANGENTE ALL’IDENTITA 15

Lemma 4.2 Il differenziale dϕ di un omomorfismo differenziabile ϕ e una applicazione lineare.Se ϕ e un isomorfismo di gruppi H → G, allora dϕ e un isomorfismo di spazi vettoriali realiT (H) → T (G).

Prova. Siano α′(0), β′(0) ∈ T (H) allora (vedi lemma 4.1):

dϕ [α′(0) + β′(0)] = dϕ[(αβ)′ (0)

]= [ϕ αβ)]′(0)

Dove αβ e la curva prodotto: (αβ) (t) = α(t)β(t). Si ottiene:

(ϕ αβ) (t) = ϕ [αβ(t)] = ϕ [α(t)β(t)] = ϕ [α(t)]ϕ [β(t)] = (ϕ α) (t) (ϕ β) (t)

Osserviamo ora che, dalla definizione di derivata, si ha proprio:

dϕ [α′(0) + β′(0)] = dϕ[(αβ)′ (0)

]= [ϕ αβ]′(0) = [(ϕ α) (t) (ϕ β) (t)]′t=0 =

= [ϕ α]′(0) (ϕ β) (0) + (ϕ α) (0)[ϕ β]′(0) = dϕ [α′(0)] + dϕ [β′(0)] ,

perche (ϕ β) (0) = (ϕ α) (0) = ϕ(I) = I, e quindi:

dϕ [α′(0) + β′(0)] = dϕ [α′(0)] + dϕ [β′(0)]

Sia ora a un numero reale si ha allora (vedi ancora il lemma 4.1):

dϕ [aα′(0)] = dϕ [(aα)′(0)] = [ϕ aα)]′(0)

Ricordiamo ora che aα e la curva (aα) (t) = α(at), per cui:

[ϕ aα](t) = ϕ [α(at)] = [a (ϕ α)] (t)

Osserviamo ora che, dalla definizione di derivata, si ha proprio:

[ϕ aα]′(0) = [a (ϕ α) (t)]′t=0 = a (ϕ α)′ (0)

e quindi:dϕ [aα′(0)] = adϕ [α′(0)]

La linearita di dϕ e provata.La seconda parte segue dal fatto che la composizione di funzioni differenziabili e

differenziabile e dalla regola di Leibniz. Se ϕ e ψ sono omomorfismi differenziabili

Hψ→ G

ϕ→ K

anche ϕ ψ lo e e, inoltre, si verifica che d(ϕ ψ) = dϕ dψ. Infatti si ha, dalle definizioni :

d(ϕ ψ) [α′(0)] = (ϕ ψ α)′ (0) = dϕ[(ψ α)′ (0)

]= (dϕ dψ) [α′(0)]

Se ϕ e un isomorfismo differenziabile, anche ϕ−1 lo e e quindi segue che:

d(ϕ ϕ−1) = d(Id) = Id = dϕ dϕ−1.

Analogamente:d(ϕ−1 ϕ) = d(Id) = Id = dϕ−1 dϕ.

Dove abbiamo indicato con Id l’applicazione identita. Ne consegue che (dϕ)−1 = dϕ−1 e quindidϕ e una applicazione lineare invertibile e quindi un isomorfismo.

4 SPAZIO TANGENTE ALL’IDENTITA 16

Teorema 4.1 Due gruppi differenziabilmente isomorfi hanno la stessa dimensione.

Prova. Segue banalmente dal lemma 4.2.

Teorema 4.2dim(SO(2)) = dim(U(1)) = dim(S1) = 1

edim(SU(2)) = dim(S3) = 3.

(questo enunciato suggerisce che debba esistere una definizione di dimensione (applicabile anchealle sfere che non sono gruppi) per cui dim(Sn) = n)

Prova. Abbiamo gia visto nell’esempio 4.4 che dim(SO(2)) = dim(U(1)) = 1. Ne vediamoora un’altra dimostrazione: SO(2), U(1) e S1 sono differenziabilmente isomorfi (vedi l’esempio3.1 ed il teorema 3.1) e quindi, (vedi teorema 4.1), possiamo calcolare solo dim(S1). Sia oraγ(t) = eif(t) con f(t) reale, differenziabile e tale che f(0) = 0 una curva in S1 passante per 1. Siha T (S1) = γ′(0) = if ′(0)|. Essendo ogni numero reale a la derivata in 0 della funzione (reale,differenziabile e passante per 0) f(t) = at segue che T (S1) e tutto l’asse immaginario e quindi eisomorfo, come spazio vettoriale reale, a R.Dimostriamo ora la seconda parte. SU(2), S3 e Sp(1)sono differenziabilmente isomorfi (vedi esempio 3.2). Sia ora γ(t) = x(t) + y(t)i+ z(t)j+w(t)kcon x(t)2 + y(t)2 + z(t)2 +w(t)2 = 1 e x(0) = 1, y(0) = z(0) = w(0) = 0 una curva passante perl’identita in Sp(1). Si nota che in x(0) = 1 la funzione x(t) ha un massimo e quindi x′(0) = 0(vedi anche l’esempio 4.4). Ne segue che γ′(0) = y′(0)i + z′(0)j + w′(0)k. Allora T (Sp(1)) =γ′(0)|γ(0) = 1 ⊂ R3 (dove R3 e visto come lo spazio vettoriale reale generato da i, j, k).Viceversa, R3 ⊂ T (Sp(1)) = γ′(0)|γ(0) = 1 perche, per ogni a, b, c reali, basta considerarela curva γ(t) (in Sp(1), perche si vede subito che ‖γ(t)‖2 = 1, con dominio di definizione unpiccolo intervallo attorno a 0 dipendente da a, b, c in modo che 1 − a2t2 − b2t2 − c2t2 > 0,differenziabile e passante per 1):

γ(t) =√

1− a2t2 − b2t2 − c2t2 + ati+ btj + ctk

e si ottiene proprio ai+ bj + ck = γ′(0).Il seguente teorema fornisce un’altra giustificazione per l’uso del termine dimensione nella

definizione 4.6.

Teorema 4.3 dimGL(n,R) = n2 e dimGL(n,C) = 2n2

Prova. Siccome (come spazi vettoriali reali) dimMn(R) = n2 e dimMn(C) = 2n2, bastadimostrare che ogni matrice di Mn puo essere vista come la derivata in 0 di una curva inGL(n,R) (oppure GL(n,C)) passante per l’identita. Sia allora v ∈ Mn e si consideri, inun intervallo contenente lo zero, la curva σ : (a, b) → Mn definita da σ(t) = tv + I. Talecurva verifica σ(0) = I e σ′(0) = v. Il determinante e una funzione continua (si calcola solocon somme e prodotti) e quindi prendendo l’intervallo di definizione di σ abbastanza piccolo,possiamo essere certi che det σ(t) 6= 0 in quanto detσ(0) = 1. In altre parole una matrice che

4 SPAZIO TANGENTE ALL’IDENTITA 17

differisce di poco dall’identita e invertibile. Ci si puo convincere di cio anche dimostrando laformula seguente (ad esempio nel caso semplice di M2(R)):

det(I + εA) = 1 + εtr(A) +O(ε2)

Si ricorda che tr(A) e la traccia della matrice A cioe la somma degli elementi presenti sulladiagonale principale.

La dimostrazione del teorema 4.2, tutta basata su calcoli e costruzioni ad hoc non e perniente illuminante sulla struttura degli spazi tangenti, ma, a questo punto della trattazione nonera forse possibile fare di meglio...

4.1 Matrici antisimmetriche e antihermitiane

Definizione 4.9 Una matrice A ∈ Mn(R) e detta antisimmetrica se A + At = 0 (dove 0 e lamatrice con tutti gli elementi nulli).

Definizione 4.10 Una matrice A ∈Mn(C) e detta antihermitiana se A+ A∗ = 0.

Definizione 4.11 so(n) = A ∈Mn(R)|A+ At = 0 (notare che risulta sempre tr(A) = 0)

Definizione 4.12 u(n) = A ∈Mn(C)|A+ A∗ = 0

Definizione 4.13 su(n) = A ∈Mn(C)|A+ A∗ = 0 e tr(A) = 0

Lemma 4.3 so(n) e un sottospazio vettoriale di Mn(R) di dimensione n(n−1)2

.

Prova. Se A,B ∈ so(n) segue che (A+B) + (A+B)t = (A+ At) + (B +Bt) = 0. Sea ∈ R e A ∈ so(n) segue che aA + (aA)t = a(A + At) = 0. Per il calcolo della dimensione,basta osservare che ogni matrice antisimmetrica ha la diagonale tutta nulla e che gli elementisotto la diagonale sono gli opposti di quelli sopra la diagonale (infatti A + At = 0 implica cheAij = −Aji e Aii = 0). Gli elementi indipendenti di una matrice con diagonale tutta nulla sono

n2 − n, di cui n2−n2

stanno sopra la diagonale e n2−n2

sotto. L’osservazione precedente mostrapero che in una matrice antisimmetrica gli elementi sopra la diagonale determinano anche quellisotto la diagonale e quindi ne restano solo n2−n

2indipendenti.

Lemma 4.4 u(n) e un sottospazio vettoriale reale di Mn(C) di dimensione n2 e su(n) e unsottospazio vettoriale reale di Mn(C) di dimensione n2 − 1.

Prova. Se A,B ∈ u(n) segue che (A+B)+(A+B)∗ = (A+ A∗)+(B +B∗) = 0. Se a ∈ Re A ∈ u(n) segue che aA + (aA)∗ = aA + aA∗ = a(A + A∗) = 0 (Notare che u(n) non e unospazio vettoriale su C, perche se a ∈ C− R si ha a 6= a). Il caso di su(n) e totalmente analogoessendo la traccia una operazione lineare. Per il calcolo della dimensione, basta osservare cheogni matrice antihermitiana ha la diagonale tutta puramente immaginaria e che gli elementisotto la diagonale sono gli opposti dei coniugati di quelli sopra la diagonale (infatti A+A∗ = 0implica che Aij = −Aji e Aii + Aii = 0). Osserviamo ora che gli n2 − n numeri complessi che

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 18

individuano gli elementi indipendenti di una matrice complessa con diagonale tutta nulla, sonodeterminati da 2(n2 − n) numeri reali, di cui n2 − n stanno sopra la diagonale e n2 − n sotto.Sappiamo pero che in una matrice antihermitiana gli elementi sopra la diagonale determinanoanche quelli sotto la diagonale; agli n2−n numeri reali rimasti indipendenti vanno pero ancoraaggiunti gli n numeri reali che individuano gli elementi puramente immaginari della diagonale.Nel caso di su(n) la traccia e nulla, e quindi gli elementi puramente immaginari sulla diagonalenon sono tutti indipendenti, ma uno tra loro deve essere l’opposto della somma dei rimanenti,e questo fa calare di uno la dimensione reale.

Possiamo ora enunciare un risultato preliminare che pero inizia a mostrare l’importanzadegli spazi vettoriali sopra definiti che appaiono in modo naturale in molte altre situazioni.

Lemma 4.5

1. Se γ e una curva passante per l’identita in O(n) oppure in SO(n) allora γ′(0) ∈ so(n),cioe T (O(n)) ⊆ so(n) e T (SO(n)) ⊆ so(n).

2. Se γ e una curva passante per l’identita in U(n) allora γ′(0) ∈ u(n), cioe T (U(n)) ⊆ u(n).

3. In particolare, dimO(n) ≤ n2−n2, dimSO(n) ≤ n2−n

2, dimU(n) ≤ n2,

Prova. In tutti i casi abbiamo (γγ∗)(t) = γ(t)γ∗(t) = I, per cui (γγ∗)′(t) = 0. Dallaosservazione 4.1 si ottiene subito:

(γγ∗)′(0) = γ(0)γ∗′(0) + γ′(0)γ∗(0) = γ∗′(0) + γ′(0) = 0

Il punto 3 segue dai punti 1 e 2 e dai lemmi 4.3 e 4.4.

Osservazione 4.3 Si noti che non abbiamo detto nulla su SU(n) (perche ?). Per dimostrareche le disuguaglianze del punto 3 sono, in realta, uguaglianze e trattare anche il caso di SU(n),avremo bisogno di altri concetti e risultati, la cui importanza va tuttavia molto oltre questoscopo.

5 Esponenziale, Logaritmo e Algebre di Lie

Ad un gruppo di matrici G abbiamo associato, nel paragrafo precedente, uno spazio vettoriale:il suo spazio tangente T (G). In questa parte del corso studieremo gli spazi tangenti dei gruppi dimatrici e ci occuperemo di un metodo per costruire un gruppo a partire da uno spazio vettorialecon particolari proprieta.

Definizione 5.1 Sia A ∈Mn(R) l’esponenziale della matrice A e la serie:

eA = I + A+ A2/2 + A3/3! + .....

Osservazione 5.1 La serie va interpretata nel senso che ∀i, j la matrice eA (quando esiste)ha componenti: (

eA)ij

= Iij + Aij +(A2/2

)ij

+(A3/3!

)ij

+ .....

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 19

Osservazione 5.2 Fortunatamente, la matrice eA esiste sempre:

Lemma 5.1 La serie eA = I + A+ A2/2 + A3/3! + ... converge ad un elemento di Mn(R).

Prova. Sia a = max|Aij|. Pensando di sostituire ogni elemento di A con a si ottiene:

|Aij| ≤ a,∣∣∣(A2/2

)ij

∣∣∣ ≤ na2/2, ...,∣∣∣(Ak/k!

)ij

∣∣∣ ≤ nk−1ak/k!.

Essendo n e a numeri fissati, il criterio del rapporto1 applicato alla successione dei maggiorantici dice che la serie converge in modulo elemento per elemento, cioe per ogni i e j.

Osservazione 5.3 Si puo definire l’esponenziale anche di matrici complesse. Cilimitiamo a ricordare che una successione di numeri complessi zn si dice convergere a z se lasuccessione di numeri reali |zn − z| → 0. Analogamente al caso reale, una serie di numericomplessi si dice convergente se converge la successione delle somme parziali. Una condizionesufficiente perche una serie di numeri complessi converga e che converga, nel senso delle seriedi numeri reali, la serie dei moduli (serie assolutamente convergenti).

Teorema 5.1

1. Se AB = BA allora eA+B = eAeB.

2. eA ∈ GL(n,R).

3. eBAB−1

= BeAB−1.

Prova. Per convincersi del punto 1 basta guardare i primi termini:

eA+B = I + A+B +A2

2+ AB +

B2

2+A3

6+A2B

2+AB2

2+B3

6+ ...

eAeB =

(I + A+

A2

2+A3

6+ ...

)(I +B +

B2

2+B3

6+ ...

)= eA+B

Il punto 2 segue dal punto 1: I = e0 = eA−A = eAe−A = e−AeA, e quindi eA e invertibile avendoun’inversa. Per il punto 3 basta ricordare che:(

BAB−1)n

= BAnB−1

1Sia ak una successione di termini positivi; se limk→∞ak+1

ak< 1, allora la serie

∑ak converge. Nel nostro

caso, ak = nk−1ak/k! e quindi il limite vale 0.

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 20

Esempio 5.1 SO(2) = eA con A ∈ so(2). Se A ∈ so(2) allora eA ∈ SO(2). Cioe:

e

0 −xx 0

=

(cosx − sinxsinx cosx

)

Basta calcolare

(0 −xx 0

)2

=

(−x2 0

0 −x2

),

(0 −xx 0

)3

=

(0 x3

−x3 0

),

(0 −xx 0

)4

=(x4 00 x4

),

(0 −xx 0

)5

=

(0 −x5

x5 0

), ... , applicare la definizione di esponenziale e ricordare

gli sviluppi delle funzioni cosx e sinx :

cosx = 1− x2

2!+x4

4!− ....

sinx = x− x3

3!+x5

5!− ....

Si osservi anche che cio mostra esplicitamente che tutte le matrici di SO(2) (vedi esempio3.1) si ottengono in questo modo.

Osservazione 5.4 Notare che e0 = I, ma invece eA = I non implica A = 0. Ad esempio,

e

0 −2π2π 0

= I.

Esempio 5.2 Se A ∈ so(n) allora eA ∈ O(n). Abbiamo infatti (A e At commutano perchestiamo considerando matrici normali):

I = e0 = eA+At

= eAeAt

= eA(eA)t

E’ bene notare esplicitamente cosa l’esempio non dice; non e vero che ogni matrice ortogonale

e esponenziale di una matrice antisimmetrica (infatti l’esempio 5.1 mostra che

(1 00 −1

)non

si otterra mai per esponenziazione).

Si puo anche definire il logaritmo di una matrice.

Definizione 5.2 Sia A ∈Mn(R) il logaritmo della matrice A e la serie:

logA = (A− I)− (A− I)2 /2 + (A− I)3 /3− (A− I)4 /4 + .....

Lemma 5.2 Per A vicino a I, la serie converge.Prova. Poniamo X = A − I e supponiamo che a = max|Xij|. Pensando di sostituire

ogni elemento di X con a si ottiene:

|Xij| ≤ a,∣∣∣(X2/2

)ij

∣∣∣ ≤ na2/2, ...,∣∣∣(Xk/k

)ij

∣∣∣ ≤ nk−1ak/k

Essendo n e a numeri fissati, il criterio del rapporto applicato alla successione dei maggiorantici dice che la serie converge in modulo elemento per elemento, cioe per ogni i e j, quando a < 1

n.

Infatti nkak+1/k+1nk−1ak/k

→ na, e quindi e < 1 per a < 1n.

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 21

Le relazioni tra esponenziale e logaritmo sono proprio quelle che ci aspettiamo.

Teorema 5.2 Dove le formule hanno senso, elogX = X e log eA = A. Cioe la mappa expA =eA e invertibile per matrici vicine alla matrice 0. Analogamente la mappa log e invertibile permatrici vicino alla matrice I.

Prova. Siccome le serie sono assolutamente convergenti, si possono riarrangiare i termini equindi verificare le formule, esattamente come si fa nel caso delle funzioni di variabile reale ex

e log x.

Lemma 5.3 Dove le formule hanno senso, e se logA e logB commutano fra loro, si ha:log (AB) = logA+ logB.

Prova. elog(AB) = AB = elogAelogB = elogA+logB e quindi, prendendo i logaritmi, si ha latesi.

Osservazione 5.5 Considerata la mappa esponenziale: exp : Mn →Mn, il teorema 5.2 ci diceche l’esponenziale e una mappa suriettiva e iniettiva da un intorno della matrice 0 a un intornodella matrice I.

Dimostremo ora alcune importanti formule relative all’esponenziale di unamatrice qualsiasi, non necessariamente reale (vedi osservazione 5.3)

Teorema 5.3 Sia A(t) una curva passante per l’identita in un gruppo di matrici. Allora:

d

dtdetA = detA · tr(A−1dA

dt)

Prova. Indichiamo con Aij gli elementi di A, e con aij i loro complementi algebrici (ideterminanti moltiplicati per (−1)i+j del minore ottenuto da A eliminando la riga i e la colonna

j). E’ noto che: ∀i, detA =j=n∑j=1

Aijaij e che (A)−1ij = aji

detA(notare lo scambio i ←→ j). Si

ottiene quindi: ∂ detA∂Aij

= aij = (A)−1ji detA. Allora:

d

dtdetA =

i,j=n∑i,j=1

∂ detA

∂Aij· dAijdt

=

i,j=n∑i,j=1

detA · (A)−1ji

dAijdt

= detA · tr(A−1dA(t)

dt)

Lemma 5.4 Sia A ∈Mn e t un numero reale. Allora det etA = 1 ∀t se e solo se trA = 0.

Prova. Siccome ddtetA = etAA, segue dal teorema 5.3 applicato alla curva etA: (il punto 2

del teorema 5.1 ci assicura che cio si puo fare)

d

dtdet etA = det etA · tr(e−tAde

tA

dt) = det etA · tr(e−tAetAA) = det etA · trA

Allora se trA = 0, det etA e una costante e, essendo uguale a 1 in t = 0, e sempre uguale a 1.Viceversa se det etA = 1 la stessa formula fornisce trA = 0.

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 22

Teorema 5.4 Per ogni matrice A ∈ Mn e per ogni numero reale t si ha: det etA = et(trA). Inparticolare, det eA = etrA.

Prova. La formula ricavata per la dimostrazione del lemma 5.4:

d

dtdet etA = det etA · trA,

puo essere interpretata come una equazione differenziale: dxdt

= trA ·x con la condizione inizialex(0) = 1. Integrandola si ottiene x(t) = et(trA), cioe det etA = et(trA)

Possiamo ora concludere il calcolo dello spazio tangente ai gruppi ortogonali e unitari.

Lemma 5.5

1. Se A ∈ so(n) allora γ(t) = etA e una curva passante per l’identita in SO(n) e γ′(0) = A,cioe so(n) ⊆ T (SO(n))

2. Se A ∈ u(n) allora γ(t) = etA e una curva passante per l’identita in U(n) e γ′(0) = A,cioe u(n) ⊆ T (U(n))

3. Se A ∈ su(n) allora γ(t) = etA e una curva passante per l’identita in SU(n) e γ′(0) = A,cioe su(n) ⊆ T (SU(n))

4. In particolare, dimO(n) ≥ n2−n2, dimSO(n) ≥ n2−n

2, dimU(n) ≥ n2, dimSU(n) ≥ n2 − 1.

Prova. Chiaramente γ(0) = e0 = I e γ′(0) = limt→0etA−It

= A. Inoltre:

γ(t)γ(t)∗ = etAetA∗

= et(A+A∗) = I

E quindi γ(t) e una curva passante per l’identita in un gruppo ortogonale o unitario. Ricordandoinoltre (vedi teorema 5.4) che det etA = et(trA), si trova che nei casi 1 e 3, (dove trA = 0), lacurva e tutta in SO(n) e SU(n) rispettivamente.

Teorema 5.5 (Le seguenti uguaglianze rappresentano isomorfismi di spazi vettoriali reali).

1. T (O(n)) = T (SO(n)) = so(n).

2. T (U(n)) = u(n).

3. T (SU(n)) = su(n).

4. In particolare, dimSO(n) = dimO(n) = n(n−1)2

, dimU(n) = n2 e dimSU(n) = n2 − 1.

Prova. I lemmi 4.5 e 5.5 forniscono immediatamente i punti 1 e 2. Per il punto 3, sideve prima di tutto osservare che se γ(t) e una curva passante per l’identita in SU(n) alloraγ′(0) ∈ su(n). Infatti det γ(t) = 1 per cui (vedi teorema 5.3): d

dtdet γ = tr(γ−1 dγ

dt) = 0, e quindi

per t = 0 si ottiene trγ′(0) = 0, e quindi T (SU(n)) ⊂ su(n) e allora dimSU(n) ≤ n2 − 1.Questo permette di concludere la dimostrazione, perche per il lemma 5.5 dimSU(n) ≥ n2 − 1.

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 23

Osservazione 5.6 Si noti che dimSO(3) = dimSU(2) = 3 (so(3) e su(2) sono infatti spazivettoriali isomorfi). Per quanto ne sappiamo fino ad ora SO(3) e SU(2) potrebbero quindiessere gruppi isomorfi. In realta non lo sono (hanno il centro diverso, Z(S(U2)) il centro diSU(2) e costituito dalle matrici I e −I, mentre il centro di SO(3) e la sola matrice I (vedi gliesercizi piu sotto) e questo fatto suggerisce che si debba approfondire lo studio in varie direzioni.

Esercizio 5.1 Sia U(2) il gruppo delle matrici 2× 2 unitarie,

T =

(eiα 00 eiβ

)con α, β ∈ R

e un sottogruppo di U(2) isomorfo a U(1)×U(1). T e massimale, cioe ogni sottogruppo abelianoche lo contiene coincide con lui.

Z(U(2)) =

(eiα 00 eiα

), α ∈ R

= U(1)

Z(SU(2)) =

(±1 00 ±1

)= Z2.

Inoltre si ha: U(2)U(1)

= SU(2)Z2

.

Prova. Le matrici di T appartengono a U(2) perche(eiα 00 eiβ

)−1

=

(e−iα 0

0 e−iβ

)=

(eiα 00 eiβ

)tL’isomorfismo richiesto e: (

eiα 00 eiβ

)→ (eiα, eiβ)

Se A ∈ A ⊂U(2) con A abeliano e contenente T, A deve, in particolare, commutare con ognimatrice di T. Si ottiene quindi, ∀α, β:(

a bc d

)(eiα 00 eiβ

)=

(eiα 00 eiβ

)(a bc d

)(aeiα beiβ

ceiα deiβ

)=

(aeiα beiα

ceiβ deiβ

)⇔ b = c = 0

Ma A ∈ U(2) e quindi deve essere anche aa = dd = 1 e quindi A ∈ T. Per trovare il centrodi U(2) si osservi che, dal calcolo precedente, Z(U(2)) ⊂ T , infatti gli elementi del centrodevono commutare con tutti gli elementi di U(2) e quindi, in particolare, con gli elementi diT. Osserviamo ora che una matrice di T, per essere nel centro, deve commutare anche con(

0 1−1 0

)∈ U(2) e quindi si ha:(

0 1−1 0

)(eiα 00 eiβ

)=

(0 eiβ

−eiα 0

)(eiα 00 eiβ

)(0 1−1 0

)=

(0 eiα

−eiβ 0

)

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 24

Cioe α = β. Osservato che le matrici del tipo

(eiα 00 eiα

)commutano con tutte le matrici, si

vede che non ci sono altre condizioni da imporre. Si ottiene quindi:

Z(U(2)) =

(eiα 00 eiα

), α ∈ R

= U(1)

Il centro di SU(2) si trova ovviamente imponendo alle matrici del centro di U(2) l’ulteriorecondizione che il determinante valga 1 :

Z(SU(2)) =

(±1 00 ±1

)= Z2

Sia ora A ∈ U(2) e indichiamo con ±eiα/2 le due radici complesse di detA = eiα. L’applicazione

ϕ : U(2) → SU(2)Z2

data da ϕ(A) =[eiα/2A

]e ben definita in SU(2)

Z2, dove con le parentesi

quadre abbiamo denotato la classe di equivalenza in SU(2)Z2

, infatti la scelta del segno della

radice e ininfluente perche[eiα/2A

]=[−eiα/2A

]. L’applicazione e un omomorfismo ed e anche

ovviamente suriettivo. Il suo nucleo e dato dalle matrici A per cui ϕ(A) =[±eiα/2A

]= [±I] e

quindi dalle matrici del tipo

(e−iα/2 0

0 e−iα/2

), α ∈ R

= U(1). Il teorema di isomorfismo

consente quindi di concludere che: U(2)U(1)

= SU(2)Z2

Esercizio 5.2 Sia SO(3) il gruppo delle matrici 3× 3 unitarie,

T =

cos t − sin t 0

sin t cos t 00 0 1

t ∈ R

e un sottogruppo di SO(3) isomorfo a SO(2). T e massimale, cioe ogni sottogruppo abelianoche lo contiene coincide con lui e Z(SO(3)) = I.

Prova. L’isomorfismo richiesto e ovviamente:cos t − sin t 0sin t cos t 0

0 0 1

→ (cos t − sin tsin t cos t

)

Se A ∈ A ⊂SO(3) con A abeliano e contenente T, A deve, in particolare, commutare con ognimatrice di T. Considerata la base canonica di R3, T induce tutte le rotazioni del piano e1, e2.Dimostriamo che Ae3 = ±e3. Infatti posto Ae3 = ae1 + be2 + ce3 (con a2 + b2 + c2 = 1)

consideriamo la matrice B =

0 −1 01 0 00 0 1

∈ T. Si ottiene subito: Be1 = e2, Be2 = −e1 e

Be3 = e3. Imponendo la commutativita ABe3 = BAe3 si ottiene subito c = ±1. La matrice Ainduce quindi una trasformazione ortogonale nel piano e1, e2 che commuta con tutte le rotazioni

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 25

di questo piano. Il caso c = −1 pero e escluso perche e immediato che una matrice di O(2)che commuta con tutte le matrice di SO(2) deve appartenere a SO(2) e quindi c = 1 perchealtrimenti il determinante di A varrebbe −1. Abbiamo quindi A ∈ T. Per trovare il centrodi SO(3) si osservi che, dal calcolo precedente, Z(SO(3)) ⊂ T , infatti gli elementi del centrodevono commutare con tutti gli elementi di SO(3) e quindi, in particolare, con gli elementidi T. Osserviamo ora che una matrice di T, per essere nel centro, deve commutare anche con 0 0 1

0 1 0−1 0 0

∈ SO(3) e quindi si ha:

0 0 10 1 0−1 0 0

cos t − sin t 0sin t cos t 0

0 0 1

=

0 0 1sin t cos t 0− cos t sin t 0

cos t − sin t 0

sin t cos t 00 0 1

0 0 10 1 0−1 0 0

=

0 − sin t cos t0 cos t sin t−1 0 0

Cioe t = 0 e quindi A = I.

Osservazione 5.7 Mostreremo in seguito (vedi teorema 6.8 ) che SU(2)Z2

= SO(3).

Osservazione 5.8 Gli spazi vettoriali reali so(n) e su(n) non sono chiusi rispetto al prodottorighe × colonne dei loro elementi. Si puo tuttavia introdurre in essi una operazione interna,chiamata commutatore, che gode di tutte le proprieta sensate del prodotto salvo l’associativita.

Definizione 5.3 Indicando come al solito con T (G) lo spazio tangente di un gruppo ortogonaleo unitario G, siano A e B due suoi elementi. Si definisce commutatore di A e B la matrice:

[A,B] = AB −BA

Lemma 5.6 Siano A,B,C ∈ T (G), il commutatore gode delle seguenti proprieta:

1. [A,B] ∈ T (G)

2. [A,B] = −[B,A]

3. [A,B + C] = [A,B] + [A,C]

4. [A+B,C] = [A,C] + [B,C]

5. ∀a ∈ R, [aA,B] = [A, aB] = a[A,B]

6. [A, [B,C]] + [C, [A,B]] + [B, [C,A]] = 0

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 26

Prova. Per il punto 1 si deve provare che:

(AB −BA) + (AB −BA)∗ = AB −BA+B∗A∗ − A∗B∗ = 0

Basta scrivere:

AB −BA+B∗A∗ − A∗B∗ = AB + (AB∗ − AB∗)−BA+ (BA∗ −BA∗) +B∗A∗ − A∗B∗ =

= A (B +B∗)− (A+ A∗)B∗ + (B +B∗)A∗ −B (A+ A∗) = 0

Nel caso di su(n) occorre anche ricordarsi che, per ogni matrice, tr(AB) = tr(BA) e quindi

tr[A,B] = tr (AB −BA) = tr (AB)− tr (BA) = 0.

Gli altri punti sono tutte banali verifiche basate solo sull’uso della definizione.

Osservazione 5.9 La formula del punto 6 e detta identita di Jacobi, e sostituiscel’associativita per il prodotto A B = [A,B]:

A (B C)− (A B) C = (A C) B e non = 0

Osservazione 5.10 Nel punto 5 e essenziale che a ∈ R, parliamo qui solo di Algebre di Liereali.

Definizione 5.4 Un qualsiasi spazio vettoriale reale V, dotato di un prodotto interno (denotatocon [ , ]V anche nel caso astratto in cui lo spazio vettoriale non sia un sottospazio di Mn) chesoddisfa le proprieta da 2 a 6 del lemma 5.6 e detto Algebra di Lie.

Definizione 5.5 Un omomorfismo di algebre di Lie e una applicazione lineare ϕ tra icorrispondenti spazi vettoriali:

ϕ : V → W

che, inoltre, verifica:ϕ[A,B]V = [ϕ (A) , ϕ (B)]W

Osservazione 5.11 Spazi vettoriali isomorfi come spazi vettoriali possono benis-simo non essere isomorfi come Algebre di Lie. In altre parole, non tutti gliisomorfismi di spazi vettoriali sono isomorfismi di Algebre di Lie. (vedi l’esempio5.4)

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 27

5.1 Algebre di Lie reali di dimensione due

In questo paragrafo denoteremo di verse strutture di algebre di Lie sullo stesso spazio vettorialecon la notazione: [, ]0 , [, ]1 , [, ]2 .

Sia V = R2 con base e1 e e2; a parte la struttura di algebra di Lie banale:

[e1, e2]0 = [e1, e1]0 = [e1, e2]0 = 0 (1)

In generale si deve avere:

[e1, e1]1 = [e1, e2]1 = 0 (2)

[e1, e2]1 = ae1 + be2 = − [e2, e1]1 (3)

con a, b reali e non entrambi nulli. L’identita di Jacobi e automaticamente soddisfatta. Possiamosupporre, senza perdita di generalita, che b 6= 0. Definiamo ora un endomorfismo ϕ di V :

ϕ(e1) = be1 (4)

ϕ(e2) = −ae1 +1

be2 (5)

la matrice associata: (b −a0 1

b

)(6)

e invertibile e quindi ϕ e un isomorfismo di spazi vettoriali. Mostriamo ora che e anche unisomorfismo di algebre di Lie tra la struttura data da [e1, e2]1 = ae1 + be2 e la struttura conprodotto di Lie dato da [e1, e2]2 = e2. Si ha infatti:

ϕ [e1, e2]1 = ϕ (ae1 + be2) = abe1 − abe1 + e2 = e2 (7)

[ϕ (e1) , ϕ (e2)]2 =

[be1,−ae1 +

1

be2

]2

= −ab [e1, e1] +b

b[e1, e2]2 = e2 (8)

Ovvero:ϕ [e1, e2]1 = [ϕ (e1) , ϕ (e2)]2 (9)

Abbiamo quindi dimostrato che, a meno di isomorfismi di algebre di Lie, su R2 ci sono solo duestrutture di algebra di Lie:

[e1, e2]0 = [e1, e1]0 = [e1, e2]0 = 0 (10)

[e1, e1]2 = [e1, e2]2 = 0 (11)

[e1, e2]2 = e2 = − [e2, e1]2 (12)

Queste due algebre di Lie ammettono, come ogni algebra di Lie (teorema di Ado), una rappre-sentazione (ovviamente non unica!) in cui gli elementi di R2 sono matrici, e la parentesi di Liee il commutatore.

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 28

L’algebra con parentesi [, ]0 e rappresentata, ad esempio, da:

e1 =

(1 00 0

), e2 =

(0 00 1

), 0 =

(0 00 0

)(13)

infatti:

[e1, e2]0 =

(1 00 0

)(0 00 1

)−(

0 00 1

)(1 00 0

)=

(0 00 0

)= 0 (14)

Ovvero il punto (x, y) ∈ R2 e rappresentato dalla matrice

(x 00 y

).

L’algebra [, ]2 e rappresentata, ad esempio, da:

e1 =

(1 00 0

), e2 =

(0 10 0

), 0 =

(0 00 0

)(15)

infatti:

[e1, e2]0 =

(1 00 0

)(0 10 0

)−(

0 10 0

)(1 00 0

)=

(0 10 0

)= e2 (16)

Ovvero il punto (x, y) ∈ R2 e rappresentato dalla matrice

(x y0 0

).

Possiamo anche identificare due gruppi di matrici di dimensione due tali che il loro spaziotangente sia isomorfo, come algebra di Lie, alle due algebre descritte sopra.

Per l’algebra banale [, ]0 si ha:

G =

(x 00 y

)con x, y ∈ R∗ > 0

(17)

Mentre per [, ]2 si ha:

H =

(x y0 1

)con x > 0 ∈ R∗ e y ∈ R

(18)

Infatti:

TG =

(x′(0) 00 y

′(0)

)con x

′(0), y

′(0) ∈ R

(19)

TH =

(x′(0) y

′(0)

0 0

)con x

′(0) ∈ R e y

′(0) ∈ R

(20)

Possiamo verificare che, in entrambi i casi, la mappa esponenziale e suriettiva.Nel primo caso si ha:

e

x 00 y

=

(ex 00 ey

)(21)

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 29

e quindi, se

(a 00 b

)∈ G (e allora a, b > 0) esiste un elemento dell’algebra A =

(ln a 00 ln b

)per cui:

eA =

(a 00 b

)(22)

Nel secondo caso, invece, si ha:

e

x y0 0

=

(1 00 1

)+

(x y0 0

)+

1

2

(x2 xy0 0

)+ ...+

1

n!

(xn xn−1y0 0

)+ ... (23)

=

(ex y(1 + 1

2x+ 1

3!x2 + ...+ 1

n!xn−1 + ...)

0 1

)(24)

Osserviamo ora che, se x 6= 0, abbiamo:

(1 +1

2x+

1

3!x2 + ...+

1

n!xn−1 + ...) =

ex − 1

x(25)

e allora:

e

x y0 0

=

(ex y

x(ex − 1)

0 1

)se x 6= 0 (26)

e

0 y0 0

=

(1 y0 1

)(27)

Se allora

(a b0 1

)∈ H (con a > 0) se a 6= 1 esiste un elemento dell’algebra A =

(ln a b

a−1ln a

0 0

)per cui:

eA =

(a b0 1

)(28)

Mentre se a = 1 si ha:

e

0 b0 0

=

(1 b0 1

)(29)

E quindi anche in questo caso l’esponenziale e suriettivo come mappa tra lo spazio tangente eil gruppo.

la classificazione delle algebre di Lie reali di dimensione tre e gia molto piu complicata e cilimitiamo qui a dare alcuni esempi di algebre di Lie tridimensionali non banali e non isomorfetra loro.

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 30

5.2 Alcune algebre tridimensionali (so(3), su(2), sl(2,R), so(2, 1))

Esempio 5.3 In questo esempio studiamo so(3) e su(2). Una base dello spazio vettorialereale so(3) e:

A1 =

0 0 00 0 −10 1 0

, A2 =

0 0 10 0 0−1 0 0

, A3 =

0 −1 01 0 00 0 0

.

E’ facile verificare che la sua struttura di Algebra di Lie e data da:

[A1, A2] = A3, [A2, A3] = A1, [A3, A1] = A2.

Una base dello spazio vettoriale reale su(2) e:

U1 =

(i 00 −i

), U2 =

(0 1−1 0

), U3 =

(0 ii 0

).

E’ facile verificare che la sua struttura di Algebra di Lie e data da:

[U1, U2] = 2U3, [U2, U3] = 2U1, [U3, U1] = 2U2.

Un isomorfismo di Algebre di Lie (e non solo di spazi vettoriali) e dato da:

ϕ(Ui) = 2Ai.

Infatti, ad esempio,

ϕ[U1, U2]su(2) = ϕ(2U3) = 2ϕ(U3) = 4A3

ϕ[U3, U1]su(2) = ϕ(2U2) = 2ϕ(U2) = 4A2

ϕ[U2, U3]su(2) = ϕ(2U1) = 2ϕ(U1) = 4A1

ed anche:

[ϕ (U1) , ϕ (U2)]so(3) = [2A1, 2A2]so(3) = 4 [A1, A2]so(3) = 4A3 ed analoghe.

Per cui:ϕ[Ui, Uj]su(2) = [ϕ (Ui) , ϕ (Uj)]so(3).

Esempio 5.4 (Un non esempio) L’isomorfismo ovvio ϕ(Ui) = Ai non e un isomorfismodi Algebre di Lie (perche?).

Esempio 5.5 Esponenziale degli elementi della base di so(3) e sottogruppi abeliania un parametro di SO(3). Posto (vedi lemma 5.5 ed esempio 5.1):

Ri(t) = etAi ,

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 31

si verifica facilmente che:

R1(t) =

1 0 00 cos t − sin t0 sin t cos t

, R2(t) =

cos t 0 sin t0 1 0

− sin t 0 cos t

, R3(t) =

cos t − sin t 0sin t cos t 0

0 0 1

.

e che gli Ri = Ri(t), t ∈ R sono sottogruppi abeliani a un parametro di SO(3) (isomorfi

a SO(2)). Le matrici di Ri operano sui vettori di R3, rappresentati da

xyz

come rotazioni

in senso antiorario attorno, rispettivamente, R1 all’asse x, R2 all’asse y, R3 all’asse z. E’noto dall’algebra lineare (vedi piu sotto anche l’esempio 6.2) che per ogni matrice R di SO(3)esiste in R3 una base ortonormale in cui R = B−1AB, con A ∈ R3 e B ∈ O(3). Ricordandoche A ∈ R3 significa che A = etA3 per un certo t, ed il punto 3 del teorema 5.1, si ottieneR = B−1etA3B = etB

−1A3B. Essendo B−1 = Bt si verifica facilmente che B−1A3B ∈ so(3), cioel’esponenziale e suriettivo in grande: ogni matrice di SO(3) e ottenuta esponenziandouna matrice di so(3).

Esempio 5.6 In questo esempio definiamo e studiamo i gruppi SL(2, R) e SO(2, 1) ele loro algebre di Lie. Dimostreremo che sono tridimensionali e isomorfe fra loro, e che nonsono isomorfe alle algebre studiate nell’esempio precedente. Il gruppo SL(2,R) e definito comel’insieme delle matrici reali 2 × 2 con determinante uguale a 1. L’algebra di Lie di SL(2,R)e lo spazio sl(2,R) delle matrici reali 2× 2 con traccia nulla. Infatti una curva in SL(2,R) edata da una matrice

A(t) =

(a(t) b(t)c(t) d(t)

)con detA(t) = 1 e a(0) = d(0) = 1 e b(0) = c(0) = 0. Quindi un vettore tangente nell’origine

e dato da una matrice del tipo

(a′(0) b′(0)c′(0) −a′(0)

)e quindi T (SL(2,R)) ⊆ sl(2,R). Viceversa,

la matrice

(a bc −a

)e il vettore tangente alla curva e

t

a bc −a

che appartiene tutta a

SL(2,R) perche

det et

a bc −a

= e

ttr

a bc −a

= 1

e quindi sl(2,R) ⊆ T (SL(2,R)) . Sia ora B : R3 ×R3 → R3 la forma bilineare simmetrica nondegenere di segnatura (2, 1) data da

B(x, y) = x1y1 + x2y2 − x3y3.

La matrice associata a B nella base standard di R3 e:

Q =

1 0 00 1 00 0 −1

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 32

Il gruppo SO(2, 1) e l’insieme delle matrici reali 3 × 3 con determinante 1 che conservano B,ovvero A ∈ SO(2, 1) se e solo se

detA = 1 e B(Ax,Ay) = B(x, y)

per ogni coppia di vettori x e y in R3. Si verifica facilmente che A conserva B se e solo se

ATQA = Q.

L’algebra di Lie del gruppo SO(2, 1) e lo spazio so(2, 1) delle matrici 3×3 reali X che soddisfano

XTQ+QX = 0.

Questa identita implica che le matrici di so(2, 1) sono tutte e sole le matrici del tipo

X =

0 a b−a 0 cb c 0

con a, b, c ∈ R

Una curva A(t) in SO(2, 1) verifica A(t)TQA(t) = Q e A(0) = I. La derivata A′(0) verificaallora A′(0)TQ + QA′(0) = 0. Viceversa ogni matrice tale che XTQ + QX = 0 e la derivatain zero di una curva in SO(2, 1). Posto A(t) = etX si ha infatti: det etX = ettrX = 1 perchetrX = 0; inoltre si ha:

Q−1etXT

Q = etQ−1XTQ = e−tX (perche Q2 = I)

e quindi:etX

T

QetX = Qe−tXetX = Q

Si ha poi il seguente fatto: le due algebre di Lie so(2, 1) e sl(2, R) sono isomorfe traloro e non sono isomorfe a so(3) = su(2).

Prova. Innanzi tutto osserviamo che le due algebre di Lie sono entrambe di dimensione 3e che quindi sono isomorfe come spazi vettoriali. Una base di so(2, 1) e data da

H =

0 1 0−1 0 00 0 0

, X =

0 0 10 0 01 0 0

, Y =

0 0 00 0 10 1 0

.

Calcoliamo le parentesi di Lie tra queste matrici. Ad esempio

[H,X] =

0 1 0−1 0 00 0 0

0 0 10 0 01 0 0

− 0 0 1

0 0 01 0 0

0 1 0−1 0 00 0 0

= −Y

Analogamente si verifica che

[H, Y ] = X e [X, Y ] = H.

5 ESPONENZIALE, LOGARITMO E ALGEBRE DI LIE 33

Ora confrontiamo questo risultato con quello che accade su sl(2,R). Una base (molto usata)di sl(2,R) e data da

L =

(1 00 −1

), M =

(0 10 0

), N =

(0 01 0

).

Si calcola facilmente che le parentesi di Lie sono date da

[L,M ] = 2M, [L,N ] = −2N, [M,N ] = L.

Non pare esserci molta somiglianza tra queste relazioni e quelle trovate tra H,X e Y . Tuttavianotiamo che la matrice M−N assomiglia a H. Proviamo quindi come nuova base H ′ = M−N ,X ′ = L e Y ′ = M +N . Si ottiene:

[H ′, X ′] = [M −N,L] = 2M + 2N = −2Y ′,

[H ′, Y ′] = [M −N,M +N ] = 2L = 2X ′, (30)

[X ′, Y ′] = [L,M +N ] = 2M − 2N = 2H ′. (31)

A parte le costanti moltiplicative queste relazioni sono quasi identiche a quelle tra H,X e Y .Infatti se ora prendiamo l’applicazione lineare ϕ tra so(2, 1) e sl(2,R) data da

H 7→ H ′

2

X 7→ X ′

2

Y 7→ Y ′

2

si vede subito che ϕ conserva le parentesi di Lie. Osserviamo ora che sl(2,R) non puo essereisomorfa a so(3); infatti dalle relazioni di commutazione di so(3) si vede che la parentesidi Lie di due vettori tangenti indipendenti e indipendente da questi (l’algebra e isomorfa aquella del prodotto vettoriale), mentre in sl(2,R) questo non e vero in generale (ad esempio[L,M ] = 2M).

5.3 Sottogruppi ad un parametro

Definizione 5.6 Un sottogruppo a un parametro in un gruppo di matrici G e l’immagine diun omomorfismo differenziabile ϕ :

ϕ : R→ G

Osservazione 5.12 Con abuso di notazione spesso ϕ stesso si dice sottogruppo a un parametro,tali sottogruppi sono abeliani, infatti

ϕ(t)ϕ(s) = ϕ(t+ s) = ϕ(s+ t) = ϕ(s)ϕ(t)

6 CONSIDERAZIONI TOPOLOGICHE 34

Osservazione 5.13 Si noti che per conoscere ϕ basta definirlo in un piccolo intorno di t = 0,infatti, ∀t ∈ R, e per ogni intero n,

[ϕ( 1

nt)]n

= ϕ(n 1nt) = ϕ(t) e quindi ϕ( 1

nt) determina ϕ(t).

Esempio 5.7 ϕ(t) = etA con A matrice n× n e un sottogruppo a un parametro di GL(n,R) eϕ′(0) = A.

Questo esempio e, in un certo senso, generale:

Teorema 5.6 Sia ϕ(t) un sottogruppo a un parametro di GL(n,R), allora esiste una matriceA tale che ϕ(t) = etA.

Prova. Per l’osservazione 5.13 basta limitarsi a un piccolo intorno di t = 0. Poniamoα(t) = logϕ(t); questa e una curva in Mn e ϕ(t) = eα(t). Sia α′(0) = A. Vogliamo mostrare cheα(t) = tA. Infatti, per ogni t si ha:

α′(t) = lims→0

α(t+ s)− α(t)

s= lim

s→0

logϕ(t+ s)− logϕ(t)

s= lim

s→0

log [ϕ(t)ϕ(s)]− logϕ(t)

s=

= lims→0

logϕ(t) + logϕ(s)− logϕ(t)

s= lim

s→0

logϕ(s)− logϕ(0)

s= α′(0) = A

Dove abbiamo usato il fatto che logϕ(0) = log I = 0 e che ϕ(t) e ϕ(s) commutano fra loro (vedilemma 5.3. Si ha allora la tesi: α(t) = tA.

Teorema 5.7 C’e corrispondenza biunivoca tra i vettori tangenti a GL(n,R) e i suoisottogruppi a un parametro.

Prova. Sappiamo gia che ogni matrice n× n e un vettore tangente a GL(n,R) e viceversa(vedi 4.3), e abbiamo gia osservato che ad ogni matrice corrisponde un sottogruppo a unparametro. Il teorema 5.6 dimostra anche che ad ogni sottogruppo corrisponde un vettoretangente.

Osservazione 5.14 Lo stesso e ovviamente vero anche per GL(n,C).

Osservazione 5.15 Il teorema e facilmente dimostrabile anche per SO(n), O(n), U(n) eSU(n). Basta osservare che a ogni vettore tangente A ad uno dei gruppi citati corrispondeil sottogruppo etA e che questo sottogruppo (vedi la dimostrazione del lemma 5.5) e sottogruppodei gruppi citati. Viceversa ad ogni sottogruppo dei gruppi citati corrisponde un vettore tangenteai gruppi citati (vedi teorema 5.6 e lemma 4.5).

6 Considerazioni topologiche

6.1 Connessione e suriettivita dell’esponenziale

Ricordando che i gruppi di matrici sono sottoinsiemi di qualche Rn che sono spazi metrici, adesempio con l’usuale distanza euclidea d, e chiaro che sono essi stessi spazi metrici.

6 CONSIDERAZIONI TOPOLOGICHE 35

Definizione 6.1 Sia G un gruppo di matrici, la componente connessa con l’identita, (indicatacon G0) e l’insieme degli elementi di G che possono essere connessi all’identita tramite unacurva (continua e tutta contenuta in G). In altre parole, g ∈ G0 se e solo se esiste una curvaγ continua e tale che: γ(t) ∈ G, γ(0) = I, γ(1) = g.

Definizione 6.2 G e connesso se G0 = G.

Osservazione 6.1 Questa definizione di connessione e quella che in topologia e usualmentechiamata connessione per archi.

Teorema 6.1 G0 e un sottogruppo normale di G. Il quoziente G/G0 ≡ π0(G) e detto gruppodelle componenti connesse di G.

Prova. Dati h, k ∈ G0 indicheremo con h(t) e k(t), rispettivamente, le curve tali che:

h(0) = k(0) = I e h(1) = h, k(1) = k

G0 e un sottogruppo perche la curva g(t) = h(t)k(t) e tale che g(0) = I e g(1) = hk; inoltrela curva g(t) = (h(t))−1e tale che g(0) = I e g(1) = h−1. E’ anche normale, perche ∀a ∈ G eh ∈ G0, la curva g(t) = ah(t)a−1 verifica g(0) = I e g(1) = aha−1 e quindi aha−1 ∈ G0.

Esempio 6.1 GL(n,R) non e connesso. Il determinante e una applicazione continua e su-riettiva da GL(n,R) a R∗, per cui se GL(n,R) fosse connesso, lo sarebbe anche R∗, chepero, ovviamente, non lo e. Dimostreremo in seguito che GL0(n,R) = A| detA > 0, equindi π0 (GL(n,R)) contiene due elementi, rappresentati rispettivamente dalle matrici condeterminante positivo o negativo.

Osservazione 6.2 Nel caso di GL(n,C) il ragionamento precedente non si applica. Questaosservazione pero non e una dimostrazione del fatto (vedi piu sotto) che GL(n,C) e connesso.

Osservazione 6.3 O(n) non e connesso. Anche qui basta considerare il determinante; puoessere solo 1 o −1 e quindi una curva continua tutta contenuta in O(n) non puo connettere I euna matrice di O(n) con determinante −1 (il determinante dovrebbe passare per il valore zero).

Osservazione 6.4 Nel caso di SO(n) il ragionamento precedente non si applica. Questa os-servazione pero non e una dimostrazione del fatto che SO(n) e connesso (vedi piu sotto), anzi,e proprio la componente connessa con l’identita di O(n).

Esempio 6.2 SO(3) e connesso. (Vedi anche esempio 5.5)

Prova. Vogliamo mostrare che ogni elemento di SO(3) e connesso all’identita da una curvatutta contenuta in SO(3). Dimostriamo prima di tutto che per ogni matrice R di SO(3) esistein R3 una base ortonormale in cui R = B−1AB, con A ∈ R3 e B ∈ O(3).

6 CONSIDERAZIONI TOPOLOGICHE 36

• R ∈ SO(n) con n dispari, ammette sempre l’autovalore 1; basta calcolare:

det(R− I) = det(R−RRt) = detR det(I −Rt) = det(I −R) = (−1)n det(R− I)

Si ottiene quindi det(R− I) = 0.

• V , l’autospazio dell’autovalore 1, non puo avere dimensione 2. Infatti se ha dimensione2, siano u, v ∈ V di lunghezza 1 e ortogonali tra loro, e sia w ∈ V ′ (il complementoortogonale di V ) anch’esso di lunghezza 1. Si ottiene: (Rw, u) = (Rw,Ru) = (w, u) = 0e (Rw, v) = (Rw,Rv) = (w, v) = 0. Ne segue allora Rw ∈ V ′, (cioe il sottospazio V ′

e invariante sotto R) ma la dimensione di V ′ e 1 e quindi Rw = ±w (si ricordi chegli autovalori possibili per R sono solo ±1). Il caso −1 e impossibile perche allora lamatrice R avrebbe come autovalori 1, 1,−1 e quindi il suo determinante non potrebbeessere uguale a 1. Nel caso +1, seguirebbe che V ha dimensione 3, e quindi V ′ sarebberidotto al solo vettore nullo.

• Se V ha dimensione 3 non c’e nulla da dimostrare: nella base u, v, w si ha R = I.

• Nel caso in cui V ha dimensione 1, V ′ ha dimensione 2. Sia u, v, w una base ortonormaledi R3 = V ′⊕ V . In questa base, essendo V ′ e invariante sotto R, la matrice R assume laforma (abbiamo indicato con B ∈ O(3) la matrice di passaggio dalla base canonica di R3

alla base u, v, w):

A = BRB−1 =

a b 0c d 00 0 1

.

Essendo A ortogonale e di determinante 1, deve essere

(a bc d

)=

(cosα − sinαsinα cosα

)(con

α 6= 0) e quindi:R = B−1AB = B−1eαA3B

• Il gruppo SO(3) e quindi connesso perche la curva: (vedi esempio 5.5)

γ(t) = B−1etαA3B = etB−1αA3B ∈ SO(3)

e verifica γ(0) = I e γ(1) = R.

Osservazione 6.5 La curva costruita sopra e un sottogruppo a un parametro: abbiamomostrato che SO(3) non solo e connesso, ma e anche connesso per sottogruppi a un parametro.

Osservazione 6.6 Gli esempi 5.1 e 5.5 ci mostrano che la mappa esponenziale e suriet-tiva in grande. Ogni matrice di SO(2) e ogni matrice di SO(3) si ottengono quindi peresponenziazione di matrici di so(2) e so(3) rispettivamente. Dimostreremo piu sotto che lostesso e vero per SO(n).

6 CONSIDERAZIONI TOPOLOGICHE 37

Osservazione 6.7 Ricordiamo che la mappa esponenziale e anche iniettiva in piccolo, perchein un intorno della matrice 0 ha un’inversa (il logaritmo), ma non puo essere iniettiva in grande,perche altrimenti SO(2) e SO(3) sarebbero diffeomorfi (tramite exp) ai loro spazi tangenti equesto e ovviamente falso perche SO(2) e SO(3) sono compatti (nella usuale topologia metrica)mentre i loro spazi tangenti, essendo spazi vettoriali, non lo sono certamente.

Esempio 6.3 SU(2) e U(2) sono connessi (per sottogruppi a un parametro). In particolare lamappa esponenziale e suriettiva in grande.

Prova. Mostriamo che ogni elemento R di SU(2) e connesso all’identita da un sottogruppoa un parametro di SU(2) . Sappiamo che R ∈ SU(2), essendo normale, e diagonalizzabiletramite matrici unitarie e che una sua forma diagonale D e (vedi teorema 3.4; per la definizionedi U1 vedi esempio 5.3): D = URU∗ con U ∈ U(2).

D =

(eiα 00 e−iα

)= e

iα 00 −iα

= eαU1

Essendo R = U∗DU = U∗eαU1U = eαU∗U1U , abbiamo che il sottogruppo a un parametro

R(t) = etαU∗U1U soddisfa R(t)R(t)∗ = I, R(0) = I, e R(1) = R. Si ha inoltre:

detR(t) = etr(tαU∗U1U) = etαtr(U

∗U1U) = e0 = 1,

E quindi R(t) ∈ SU(2).Il caso di U(2) e perfettamente analogo (vedi teorema 3.4):

D =

(eiα 00 eiβ

)= e

iα 00 iβ

Essendo

R = U∗DU = U∗e

iα 00 iβ

U = e

U∗

iα 00 iβ

U

abbiamo che il sottogruppo a un parametro R(t) = etU∗

iα 00 iβ

Usoddisfa: R(t)R(t)∗ = I,

R(0) = I, R(1) = R.

Teorema 6.2 SU(n) e U(n) sono connessi (per sottogruppi a un parametro). In particolarela mappa esponenziale e suriettiva in grande.

Prova. Essendo le matrici di SU(n) e U(n) diagonalizzabili mediante matrici unitarie, ladimostrazione e perfettamente analoga a quella del caso n = 2.

Osservazione 6.8 Il caso di SO(n) e piu complicato. Infatti tali matrici non sono tutte dia-gonalizzabili perche non hanno sempre abbastanza autovalori reali. Si puo dimostrare pero che,come nel caso di SO(3), possono essere messe in una forma a blocchi particolarmente semplicemediante matrici ortogonali.

6 CONSIDERAZIONI TOPOLOGICHE 38

6.2 Il caso di O(n) e SO(n)

Per dimostrare la connessione di SO(n) occorre descrivere un modo per mettere le matrici diO(n) in una forma particolarmente semplice.

Sia A ∈ O(n), e consideriamo la matrice S = A+At. Si verifica immediatamente il seguentelemma:

Lemma 6.1 S e simmetrica, (A± I)t (A± I) = 2I ± S e inoltre: SA = AS.

Come ogni matrice simmetrica, S ha autovalori reali ed e diagonalizzabile tramite unamatrice ortogonale (vedi teorema 3.6). Siano λi (i = 1, .., k) i suoi autovalori e Vi i corrispondentiautospazi; si ha Rn = V1 ⊕ V2 ⊕ ...Vk.

Lemma 6.2 I Vi sono fra loro ortogonali e invarianti rispetto a A, cioe A (Vi) ⊆ Vi.

Prova. I Vi sono ovviamente ortogonali fra loro perche autospazi di autovalori distinti. Siaora v ∈ Vi, si ha:

SAv = ASv = Aλiv = λiAv

Quindi nella base ortogonale data dalla unione delle basi ortogonali dei singoli autospazi diS, la matrice A si presentera come una matrice a blocchi, perche la sua azione non mescola traloro i Vi. Studiamo ora l’azione sui singoli blocchi. Ci sono due casi distinti:

Lemma 6.3 Se λi = ±2, A opera su Vi come moltiplicazione per ∓1. Se invece λi 6= ±2, Anon ha autovettori ∈ Vi. In particolare, v e Av, per λi 6= ±2 e v ∈ Vi, sono indipendenti.

Prova. Se λi = ±2, (A± I)t (A± I) v = (2I ± S) v = 0. Segue che:

0 =⟨(A± I)t (A± I) v, v

⟩= 〈(A± I) v, (A± I) v〉

e quindi (A± I) v = 0, cioe Av = ∓v.E’ noto (vedi teorema 3.5) che i possibili autovalori di una matrice ortogonale sono ±1, e

quindi se A avesse autovettori ∈ Vi, sarebbe λi = ±2. Segue anche che v e Av, per v ∈ Vi, sonoindipendenti perche se fossero dipendenti Av = αv e quindi v ∈ Vi sarebbe autovettore di A.

Sia ora W = Span v,Av .

Lemma 6.4 W e invariante per A, cioe A (W ) ⊆ W.

Prova. Sia w ∈ W, w = av + bAv, con v ∈ Vi, cioe Sv = (A+ At) v = λiv. Si ha:(A+ At − λi) v = 0, cioe, moltiplicando per A :(

A2 + I − λiA)v = 0

e quindi:A(av + bAv) = aAv + bA2v = aAv − b (I − λiA) v ∈ W.

Riassumendo, possiamo enunciare il seguente teorema:

6 CONSIDERAZIONI TOPOLOGICHE 39

Teorema 6.3 Per ogni matrice A di O(n) esiste una base ortogonale di Rn in cui la matricee a blocchi. La struttura dei blocchi e la seguente: ci sono n1 blocchi 1 × 1 costituiti da 1, n2

blocchi 1 × 1 costituiti da −1, n3 blocchi 2 × 2 costituiti da matrici ortogonali Ri i = 1...n3.(n = n1 + n2 + 2n3). Inoltre detRi = 1, cioe Ri ∈ SO(2).

Prova. La struttura a blocchi si ricava direttamente dai precedenti lemmi. Per dimostrareche detRi = 1, supponiamo che detRi = −1, allora la matrice si puo scrivere:

Ri =

(α ββ −α

)con α2 + β2 = 1.

Sappiamo che, per v ∈ Vi, (Ri +Rti − λi) v = 0 e quindi det

(2α− λi β

β −2α− λi

)= 0.

Questo implica λi = ±2 che e assurdo, perche stiamo proprio considerando il caso λi 6= ±2.Se ora supponiamo A ∈ SO(n), il numero n2 (il numero di volte in cui appare −1) sulla