UNIVERSITA’ DEGLI STUDI DI TORINOgoy/materiale/1718/tesiSardo.pdf · principali tecniche di...

Transcript of UNIVERSITA’ DEGLI STUDI DI TORINOgoy/materiale/1718/tesiSardo.pdf · principali tecniche di...

1

UNIVERSITA’ DEGLI STUDI DI TORINO

FACOLTA’ DI LETTERE E FILOSOFIA

CORSO DI LAUREA SPECIALISTICA IN

COMUNICAZIONE NELLA SOCIETA’

DELL’INFORMAZIONE

TESI DI LAUREA

Search engine optimization nel percorso evolutivo dei

motori di ricerca e nel Web semantico.

Candidato: Relatore:

Andrea Sardo Prof.ssa Anna Goy

ANNO ACCADEMICO 2007/2008

2

3

INDICE

INTRODUZIONE…………………………………..….7

Scenario………………………………………….……..7

Che cos’è un motore di ricerca…….…………………...9

Obiettivi della tesi……………………….……………..11

CAPITOLO I……………………………………..…….14

1.1 Prima di Google.……………….……..………..14

1.2 I motori di seconda generazione…….………...16

1.2.1 L’avvento di Google………………...………...16

1.2.2 Yahoo e le directories…...……….…………….19

1.2.3 Gli altri……………………….………..………20

1.3 I metamotori…………………...………….......24

1.4 Il clustering………………………....................25

1.5 Scenari futuri………….………………...…….29

1.6 Dentro Google: interfaccia utente...…………..34

CAPITOLO II……………………………………………39

2.0 Dentro il motore………………………………….39

4

2.1 La ricerca……………………................................39

2.2 L’Information Retrieval……….....…………….…43

2.2.1 Automatic text analysis…………………………...45

2.2.2 Retrieval strategies……………………………….51

2.3 L’IR nei motori di ricerca sul Web………..………64

2.3.1 Nuovi approcci nella ricerca……………………....65

CAPITOLO III……………………………….…………68

3.0 Introduzione…………………………………..……68

3.1 Un po’ di storia dei motori di ricerca………..……..68

3.2 Un’idea semplice: le citazioni……………...………70

3.3 L’algoritmo PageRank…………………..…………74

3.3.1 Presupposti matematici…………………….………75

3.3.2 La formula del PageRank……………… ………….77

3.3.3 Random surfer model………………………….…...79

3.3.4 Qualità dei risultati………………………………...81

3.3.5 PageRank in continuità con l’IR…………………....84

3.4 Debolezze del sistema basato sulla link analysis.…..88

3.5 Gli aggiornamenti……………………………..…….90

3.5.1 Algoritmo HillTop……………………………….…91

3.5.2 Algoritmo TrustRank…………………………….…96

3.6 Nuovi orizzonti della ricerca sul We….……………103

3.6.1 Il Web semantico ……………………………..……104

3.6.2 Agenti intelligenti?....................................................107

5

CAPITOLO IV………………………………………...…..110

4.0 Introduzione…………………………………………..110

4.1 Search engine optimization………………...…….......114

4.2 Le variabili di pagina…………………………………116

4.3 Fattori strutturali………………………………….…..122

4.4 Link factors……………………………………..…….126

4.5 Content factors………………………………………..129

4.6 Altri fattori……………………………………...…….132

4.7 Spam e sovraottimizzazione………………………….134

CONCLUSIONI……………………...…………...…….....139

BIBLIOGRAFIA………………………………….….....…144

6

7

INTRODUZIONE

Scenario

Che sia ricordato per la sua origine dal termine googol, coniato

dal matematico Sirotta per rappresentare l’esorbitante numero

uno seguito da cento zeri, o dal goggles – occhiale protettivo -

della lingua inglese, con il quale si sottolinea la sua capacità di

rendere più nitida la visione all’interno della confusa e

labirintica struttura della Rete, Google1 esula da definizioni

esaustive o possibilità di catalogazione. Quello che hanno creato

Larry Page e Sergey Brin nella seconda metà degli anni Novanta

non ha “solamente” ridettato per intero i metodi di fruizione e i

criteri di archiviazione dell’informazione sul Web. La

conseguenza più importante della loro intuizione sta infatti

proprio nella premessa teorica da essi successivamente

sviluppata: quella secondo cui un motore di ricerca basato

sull’attribuzione di un valore matematico alle relazioni tra siti

Web produca risultati migliori rispetto alle tecniche empiriche

usate in precedenza.

Questo modo di pensare ha permesso, in primo luogo, di

sistematizzare tramite una serie di regole formali

l’indicizzazione dei siti all’interno dei motori di ricerca,

migliorandola in termini di razionalità e fugando in parte quel

senso di indeterminata sconfinatezza che si avverte di fronte alla

ragnatela mondiale. In secondo luogo, tale approccio ha dato un

senso e una spinta allo sviluppo del Web sotto il punto di vista

commerciale, portandolo a essere un medium di punta per la

pubblicità. Se prima i banner e il direct marketing avevano

lasciato l’impressione che Internet avesse potenzialità blande

1 http://www.google.com.

8

sotto il profilo promozionale, un’indicizzazione sensata e

razionale dei siti, insieme alla nascita di sistemi come Adwords2

e Adsense3 hanno dato concreti saggi del potere della visibilità,

che ha incominciato a fare gola a tutti.

In un Web 2.04 che ha ulteriormente acuito la tendenza social

già preannunciata nel primo boom della Rete, gli addetti ai

lavori (e non solo loro) si sono mossi immediatamente, per

cogliere le opportunità economiche derivanti da questa

transizione. Da un lato, le aziende hanno intuito l’importanza

dell’essere presenti online con una posizione di preminenza

rispetto ai concorrenti. Dall’altro, i motori di ricerca hanno

fornito la struttura per pianificare l’ingresso in Internet a

tavolino, programmando investimenti e risultati. In mezzo, tante

società di consulenza che si premurano di implementare le

strategie dei propri clienti sui motori.

Come spesso accade, la corsa all’oro ha portato ad eccessi ed

esagerazioni. Chi richiede una campagna di Web marketing,

spesso ignorandone gli strumenti operativi, pretende risultati

immediati ed improbabili. D’altro canto, sul Web sono spuntate

come funghi le società che si occupano di SEO, Search Engine

Optimization. Alcune sono molto serie e ottengono risultati

credibili e persistenti. Ma molte altre promettono la luna,

2 AdWords è il servizio che Google offre agli inserzionisti per inserire il proprio sito all'interno dei risultati di ricerca, in uno speciale spazio dedicato dal nome “collegamenti sponsorizzati”. Il servizio non è gratuito, ha un costo per click, stabilito in precedenza dall'inserzionista, che viene scalato dal budget a disposizione ogni volta che un utente clicca sull'annuncio (pay-per-click). Tra le varie possibilità di personalizzazione degli annunci, particolarmente interessante per questa ricerca risulta quella di scegliere le parole chiave per la visualizzazione dell'annuncio (http://it.wikipedia.org/wiki/Google#AdWords) 3 AdSense è il canale pubblicitario di Google che permette di guadagnare con il proprio sito. È un algoritmo che scansiona in automatico il contenuto delle pagine Web e pubblica in una sezione dedicata gli annunci più pertinenti al sito. La remunerazione è basata principalmente sul sistema del pay-per-click: Google paga qualche centesimo di dollaro ogni volta che un utente clicca sull'annuncio AdSense (http://it.wikipedia.org/wiki/Google#AdSense)

4 Il Web 2.0, secondo una definizione comune e semplificatoria, differisce dal concetto iniziale di Web, retroattivamente etichettato Web 1.0, perché si discosta dai classici siti web statici, dall'e-mail, dall'uso dei motori di ricerca, dalla navigazione lineare e teorizza una rete più dinamica e interattiva. Esempi di tale dinamicità sono dati dal social commerce - l'evoluzione dell'E-Commerce in senso interattivo – e dai social network, che consentono una maggiore partecipazione degli utenti attraverso blog, forum, sistemi di feedback ecc. (it.wikipedia.org/wiki/Web_2.0)

9

operano con metodi discutibili (passibili di penalità da parte del

motore di ricerca) e in generale non portano a concreti

miglioramenti in termini di visibilità.

L’unico modo a nostra disposizione per districarci in questa

spirale speculativa, consiste nel conoscere e studiare

approfonditamente i meccanismi interni che regolano il

funzionamento di un motore di ricerca. Questo significa, nello

specifico, comprendere le logiche e le dinamiche proprie

dell’Information Retrieval5 e applicarle al contesto dei motori di

ricerca: in breve, determinare quali sono gli elementi chiave nel

processo di ricerca e indicizzazione delle pagine Web, in che

modo sono tra di loro interconnessi e tali conoscenze possano

essere utili per ottenere maggiore visibilità.

Che cos’è un motore di ricerca

Prima di addentrarci in questioni tecniche, è opportuno

introdurre alcuni concetti la cui menzione, tutt’altro che

puramente nozionistica, è fondamentale per la comprensione

successiva. Inoltre, la definizione di tali elementi

apparentemente ovvi può essere utile a sgombrare il campo da

eventuali equivoci o ambiguità.

Innanzitutto, che cos’è un motore di ricerca e come funziona a

livello macroscopico?

Un motore di ricerca, o search engine, è “un sistema

automatico, che analizza un insieme di dati e restituisce un

indice dei contenuti disponibili, classificandoli in base a formule

matematiche che ne indichino il grado di rilevanza data una

5 L'information retrieval (IR) è l'insieme delle tecniche utilizzate per il recupero mirato dell’informazione in formato elettronico. Per "informazione" si intendono tutti i documenti, i metadati, i file presenti all'interno di banche dati online.

10

determinata chiave di ricerca”6. In parole semplici, il motore

analizza dei dati in input, forniti dall’utente, ed effettua una

ricerca su tale base, offrendo come output una lista di voci,

poste in ordine decrescente d’importanza, in base ai criteri di

restituzione dell’output con i quali è stato impostato.

È statisticamente provato che l' 85% degli utenti di Internet si

serve dei motori di ricerca per effettuare le proprie ricerche sul

Web7. I motori di ricerca svolgono un importante servizio di IR.

Quando, a partire dagli anni Novanta, Internet cominciò a

riempirsi di milioni di documenti, si avverti l'esigenza di

catalogarli, riordinarli, indicizzarli. In altri termini, era

necessario adottare un sistema "bibliotecario" per consentire agli

utenti di rinvenire in tempi brevi le informazioni desiderate.

Parlando di catalogazione, è opportuno chiarire sin da subito un

possibile elemento di confusione. Spesso, infatti, si parla

indistintamente di motori di ricerca per indicare qualunque

strumento per il reperimento dell’informazione. Ma esistono in

realtà differenze ragguardevoli sia nel modo di organizzare la

ricerca, sia in quello di presentare i risultati.

Per questo introduciamo ora il concetto di directory. Perché

troppo spesso le directories vengono integrate nella definizione

onninclusiva di “motore di ricerca”, mentre si tratta di strumenti

completamente diversi. Esse sono archivi di dati ordinati in

maniera gerarchica, secondo un sistema di cartelle e

sottocartelle, divise per argomento. Già da queste poche righe si

può intuire come questi due approcci viaggino per strade diverse

e portino ad altrettanto differenti risultati.

6 Lett., http://it.wikipedia.org/wiki/Motori_di_ricerca 7 Fonte: www.seoguida.com/motori-ricerca

11

Obiettivi della tesi

Tale digressione ci aiuta a focalizzare l’oggetto di questa tesi.

Abbiamo fin qui tratteggiato due modi per razionalizzare

l’informazione sul Web, entrambi efficaci pur partendo da

presupposti agli antipodi. Il primo approccio si propone, in

seguito a una query8 da parte dell’utente, di filtrare l’enorme

quantità di risorse disponibili e ordinarle in base a criteri

variabili di rilevanza. Tale attività viene effettuata agendo

sull’engine, sulla macchina, grazie a dei programmi, detti

algoritmi, che reperiscono i dati, selezionano quelli rispondenti

ai criteri della richiesta, presentano infine il materiale sotto

forma di liste ordinate; il secondo è un approccio umano,

editoriale, che organizza i contenuti con un sistema gerarchico

di natura semantica. Senza trascurare le funzionalità e

potenzialità generate dalle directories, noi ci concentreremo

sull’analisi degli elementi che regolano l’operatività dei motori

di ricerca, al fine di comprendere come avviene dal punto di

vista tecnico il posizionamento9 dei siti. Vale comunque la pena

di sottolineare che le due metodologie si intersecano in più punti

e non potranno dunque essere trattate in maniera completamente

indipendente l’una dall’altra.

Nella prima parte di questo lavoro, dopo una necessaria

introduzione storico/contestuale, che ci porterà ad inquadrare lo

scenario attuale, ci occuperemo di esplorare l’interfaccia di un

motore di ricerca. Vedremo ciò che accade a livello

macroscopico e come vi si relaziona l’utente.

Nella seconda parte comprenderemo, attraverso uno studio sulle

principali tecniche di retrieval, come sono nati i primi motori di

ricerca, quali sono i loro principi di funzionamento, quali

8 Il termine query, in informatica viene utilizzato per indicare l'interrogazione di un database in modo da ottenere dei dati contenuti in uno o più database. In senso lato, designa una richiesta di informazioni da parte di un attore umano a un sistema automatico. 9 Per posizionamento s’intende l’attività di migliorare o stabilizzare la posizione di un sito all’interno delle graduatorie dei motori di ricerca in base a un determinato criterio di ricerca .

12

strategie vengono messe in atto per il reperimento e la

classificazione dell’informazione.

Nel terzo capitolo studieremo l’applicazione delle strategie di

retrieval ai motori di ricerca: vedremo come il loro impiego sia

stato complicato dalla continua crescita del Web e

conseguentemente integrato da altri metodi di classificazione.

Seguiremo i cambiamenti del paradigma della ricerca sul Web

fino ai nostri giorni, illustrando l’evoluzione tecnologica dei

motori di ricerca nell’ultimo decennio, guidata

dall’affermazione quasi monopolistica di Google.

L’analisi ad ampio raggio, effettuata in questi capitoli sul mondo

dei motori di ricerca, ci consentirà certamente di acquisire

maggiore dimestichezza e familiarità con uno strumento entrato

nell’uso comune della nostra vita quotidiana, ma del quale molto

spesso non siamo in grado di sfruttare pienamente le

potenzialità. Nel far questo, percorreremo le tappe significative

del sentiero evolutivo dei motori di ricerca, apprezzandone le

innovazioni metodologiche e tecnologiche più interessanti,

arrivando a tracciare gli scenari che si prospettano nel futuro

immediato. Giungeremo infine all’ultimo capitolo, nel quale gli

argomenti trattati troveranno il loro naturale ambito di

applicazione in un settore di grande attualità: osserveremo che la

conoscenza dei criteri di classificazione dei documenti sui

motori di ricerca è uno strumento fondamentale per chi cerca

visibilità sul Web. Il SEO è l’ambito ove si concentrano tali

conoscenze: cercheremo di esporne le linee guida mediando tra

le esigenze, non sempre facilmente conciliabili, di un

posizionamento efficace e di un orientamento collaborativo allo

sviluppo semantico Web.

13

14

CAPITOLO I

1.1 Prima di Google

A un occhio profano, i motori di ricerca si configurano

semplicemente come strumenti che permettono di ricercare

materiale su Internet, attraverso la digitazione di una stringa di

testo da parte dell’utente, in risposta alla quale essi restituiscono

una serie di risultati, messi in ordine in base a complicatissimi e

poco conosciuti criteri di catalogazione.

Ma tali criteri sono davvero così indecifrabili e difficili da

interpretare? Senza eccessivi sforzi di memoria, possiamo

ripercorrere la prima fase della storia dei motori di ricerca,

significativamente denominata “prima di Google”, proprio per

sottolineare quanto le novità giunte da Mountain View abbiano

rivoluzionato lo scenario precedente.

I primi motori di ricerca, sorti nella prima metà degli anni

Novanta, utilizzavano il semplice criterio delle keywords (parole

chiave), inserite dagli stessi webmaster all'interno delle loro

pagine, attraverso i meta tag10. Tale sistema permetteva di

collegare le parole ricercate a pagine Web, i cui meta tag

segnalavano la presenza dei contenuti richiesti. Infine, veniva

stilata dal motore una lista di riferimenti ordinati secondo

pertinenza e rilevanza. La rilevanza, spesso rappresentata anche

con una percentuale posta accanto all'indirizzo di ciascun sito

Web trovato, nei motori di prima generazione veniva

determinata da una serie di algoritmi che prendeva in

considerazione un insieme di fattori, tra cui:

10 I meta tag, il cui funzionamento verrà approfondito in seguito, sono informazioni sui dati di una pagina web; sono inseriti nel codice HTML della pagina stessa, per fornire informazioni ai motori di ricerca.A differenza di ogni altro tag inseribile in una pagina web, i meta tag non forniscono al browser alcun dato di formattazione della pagina, per cui il loro influsso sul layout finale è nullo; sono perciò totalmente invisibili all'utente se non attraverso la visualizzazione del codice sorgente in HTML (http://it.wikipedia.org/wiki/Meta_tag)

15

- occorrenze del termine di ricerca nella pagina (frequenza);

- rapporto tra occorrenze e totale di parole della pagina

(densità);

- vicinanza dei termini di ricerca (prossimità);

- frequenza di aggiornamento delle pagine;

- posizione dei termini in alcune parti della pagina Web

(metatag del campo "head", nel campo "title" o, all'interno del

"body", nei tag "H" e "href", ecc.)

Erano i tempi di Altavista, Infoseek, ed Excite.

Per poter apparire ai primi posti nella lista di risultati, si

diffondeva l'uso dello spam11: termini con lo stesso colore dello

sfondo in modo da non essere visualizzati nel browser ma

percepiti dallo spider, utilizzo di pagine di reindirizzamento,

utilizzo improprio di parole chiave, segnalazioni continue della

stessa pagina al motore.

Un approccio apparentemente funzionale veniva così smontato

da programmatori smaliziati, che cominciarono, con l’obiettivo

di rendere più visibili e visitate le loro pagine Web, a dichiarare

nelle stesse decine di parole chiave, rendendo di fatto nulla

l'utilità di questo strumento (prevista, peraltro, nelle stesse

specifiche di HTML). Contemporaneamente, i motori di ricerca

più in voga (in particolar modo Altavista) iniziarono a vendere

le posizioni alte dei loro risultati di ricerca, mischiando, nella

presentazione dei risultati, siti rispondenti ai criteri di ricerca

con clienti rispondenti a criteri commerciali.

Questa situazione non molto rosea preparò il terreno per

l'avvento di Google.

11 Il termine spam, entrato ormai nel linguaggio comune, include qualsiasi forma di pubblicità indesiderata che si riceva su Internet. Per estensione, il termine può indicare anche l’attività di sabotaggio o manipolazione degli strumenti della Rete (siti, motori di ricerca, e-mail, ecc…) per scopi impropri.

16

1.2 I motori di seconda generazione

Occorre innanzitutto fare una panoramica sui leader del settore:

verso la fine degli anni Novanta molti siti hanno ritenuto

opportuno dotarsi di motori di ricerca interni, per facilitare il

reperimento di informazioni all’interno del sito stesso. Ma non

sono questi i motori di ricerca che ci interessano: noi vogliamo

occuparci dei motori veri e propri, URL alle quali si approda

appositamente per ricercare contenuti all’interno dell’intero

Web. Questi ultimi sono più interessanti per la nostra ricerca

non tanto per il principio di funzionamento (che è lo stesso di

quelli piccoli e che analizzeremo in seguito), quanto per la loro

particolare struttura e per l’enorme capacità di elaborazione di

cui sono in possesso, che li rende imprescindibili nello scenario

attuale di Internet: pensiamo a come il concetto stesso di

ipertesto sarebbe limitato, senza uno strumento che ci collega ai

contenuti mediante un’espressione, una stringa di testo. Inoltre, i

motori ci aiutano a introdurre la questione della visibilità in

Rete, che sta alla base del SEO e che è il vero propulsore del

nuovo, straordinario, sviluppo della Rete stessa dal punto di

vista commerciale.

1.2.1 L’avvento di Google

Sviluppato da due giovani ricercatori dell'universita' di Stanford,

Sergey Brin e Larry Page, Google e' stato lanciato in rete nel

settembre del 1999. Da allora, ha avuto una crescita

esponenziale, diventando in tempi rapidi il primo motore di

ricerca al mondo.

I dati ormai parlano chiaro: primo motore di ricerca utilizzato in

assoluto, 40% del mercato (che diventa 50/55% considerando i

17

motori che utilizzano le sue tecnologie), 300 milioni di utenti,

fatturato di 3 miliardi di dollari12.

Come ricordato precedentemente, la prerogativa che ha premiato

Google, innalzandolo in pochi anni a leader mondiale, consiste

nela sua rivoluzionaria idea di inserire negli algoritmi di ricerca

i link come variabile di calcolo della rilevanza. In realtà vari

fattori concorrono con differenti percentuali all’algoritmo, ma il

valore aggiunto consiste nel considerare i collegamenti tra siti,

chiaramente testuali, come elementi matematici. Questa, la

motivazione più tecnica. Naturalmente i fattori che hanno

concorso al successo di Google sono molteplici, a partire da una

progettazione user-friendly, per passare a un continuo

aggiornamento, in particolar modo per ciò che riguarda

l’algoritmo di ricerca e le parti che lo compongono. Infine, un

approccio commerciale, che ha portato ad esempio nel

Novembre 2006 alla discussa acquisizione del principale

concorrente per la condivisione di audiovisivi, YouTube.

Tornando al vero punto di svolta di Google, esso è

universalmente conosciuto col nome PageRank, altro gioco di

parole tra il cognome di uno degli autori e la prerogativa di

questo algoritmo di assegnare un valore (rank) ad ogni pagina

Web (page). L’algoritmo PageRank risulta tuttora uno tra gli

elementi più importanti per la classificazione delle pagine Web.

Sin dal momento della sua introduzione esso fece sentire il suo

peso, in particolare nella lotta allo spam, che ebbe da quel

momento maggiori difficoltà operative, essendo diventato a quel

punto inutile il suo annidamento nel codice sorgente di un sito. I

metatag videro da quel momento diminuire la loro importanza,

mentre ne acquistarono moltissima i link verso il sito, visto il

loro contributo di autorevolezza e rilevanza. Ma lasciamo che

Google descriva il concetto di Page Rank con “le sue stesse

parole”:

12 Fonte: http://www.primaonline.it/opinioni

18

“PageRank in dettaglio

Basato sullo specifico carattere "democratico" del

Web, PageRank sfrutta la vastissima rete di

collegamenti associati alle singole pagine per

determinarne il valore. In pratica, Google interpreta

un collegamento dalla pagina A alla pagina B come

un "voto" espresso dalla prima in merito alla

seconda. Tuttavia, non si limita a calcolare il

numero di voti, o collegamenti, assegnati a una

pagina. Oltre a effettuare questo calcolo, Google

prende in esame la pagina che ha assegnato il voto.

I voti espressi da pagine "importanti" hanno più

rilevanza e quindi contribuiscono a rendere

"importanti" anche le pagine collegate.

PageRank assegna ai siti Web importanti e di alta

qualità un "voto" più elevato di cui Google tiene

conto ogni volta che esegue una ricerca. È evidente

che oltre ad essere importanti, le pagine devono

corrispondere ai termini ricercati. Quindi, Google

integra PageRank con sofisticate procedure di

ricerca testo per trovare le pagine che sono rilevanti

e rispondono ai criteri di ricerca indicati.”13

E’ una storia breve quella dei motori di ricerca, ma la velocità e

l’entità dei cambiamenti tra queste due prime generazioni, il

passaggio dal posizionamento per keyword al PageRank,

passando per l’affinamento delle directories, rendono abissale la

distanza. Ora, prima di focalizzare il nostro discorso su Google,

13Guida alle funzioni di ricerca di Google, http://www.google.it/intl/it/why_use.html, 2008.

19

vediamo chi erano i competitors al momento del suo ingresso in

scena e nell’immediato seguito.

1.2.2 Yahoo e le directories

Yahoo è sempre stato il principale e naturale antagonista di

Google, sia in quanto preesistente, sia perché ha sposato un

approccio alla ricerca dell’informazione completamente diverso.

Yahoo nasce nel 1994, come poi avverà anche per Google, da un

progetto universitario dei suoi fondatori, David Filo e Jerry

Yang, che stavano sviluppando un deposito di link per tenere

traccia dei loro interessi su Internet. Quando tale deposito si

rivelò troppo grande e poco gestibile, i due decisero di

suddividerlo in categorie e sottocategorie, per argomenti. Il

progetto fu battezzato Jerry’s Guide to the World Wide Web, ma

dopo breve tempo acquisì il nome definitivo Yahoo (Yet Another

Hierarchical Officious Oracle) e cominciò a ricevere milioni di

visite giornaliere. Divenuto rapidamente azienda di successo,

Yahoo ha mantenuto la sua struttura a directory, servendosi di

società esterne per il servizio di ricerca (nell'ultimo periodo,

prima della trasformazione del 2004, la ricerca su Web veniva

rendirizzata su Google).

Superata la crisi delle dotcom dopo il 200014, Yahoo ha

compreso l’importanza di sviluppare un motore di ricerca

proprietario, che è stato elaborato e lanciato negli anni

14 Nel marzo 2000 una grossa crisi investì il mercato della cosiddetta “New economy”, costituita dalle attività, le imprese e gli investimenti basati sulle nuove tecnologie informatiche e telematiche gestibili su Internet. I motivi sono da ricercarsi nella nevrotica circolazione di enormi somme di denaro proveniente da venture capital e diretto alle imprese start-up, sulle quali il mercato azionario ha perso il controllo portando il sistema a un punto di collasso. Colossali cifre di denaro e numerosissime aziende sono state spazzate via da questa congiuntura, senza tuttavia provocare grosse inversioni di tendenza nel settore.

20

successivi, anche grazie ad alcune importanti acquisizioni15 e

che ha permesso al gruppo di diventare oggi la seconda fonte

utilizzata per effettuare ricerche sul Web. Ciò che ci interessa

particolarmente è la filosofia che Yahoo rappresenta, quella

ovvero di una selezione dei risultati filtrata dalla valutazione

umana piuttosto che gestita in maniera automatizzata.

Questo implica, per le directories come Yahoo, affidare le

proprie graduatorie a una catalogazione gerarchica

dell’informazione, spesso coadiuvata dall’intervento editoriale

umano, contrapposto all’oggetività “cieca” del calcolo

computazionale. L’indubbio vantaggio di una maggiore

selettività dell’informazione e di una struttura ad albero che

impone rigore e razionalità al caos del World Wide Web, viene

tuttavia limitato da un dominio di risultati circoscritto alla sola

struttura classificatoria.

Vedremo in seguito come la terza generazione dei motori,

insieme all’evoluzione dei linguaggi di programmazione al

servizio del Web, tenteranno una conciliazione tra i punti di

forza delle due tendenze nel Web semantico e negli studi sugli

agenti intelligenti.

1.2.3 Gli altri

Nel recente passato, tra i concorrenti di successo di Google si è

imposto anche Msn. Si tratta del tentativo Microsoft di porre

freno al dominio incontrastato di Google. Nel passato il colosso

informatico utilizzava tecnologie fornite da aziende esterne,

privilegiando la struttura a directory come Yahoo; ha poi

15 Le acquisizioni in questione sono Inktomi e Overture. Inktomi era azienda leader per la fornitura di servizi di ricerca su Web prima del 2000; Overture invece era una società proprietaria di un sistema di gestione dell’online advertising .

21

ammesso di aver perso una grande opportunità non sviluppando,

a suo tempo, una tecnologia di ricerca proprietaria.

Nel novembre del 2004, dopo 18 mesi di lavori, viene rilasciata

la versione beta16 del nuovo motore sviluppato dagli ingegneri

microsoft, MSN search, basato su un algoritmo totalmente

nuovo. Al momento MSN dichiara di aver indicizzato nel suo

database 5 miliardi di pagine Web, contro gli oltre 8 miliardi

dichiarati da Google..

Il pregio di MSN Search e' quello di superare l'approccio

generalista adottato da altri motori di ricerca, attraverso alcuni

strumenti di personalizzazione.

La sezione "settings" o "opzioni" permette di personalizzare i

risultati di ricerca secondo diversi parametri potendo scegliere di

visualizzare solo i siti in una determinata lingua, di far

visualizzare più di 10 risultati per pagina, raggrupparli per sito, e

filtrare i risultati.

La ricerca avanzata consente inoltre di limitare i risultati ad un

particolare dominio, lingua o paese e dispone di un particolare

filtro chiamato "ranking" o "valutazione risultati".

Ad oggi, Google, Yahoo e Msn sono le risorse più utilizzate per

reperire informazioni in Rete. Tuttavia la scena è costellata di

comprimari, che pur offrendo servizi del tutto simili a quelli

finora descritti, si differenziano ciascuno per qualche particolare

funzionalità. Passiamo in rassegna i più interessanti:

- dmoz: è l’acronimo di directory Mozilla, nasce nel 1998 con il

nome di NewHoo (ci ricorda qualcosa?), ma è conosciuto anche

come ODP (Open Directory Project).

L’idea si deve a un gruppo di volontari, con l'obiettivo di creare

una directory ragionata di risorse internet, gestite da specialisti 16 La versione beta è una versione di prova di un software, già testato dagli esperti, che viene messo a disposizione del pubblico, nell’ottica di individuare eventuali nuovi bug o incompatibilità del software stesso.

22

nelle singole aree. La forza di tale metodologia è di tipo

qualitativo e collaborativo: i volontari (detti editori), cresciuti

esponenzialmente in numero, esplorano continuamente la Rete

e, rispettando i criteri di editing ODP, ordinano e catalogano i

contenuti.

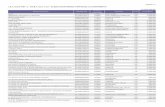

ODP è attualmente la directory utilizzata da siti come AltaVista,

Google, Lycos, Teoma e molti altri, come possiamo osservare

nella figura 1, ove le freccie verdi puntano verso i motori che si

servono di dmoz come catalogo.

Figura 1 Diffusione dell’utilizzo della directory dmoz presso i motori di ricerca.

Chiunque sia interessato a collaborare, partecipando attivamente

alla costruzione della directory, può scegliere un argomento e

fare richiesta di diventare editore per quella categoria. Oggi il

catalogo ospita addirittura 600.000 categorie e, per quanto sia

stato acquistato da Netscape (poi assorbita da AOL), ha

mantenuto fede al suo nome, conservando accesso gratuito, una

struttura editoriale decentrata, e la filosofia open source

all’origine del suo successo.

23

-Teoma e' stato sviluppato dal 1998 alla Rutgers University e

riprende la tecnologia su cui si basa il relevance ranking di

Google, cercando di perfezionarla. Come tutti i motori, una

volta inserite le parole chiave, Teoma cerca nel Web i siti che le

contengono. Ma, una volta individuati i siti, applicherà solo a un

gruppo, definito community, l'analisi dei link. Questo poiché

tale comunità, composta da siti di argomento attinente a quello

cercato, genera risultati più rilevanti e affidabili di quelli di altri

sistemi che applicano l'analisi dei link a tutto il Web (tale

concetto viene denominato Subject-Specific Popularity). In altre

parole, la posizione in graduatoria viene determinata dalla

quantità e dall’importanza dei link provenienti dalla stessa area

contestuale. Possiamo descrivere questo come il tentativo pilota

di mischiare le potenzialità di un motore con quelle di una

directory. Vedremo nel terzo capitolo, allorché ci occuperemo

dello sviluppo di Google, come l’intuizione dell’importanza

dell’area tematica venga integrata negli algoritmi di topic

distillation.

Nel 2001 Teoma viene acquisita da Ask Jeeves, poi divenuta

Ask.com, alla quale vengono trasferiti gli algoritmi di ricerca.

La peculiarità di Ask consisteva nel permettere ai suoi utenti di

ottenere delle risposte, interrogando il database con domande in

linguaggio naturale. Col tempo, e in seguito all’acquisizione di

Teoma, si è poi standardizzato ai motori di ricerca tradizionali,

e oggi presenta un’interfaccia del tutto simile a quella di Google.

- In continuità logica col precedente, Answers, nato nel 2005,

non è un vero e proprio motore di ricerca; si tratta piuttosto di un

motore enciclopedico. Digitando i termini di ricerca, Answers

non restituisce collegamenti ipertestuali (“Not lists of links... just

the information you're looking for”, è lo slogan), bensì vere e

proprie risposte, ottenute cercando e recuperando definizioni da

database enciclopedici. Attinge infatti a un centinaio di fonti:

24

enciclopedie, database, biblioteche, dizionari, atlanti. Tra questi,

siti affidabili e aggiornati come Columbia University Press,

Wikipedia, Houghton-Mifflin ecc.

Answers fornisce anche Click Answer, un software scaricabile

gratuitamente, che permette di collegare ogni termine

visualizzato sullo schermo alla definizione o ad altre

informazioni. Ancor più notevole, Wiki-Answer, una

funzionalità basata sulla filosofia wiki di knowledge sharing17,

attraverso cui qualunque utente abbia accesso alle risorse, può

aggiungerne di nuove o integrare le vecchie con nuove

informazioni.

Le caratteristiche di Answers fanno guardare a un futuro del

settore in cui la presenza umana, già presente a vari livelli nelle

strategie di indicizzazione attuali, si farà sempre più pressante e

necessaria, integrando le componenti automatiche dei motori di

ricerca e sopperendo ove queste siano troppo rigide, per venire

incontro alle molteplici necessità di informazione “intelligente”

da parte dell’utente.

1.3 I metamotori

Discorso a parte meritano i metamotori, il cui sviluppo è

trasversale rispetto agli elementi trattati finora. I metamotori

sono portali che non hanno un proprio database e aggregano i

risultati dei motori di ricerca principali, servendosi degli archivi

di questi ultimi. Nei primi sviluppi di Internet, quando le banche

dati dei motori erano piuttosto limitate, i metamotori furono

accolti con molto entusiasmo. Come prima impressione

17 Tale filosofia sta alla base ad esempio della nota enciclopedia libera online, Wikipedia (http://www.wikipedia.org). Il successo del knowledge sharing (condivisione della conoscenza) è determinato dalla partecipazione attiva da parte degli utenti, ai quali viene data la possibilità d’inserimento di nuove voci (sottoposte naturalmente a un monitoraggio editoriale).

25

sembravano strumenti ottimali, nell’ottica di snellire il processo

di reperimento ("perché cercare prima con un motore poi con un

altro, quando si può effettuare la ricerca contemporaneamente su

tutti?"). In realtà la loro efficacia è molto discutibile. Il

principale difetto è l'effetto di "minimo comun denominatore",

ovvero il fatto che possono usare solo le funzioni che i motori da

loro interrogati hanno in comune, finendo quindi per utilizzare

solo la parte più elementare di ciascun motore.

Tuttavia in questo filone rientrano un paio di progetti, di buon

successo per quanto riguarda il bacino d’utenza e di enorme

portata per il futuro dei motori di ricerca. Ci riferiamo alle

iniziative nate alla Carnegie Mellon University, che hanno dato

alla luce prima Vivìsimo, quindi Clusty.

1.4 Il clustering

Fondato nel 2000 da alcuni ricercatori della sopra menzionata

università di Pittsburgh, Vivìsimo si autodefinisce “clustering

engine”.

Questo perché, alla base del suo funzionamento, c’è il principio

che racchiude tentativi, esperimenti e speranze di poter

sviluppare dei motori di ricerca intelligenti. Tale principio

prende il nome di clustering, e come suggerisce il nome,

consiste nel processo di raggruppamento delle pagine e dei

documenti trovati nel Web secondo categorie (clusters)

semantiche.

Secondo questa modalità di presentazione dei risultati, viene

visualizzato non solo l’elenco delle pagine Web più significative

in base alla query inserita dall’utente, ma anche una serie di

cartelle tematiche, che rappresentano vari filoni attinenti

all’oggetto della ricerca, e che permettono all’ utente di

26

restringere o approfondire la ricerca in base a parametri

consigliati dal sistema.

Vivìsimo, “motore per il raggruppamento dei documenti” è il

pioniere del clustering, nonchè strumento che aggrega le risorse

della Rete su un determinato argomento, rendendole fruibili

attraverso cartelle tematiche create in tempo reale.

Esempio. Desideriamo ottenere informazioni sul tema “motori

di ricerca”. Inseriamo la query nella maschera, e otteniamo dei

risultati divisi in due sezioni. La prima, che occupa la parte

centrale della videata, propone in ordine di importanza alcune

pagine Web scelte che trattano dell’argomento inserito. La

seconda sezione dei risultati è posta sulla sinistra e propone una

serie di cartelle, in cui i risultati della ricerca sono ordinati in

base ad argomenti e sotto-argomenti. Grazie a questa sezione

possiamo decidere quale sotto-argomento visitare: là troveremo

altre pagine Web selezionate da Vivísimo e sempre relative ai

motori di ricerca.

Sviluppato da Vivìsimo e lanciato nel 2004, merita una

menzione anche Clusty, metamotore il cui nome sottolinea

ancora una volta la funzione di raggruppamento dei risultati di

ricerca.

Clusty si comporta come un normale metamotore, indicizzando

nella parte centrale della pagina i risultati fornitigli dai database

che a sua volta interroga, ma in più, come osserviamo sulla parte

sinistra della schermata, clusterizza tali risultati in base

all’argomento, proponendo alcune categorie di prossimità

concettuale alla query (fig.2): nel nostro caso, per la keyword

“motori di ricerca”, Clusty seleziona i clusters

“posizionamento”, “search engine”, “campagne, servizi”,

“realizzazione siti”, e molti altri.

27

Figure 2-4 Diverse opzioni di raggruppamento dei risultati offerte da Clusty

E’ intuitivo capire come tale strumento possa rivelarsi

fondamentale, nel caso in cui l’utente non abbia ben chiaro il

focus della propria ricerca, o lo voglia ulteriormente specificare.

Inoltre, come osserviamo nelle figure 3 e 4, possiamo scegliere

altre opzioni di raggruppamento dei risultati, che vengono

aggregati rispettivamente per fonti (altri motori di ricerca,

directories, articoli), o per dominio (nazionali, commerciali,

governativi, ecc…).

28

Avveneristico nel suo genere è infine l’esempio di Kartoo.com,

un metamotore costruito con intelligenza e creatività (e l’aiuto

dell’editor Flash), che si avvale delle tecniche di clustering per

offrire i suoi risultati sotto forma di mappe dinamiche. Cosa

significa?

Osserviamo la figura 5:

Figura 5 La risposta di Kart00 a una query

In seguito a un nostro input (il solito “motori di ricerca”),

Kartoo costruisce, oltre all’elenco di risultati raggruppati per

argomento (a sinistra), un’animazione Flash con una mappa di

documenti, che rappresentano i siti, di diversa grandezza a

seconda dell’importanza. Tali documenti sono sensibili al

passaggio del mouse, in corrispondenza del quale mostrano

quali link li legano agli altri items sulla mappa;

contemporaneamente sulla sinistra della pagina scompaiono i

clusters, per lasciare spazio ad un’anteprima della pagina Web

che andremmo a visualizzare cliccando.

29

Questi esempi di clustering ci portano a fare due considerazioni

di fondamentale importanza sull’argomento.

La prima è che tale logica di aggregazione dei risultati

rappresenta l’esempio meglio riuscito della convergenza tra

motori in senso stretto e directories, sfruttando la velocità e

l’ampio raggio d’azione dei primi, e la struttura razionale e

semantica dei secondi.

La seconda riflessione riguarda le conseguenze del clustering

stesso: esso mette in luce un nuovo approccio dei motori di

ricerca, focalizzato su una selezione dell’informazione per

concetti e categorie, avvicinandosi all’ottica semantica; tale

svolta, unita alla possibilità di una maggiore personalizzazione

dei contenuti proposti all’utente, raggiungibile grazie

all’aumento dell’interattività e alla conseguente creazione di

profili d’utenza, apre il dibattito al tema dell’intelligenza

artificiale applicata ai motori di ricerca.

1.5 Scenari futuri

Giunti a questo punto, abbiamo osservato come la ricerca di

informazione sui motori, vista molto spesso dal lato utente come

un’operazione di banale semplicità, consistente nella digitazione

di alcuni caratteri in una maschera, è in realtà il frutto di una

complessa progettazione e offre importanti spunti di riflessione:

in primo luogo per quanto concerne le diverse modalità di

raggiungimento dell’obiettivo (il reperimento

dell’informazione), che è ciò di cui ci siamo occupati finora; ma

pensiamo soprattutto alle conseguenze che tali modalità hanno

sul prossimo sviluppo del Web.

30

Lo scenario che si profila pare muoversi nella direzione di un

mix nell’utilizzo delle tecniche finora analizzate, volto a

sfruttarne le prerogative di successo ed eliminarne i punti deboli.

Nello specifico, l’elevata automazione degli algoritmi dei motori

di ricerca permette rapidità e reiterazione di indicizzazione

irraggiungibili, ma pecca di scarsa elasticità; le directories hanno

una struttura ordinata, e permettono una progressiva scrematura

del rumore (ossia, l’informazione inutile), inoltre, come nel caso

di dmoz, permettono quella classificazione qualitativa dei

risultati che al momento soltanto l’essere umano è in grado di

fornire; tuttavia, la loro grossa lacuna strutturale consiste nei

tempi di censimento del Web estremamente lenti, fattore che

impedisce di tenere il passo con l’espansione del Web stesso,

nonostante i sempre maggiori sforzi di collaboratori e volontari.

Il clustering, dal canto suo, pur proponendo una buona

mediazione tra le due possibilità sopra elencate, non sempre

offre un grado di rilevanza accettabile rispetto all’informazione

cercata, inoltre non sempre i clusters sono gli strumenti più

adatti per approfondire la ricerca. Non è raro scoprire che alcune

delle pagine Web presentate siano in realtà irrilevanti, se non

addirittura fuorvianti. Della precarietà dei metamotori come

strumento di precisione nella ricerca abbiamo già parlato poco

fa.

Ma allora, come combinare le virtù dei vari fronti, nell’ottica di

un Web nel quale, secondo una celebre frase di Daniel Read del

team Ask Jeeves, "gli utenti si aspettano che il motore di ricerca

legga nella loro mente"18? Come integrare “contenuti

multimediali e descrizioni semantiche, così da permetterne una

classificazione ed un’indicizzazione accurata e compatibile con

le tecnologie d’elaborazione automatica”19, come preconizza il

padre del Web, Tim Berners-Lee? Come rendere, in breve, i

motori di ricerca uno strumento intelligente, che assecondi le

18 Mirella Herrmann, Strumenti di ricerca in Internet, KF e-learning, maggio 2005 19 John Battelle, The Search, Cortina, 2007.

31

reali richieste dell’utente, che impari dai suoi comportamenti,

che preveda le sue scelte?

La risposta a tali interrogativi è ancora lungi dall’essere stata

fornita, ma dobbiamo annotare negli ultimi anni dei tentativi

mossi in tale direzione:

- Web semantico

Il Web è una massa di informazioni eterogenee e catalogate in

tanti modi diversi. Il Web semantico si propone di dare una

struttura al caos di risorse presenti in rete per facilitarne il

reperimento. Lo strumento utilizzato a questo scopo si chiama

XML, acronimo di Extensible Markup Language. Si tratta di un

metalinguaggio che consente di fornire una struttura ai

documenti e di inserire informazioni sui propri contenuti. L’xml

viene utilizzato per creare una rete di metadati, che descrivono

gli elementi del documento dal punto di vista semantico, dando

cioè informazioni qualitative. Di conseguenza, quando un

motore scandaglia una pagina Web, in presenza di tags xml esso

riesce a “comprendere” ciò che legge.

Se noi leggiamo "Paola Rossi" percepiamo che la stringa di

parole si riferisce al nome di una persona di sesso femminile e

probabilmente di nazionalità italiana: obiettivo del Web

semantico è di rendere accessibili anche ad una macchina questo

tipo di informazioni.

Queste informazioni sono quindi inserite preventivamente, al

momento della creazione delle pagine, secondo precise regole

semantiche, e vanno a far parte della struttura del documento.

- Machine Learning

Questo concetto, conosciuto in italiano come apprendimento

automatico, costituisce uno dei fronti principali della ricerca

sull’intelligenza artificiale. Esso consiste nell’idea che i sistemi

32

informatici, di cui i motori di ricerca fanno naturalmente parte,

possano essere “addestrati” ad apprendere, dunque essere in

grado di migliorare le proprie performances basandosi su

risultati precedenti. La grande portata teorica dell’argomento lo

rende un punto focale per molte applicazioni della Computer

Science - tanto per rendere l’idea, ne elenchiamo alcune:

processamento dei linguaggi naturali, riconoscimento di modelli

sintattici, diagnosi mediche, bioinformatica e informatica

chimica, prevenzione di frodi informatiche, analisi del mercato

azionario, classificazione di sequenze di DNA, riconoscimento

vocale e grafico, riconoscimento visuale, giochi e robotica.

E’ chiaro che l’ambito che ci interessa più da vicino è quello dei

motori di ricerca: come viene istruita la macchina? Esistono

degli algoritmi che le permettano di elaborare i nostri

comportamenti e imparare da essi, in modo da formare dei

“profili utente” da poter utilizzare nelle ricerche successive?

La risposta è naturalmente si. Molti motori di ricerca hanno

sviluppato una serie di opzioni per personalizzare la ricerca,

attraverso “agenti intelligenti”, che identificano il profilo

dell'utente sulla base dell'analisi delle preferenze e degli

interessi espressi durante le precedenti navigazioni: i risultati

delle ricerche successive si adegueranno al profilo costruito.

Quelli che abbiamo appena definito agenti intelligenti, sono in

realtà gli stessi algoritmi che rendono possibile il data mining.

Tale processo consiste nell’estrazione di conoscenza, sotto

forma di informazioni strutturate e tra loro collegate, estrazione

che avviene metaforicamente “picconando” banche dati di

grandi dimensioni. Lo scopo è quello di rendere disponibili

schemi o relazioni tra dati che esistono già, ma rimarrebbero

invisibili, o comunque nascoste.

Ora, il data mining è applicato a grossi database. Ma esistono

strumenti che applicano tali tecniche di estrazione cognitiva ai

testi in linguaggio naturale. Entriamo nell’ambito del text

33

mining, procedimento volto a catturare l’informazione testuale

implicita contenuta in un’insieme di documenti.

Si intuisce immediatamente l’importanza di tali attività, che

possiamo sintetizzare sotto il nome di Web mining, nell’ambito

delle ricerche in Internet: infatti, è proprio monitorando e

analizzando le banche dati così createsi, che è possibile

determinare dei pattern. Tali schemi ci conducono, da un lato, a

prevedere, guidare e assecondare con sempre maggior

precisione le scelte dell’utente. Non a caso si parla di

collaborative e cognitive filtering20: l'assunzione fondamentale

dietro a questi concetti è che ogni singolo utente che ha mostrato

un certo insieme di preferenze continuerà a mostrarle in futuro.

Ne consegue la creazione di profili utente, effettuata dal sistema

a partire da modelli di comportamento collettivi, in un continuo

processo di affinamento, attraverso il quale l’utente riceve

contenuti e informazioni specifiche.

Dall’altro lato, il Web mining permette di estrapolare da un

database sconfinato come quello del Web, dei documenti legati

da un filo di coerenza, da associazioni testuali, da analogie

linguistiche o tematiche, è insomma in grado di creare relazioni

scandagliando un universo di dati inestricabili. Come ad

esempio proporre all’utente siti con caratteristiche simili, ma

invece che slegati l’uno dall’altro, aggregati in raggruppamenti

logici. A ben pensarci, è proprio ciò che accade nel clustering.

Nei capitoli successivi, ove il funzionamento dei motori di

ricerca diverrà via via più chiaro, vedremo quali sono i risultati

raggiunti dal settore del machine learning nell’ambito della

ricerca su Internet. Quelli finora analizzati rappresentano gli

20 Per collaborative filtering (filtraggio collaborativo, spesso abbreviato con le lettere "CF") si intende una classe di strumenti e meccanismi che consentono il recupero di informazioni relative agli interessi di un insieme dato di utenti a partire da una massa ampia e tuttavia indifferenziata di conoscenza, offrendo la possibilità di effettuare inferenze predittive su tale insieme. Lo stesso meccanismo governa il cognitive filtering, filtraggio cognitivo, con la differenza che qui la selezione avviene analizzando i contenuti dei documenti.

34

approcci di maggiore successo e vengono largamente utilizzati

nei motori di ricerca.

1.6 Dentro Google: interfaccia utente

Ora che abbiamo evidenziato come i motori concorrano e

reagiscano al profilarsi di modelli di utenza, è giunto il momento

di introdurre come ciò avvenga a livello pratico. Quali sono

ovvero, le funzionalità, le possibilità di personalizzazione, le

modalità di presentazione dei risultati, le opportunità di aiuto e

interattività e più in generale gli elementi che ci troviamo di

fronte quando effettuiamo una ricerca sul Web.

Questo ci permetterà di familiarizzare con alcuni concetti (molti

sono, come spesso capita sigle) che incontreremo molto spesso

trattando di search engine optimization.

Si è scelto come esempio Google in quanto motore di ricerca più

diffuso in assoluto, che ci permette pertanto di generalizzare

maggiormente le considerazioni che facciamo in questa sede.

Ci connettiamo all’URL www.google.com, e veniamo

automaticamente reindirizzati, grazie a uno script in php, alla

pagina contestuale della nostra lingua. Ecco un primo esempio

di personalizzazione della ricerca: Google invia la sua

homepage in base alla lingua predefinita del browser, dunque

noi atterreremo su www.google.it.

Giungiamo a questo punto sulla pagina iniziale di Google, che si

presenta così (figura 6):

35

Figura 6 La homepage di Google Italia

La prima cosa da sottolineare è la semplicità di questa

homepage, che vuole comunicare con immediatezza la funzione

primaria del sito: ricercare dati. Un logo, una maschera per

inserire stringhe alfanumeriche, due opzioni di ricerca (locale o

globale) di carattere linguistico, cinque variabili di dati, per

restringere il campo di ricerca. La grafica molto spartana,

l’assenza di elementi con un ricercato appeal, risuonano come

un messaggio: “Qui ci interessa che l’utente trovi quello che sta

cercando. Punto”. Per molti addetti ai lavori questa filosofia

pratica, insieme alla qualità, alla velocità e all’estensione

dell’indice di Google, stanno alla base del suo successo.

Ovviamente sarebbe tutto troppo banale: questa apparente

semplicità, che permette l’utilizzo dello strumento a qualunque

persona, ha alla base un’architettura complessa e a più livelli,

ma è importante che l’interfaccia sia user-friendly.

Digitando una chiave di ricerca nella maschera, siamo di fronte

a due possibilità: i bottoni “cerca con Google” e “mi sento

fortunato”. Scegliendo la prima opzione, veniamo indirizzati alla

36

pagina di presentazione dei risultati, disposti in ordine di

rilevanza in base ai criteri del Page Rank, di cui analizzeremo le

variabili nel prossimo capitolo. Tale pagina prende il nome di

SERP, acronimo di Search Engine Result Page. Naturalmente,

nella maggior parte dei casi troveremo migliaia di siti

rispondenti alla nostra selezione, di conseguenza la SERP sarà

costituita da molte pagine che potremo scorrere fintanto che non

troveremo la risorsa a noi più congeniale.

La seconda opzione permette di saltare lo step della SERP, in

quanto rappresenta quella situazione in cui stiamo cercando

qualcosa di molto preciso, o estremamente noto, dunque siamo

certi che il motore lo troverà senza possibilità di equivoci o

risorse simili. Premiamo quindi “mi sento fortunato” e

atterriamo direttamente sul sito in cima alla graduatoria di

Google, quello che troveremmo in prima posizione nella SERP.

Tornando a quest’ultima, possiamo osservare nella figura 6 che

essa è suddivisa in due parti principali: al di sotto di un sintetico

resoconto sulla quantità delle risorse reperite e sul tempo

impiegato per effettuare l’operazione, sulla sinistra vengono

collocati i risultati naturali, ottenuti dal Motore esplorando il

Web e classificati per grado d’importanza. Sulla destra invece si

posizionano i risultati sponsorizzati, corrispondenti a una lista di

siti che hanno pagato il motore di ricerca, pur di ottenere quella

visibilità della prima pagina della SERP che non sono stati in

grado di raggiungere, o che vogliono potenziare con annunci

promozionali.

37

Figura 7 La pagina di risultati ottenuta su Google con la query “motori di ricerca”

A tal proposito, è interessante osservare che l’opzione “mi sento

fortunato”, oltre a rappresentare uno strumento utilizzato da una

parte minima dei suoi utenti (le statistiche rilevano l’1%)21,

inibisce per questi ultimi la possibilità di visualizzare gli

annunci pubblicitari che Google inserisce nelle pagine con gli

esiti della ricerca.

Eppure il doppio svantaggio, usabilistico ed economico, non

dissuade Google dall’intento di mantenere la funzionalità. Le

ragioni di questa scelta sono “ideologiche”, come ha spiegato

Sergej Brin, co-fondatore della compagnia californiana assieme

a Larry Page: “il fine è quello di aspirare a dare agli utenti a

colpo sicuro proprio ciò che cercano senza costringerli a

sceglierlo tra varie opportunità alternative.” In sostanza: Google

aspira a soddisfare al primo colpo la richiesta degli utilizzatori.

Si tratta ovviamente di un obiettivo utopico, dal momento che

21 Articolo “Il tasto Mi Sento Fortunato” , http://pixelgratis.com/articoli/web-marketing/il-tasto--mi-sento-fortunato.html, 2008.

38

spesso l’utente è anzi alla ricerca di più fonti da confrontare,

piuttosto che di un unico risultato.

Ma come precisa Marissa Mayer, la vice presidente di Google

per il settore search & user experience, “lo scopo di Google è

quello di unire intelligenze sulla base di propri interessi e

inclinazioni, e che l’ottenimento di profitti è solo una

conseguenza e non un fine di ogni operazione messa a segno”22.

Quest’affermazione è un punto cruciale della questione che

andiamo ad approfondire: da un lato Google, e più in generale i

motori di ricerca, puntano il loro futuro su un crescente

orientamento collaborativo, che li vede immersi nel Web 2.0 e

in interattività con la loro utenza. Il capitolo terzo illustrerà

come le tecnologie di ricerca alla base di Google siano parte

integrante di questo processo evolutivo.

Dall’altro lato, è inevitabile che uno strumento di così

fondamentale importanza nel contesto sociale attuale, attiri

investimenti e guadagni. Nell’ultimo capitolo analizzeremo i

risvolti di quest’aspetto sui fattori di cambiamento dei motori,

addentrandoci nella realtà del SEO e cercando di capirne il ruolo

in questo scenario.

22 Lett., J.Battelle, “Google e gli altri”, 2006.

39

CAPITOLO II

2.0 Dentro il motore

Finora la nostra analisi ci ha permesso di esaminare i motori di

ricerca da un punto di vista “superficiale”, mostrandoci come

essi si relazionano con l’utente. Ma questo non è sufficiente per

capire i meccanismi che stanno alla base del loro

funzionamento. A tal scopo, dobbiamo ora approfondire il punto

di vista tecnologico, attraverso una descrizione delle più

importanti caratteristiche dell’information retrieval, che ci

condurrà a una più agile comprensione di come l’informazione

venga immagazzinata, ricercata e messa a disposizione di chi la

richiede. L’obiettivo è quello di comprendere, attraverso un

excursus sugli approcci all'IR, l’evoluzione dei motori di ricerca

da semplici interfacce per il reperimento dell’informazione, alle

piattaforme di navigazione che sono diventate attualmente,

passando per gli algoritmi che le hanno svincolate dalla pura

ricerca testuale, legandole ad altre variabili come i link.

2.1 La ricerca

Che cos’è, in realtà, un motore di ricerca? Quali sono le sue

parti costituenti? Come reperisce e come gestisce le ingenti

masse di informazione che poi presenterà ai suoi utenti?

E’ rispondendo a tali interrogativi che faremo una conoscenza

più approfondita del nostro oggetto di analisi.

Tanto per cominciare, un motore di ricerca è un sistema che

mette in relazione le parole inserite da un utente (queries) ad un

database di pagine Web che ha creato(indice), generando

40

successivamente una lista di URL (con una sintesi del

contenuto) che si riferisce alle pagine Web ritenute rilevanti

rispetto alla richiesta dell’utente.

Il motore di ricerca si compone di tre elementi fondamentali: il

crawler, l’indice e il runtime system, o processore di query,

ovvero l’interfaccia e il software correlato che collegano le

richieste dell’utente all’indice. Il runtime system gestisce anche

questione primarie relative alla pertinenza e alla graduatoria dei

risultati. Ognuna di queste componenti contribuisce alla qualità

e alla velocità del motore, e ci sono centinaia di fattori in

ciascuna di esse che influiscono sull’esperienza globale della

ricerca. Ma i fondamentali sono più o meno gli stessi per tutti i

motori. Secondo le parole di Tim Bray, pioniere del settore, “il

fatto è che, dagli anni Settanta ad oggi, non ci sono stati rilevanti

passi avanti nella scienza fondamentale che studia il modo in cui

fare ricerche”23Quello che è cambiato riguarda piuttosto la

dimensione dei database e il modo di effettuare le query,

divenuto via via sempre più simile al linguaggio naturale.

Abbiamo introdotto un termine nuovo, crawler. E’ a partire da

questa funzione che comincia il reperimento dei risultati. Il

crawler, denominato alternativamente spider, robot o bot, è un

programma specializzato, il cui compito consiste nell’effettuare

una copia testuale di tutti i documenti che visita, inserendoli in

un indice. Il crawler si basa su una lista iniziale di indirizzi,

fornita dal motore di ricerca. Durante l'analisi di un documento,

identifica tutti i link presenti nel stesso e li aggiunge alla sua

lista. Tale ciclo viene ripetuto fino al completamento dell’intera

struttura ipertestuale

Pur essendo programmi basati su tecniche complesse, il lavoro

dei crawlers ha una logica piuttosto semplice: essi si collegano

senza sosta ai vari URL e riportano indietro ciò che trovano. I

crawlers sono inoltre la parte meno visibile di un motore di

ricerca, ma la più importante: quanti più siti riescono a

23 Lett., J.Battelle, “Google e gli altri”, 2006

41

contattare e quanto più spesso lo fanno, tanto più completo

risulterà l’indice e tanto più rilevanti saranno le SERP.

I primi crawlers scoprivano e indicizzavano solo i titoli delle

pagine Web, quelli odierni agiscono sull’intero contenuto della

pagina, sui metadati e su diversi tipi di file testuali e

multimediali.

Il crawler spedisce i suoi dati a un enorme database, chiamato

indice. L’indice è una sorta di lista di domini, a ciascuno dei

quali vengono associate le pagine che lo compongono e i dati

che lo riguardano (parole contenute, links, ecc…). L’indice

viene a questo punto invertito, di modo che l’associazione

funzioni anche al contrario. Tale passo è fondamentale, poiché

le liste di parole che vengono così create, sono successivamente

associate ai vari domini e sono pronte per essere presentate

come risposta alle query. Senza l’inversione il database saprebbe

che un URL contiene determinati termini, ma non saprebbe

rintracciare l’URL a partire dal suo contenuto.

Figura 8 La rappresentazione logica di un indice inverso

Come osserviamo nella figura 8, la struttura logica dell’indice

inverso è costituita da tre componenti: a sinistra, una lista dei

termini presenti nel documento; al centro la posting list,ovvero

una lista associata con ognuno dei termini, nella quale si trova

42

l’indicazione binaria circa la presenza di un certo termine in un

determinato documento, (spesso accompagnata da alcune

informazioni aggiuntive che velocizzano il reperimento); a

destra, l’indice dei documenti analizzati dal crawler.

Queste funzionalità rappresentano approssimativamente le basi

minime di un motore di ricerca. Fino alla fine degli anni

Novanta non ci si era spinti oltre questi aspetti. A partire da

quella data tuttavia, l’indice è divenuto un’importante terreno

d’innovazione per le società operanti nel settore, nonché il

fulcro della “ricetta segreta”. L’indice contiene infatti le

informazioni sui siti Web, che vengono poi interpretate

attraverso algoritmi e modelli statistici, durante la fase che

prende il nome di analisi dell’indice. Durante questa fase, grazie

a un sistema di metadati, i dati contenuti nell’indice vengono

etichettati con ulteriori informazioni (lingua, genere, tasso di

aggiornamento e così via). Questi metadati risultano decisivi

per consentire al motore di ricerca di offrire dati più rilevanti.

La fase successiva consiste nella creazione di un ponte tra le

richieste dell’utente e l’indice così formatosi. Tale funzione

viene eseguita da due elementi: l’indice runtime, un database sul

quale vengono riversati i dati analizzati, indicizzati ed

etichettati, e il query server, un software che inoltra i quesiti

dell’utente dall’interfaccia all’indice runtime. Il query server e

l’indice runtime costituiscono rispettivamente il front end e il

back end di un motore di ricerca.

Ora che abbiamo brevemente definito la struttura del motore di

ricerca, facciamo un passo indietro e uno in profondità, poiché

per comprendere i fattori di successo dei motori di ricerca

contemporanei, dobbiamo addentrarci nel cuore dell’IR. I

paragrafi successivi analizzano gli aspetti che hanno maggiori

punti di contatto con la ricerca di informazione sul Web: tale

43

analisi ci condurrà a indagare sul come le operazioni appena

descritte vengano eseguite.

2.2 L’Information Retrieval24

L’interesse per l’IR esiste da molto tempo prima di Internet: il

termine è stato coniato da Calvin Mooers, padre di uno dei primi

linguaggi di programmazione (il TRAC), alla fine degli anni '40

del Novecento. Tale disciplina nasce in un contesto a metà tra

l’informatica e la biblioteconomia, la scienza che si occupa della

catalogazione di grossi archivi attraverso metodi che assegnino

ai vari elementi presenti degli identificativi univoci.

Qual è il nodo cruciale che lega l’IR ai motori di ricerca? Un

buon punto di partenza è cominciare a chiederci che cos’è in

fondo Internet, se non un enorme archivio di documenti,

trattabili in fondo come testi. A questo possiamo aggiungere che al 31/01/2008, le stima

ufficiale delle pagine Web si attesta a quota 44,46 miliardi25.

L’84%delle risorse ricercabili su queste danno accesso a

documenti testuali.26 Ora probabilmente il legame è più chiaro.

La crescita esponenziale di database online di documenti in

linguaggio naturale, ha reso sempre più complessa una ricerca

efficace ed efficiente dell’informazione desiderata dall’utente.

Abbiamo usato questi due termini, efficace ed efficiente, non a

caso: l’obiettivo primario dell’IR è quello di rendere rapida,

semplice e valida la ricerca dei documenti all’interno degli

archivi: la misura di quanto questo avvenga in maniera ottimale

24 Questa sezione è basata sul testo: C.D. Manning, Prabhakar Raghavan, Hinrich Schütze, “An introduction to Information Retrieval”, 2008 25 Fonte: http://www.worldwidewebsize.com 26 Fonte: Masoud Mohammadian, Intelligent Agents for Data Mining and Information Retrieval, Idea Group Publishing, 2004

44

è data da due parametri, solitamente indicati come effectiveness

ed efficiency.

Il concetto di effectiveness si riferisce al grado di soddisfazione,

da parte del sistema, del bisogno d’informazione dell’utente,

riguarda dunque la rilevanza della risposta rispetto alla richiesta.

L’efficiency invece corrisponde al consumo di risorse da parte

del sistema: CPU, memoria centrale e memoria di massa

richieste, tempi di risposta: ha dunque a che fare con la potenza

di calcolo della macchina utilizzata e con gli algoritmi di ricerca

che vengono implementati.

I due parametri in base ai quali viene universalmente valutata

l’effectiveness di un sistema di information retrieval si

chiamano precision e recall.

La precision designa la proporzione di documenti effettivamente

rilevanti in rapporto al totale dei documenti restituiti dal sistema

in risposta ad una query dell’utente.

Il recall corrisponde alla proporzione dei documenti rilevanti

restituiti dal sistema in rapporto al totale dei documenti rilevanti

(restituiti e non) presenti nella collezione esaminata.

In linea teorica, possiamo immaginare un sistema perfetto,

costituito da precision e recall perfetti, ove il numero di

documenti rilevanti corrisponda esattamente a quello dei

documenti restituiti. Purtroppo la realtà è diversa, i sistemi di IR

sono imprecisi, e i due parametri risultano spesso inversamente

proporzionali, dunque ad un’alta precision, susseguente ad una

45

selezione molto specifica, corrisponde un basso recall, è

probabile cioè che molti documenti rilevanti non siano stati

recuperati. L’opposto accade nel caso di alto recall: un gran

numero di documenti restituiti, dei quali molto pochi davvero

rilevanti. Nel diagramma in figura 9 osserviamo graficamente la

relazione tra i due parametri.

2.2.1 Automatic text analysis

Ora che abbiamo visto alcune tra le più importanti variabili in

gioco nell’IR, torniamo al cuore della questione. Siamo di fronte

a una grande mole di informazioni, il cui reperimento risulta

complesso, in quanto abbiamo a disposizione degli strumenti di

calcolo “numerico” a fronte a di dati in forma testuale, ossia non

strutturata. I problemi principali riguardano innanzitutto la

difficoltà di interpretazione delle ambiguità dei linguaggi

naturali da parte di un sistema informatico, in secondo luogo la

vaghezza e l’imprecisione del bisogno informativo espresso

dall’utente. La soluzione viene affidata a metodi automatici che

migliorino l’accuratezza e la velocità di ricerca e di

organizzazione dei documenti.

Figura 9 La relazione tra Precision e Recall

46

In che modo? E’ necessario che il calcolatore, più che agire

direttamente sul testo dei documenti, ne generi una

rappresentazione che abbia una forma idonea ad un’analisi

automatizzata. In poche parole, costruisce un modello del testo.

Tale modello deve rappresentare, in forma schematica, il

contenuto del documento in esame.

Lo schema di cui parliamo è una lista di termini estrapolati dal

documento, che ne rappresentino sinteticamente il contenuto. A

partire da questa lista, si procederà poi alla creazione del

modello, come vedremo in seguito. Con quale criterio viene

creata la lista? Secondo uno dei punti basilari della teoria

dell’IR, la frequenza con la quale un termine ricorre all’interno

di un testo, è un indice significativo della sua importanza

all’interno del testo stesso.27 Di conseguenza, un buon modello

del documento potrebbe essere una lista delle parole

maggiormente ricorrenti al suo interno. Tuttavia, è facile

obiettare che esistono parole, come congiunzioni ed articoli, che

hanno una grande ricorrenza all’interno dei testi, senza però

caratterizzarli semanticamente.

Come stabilire allora quali siano i termini di un testo che il

sistema deve considerare come indici significativi? La risposta

sta nella legge di Zipf28, che mette in relazione la frequenza con

cui le varie parole compaiono in un testo, con il loro rank, ossia

la posizione che occupano in un’ideale scala delle frequenze.

Secondo tale legge, il prodotto tra queste due variabili è

approssimativamente costante.29 La distribuzione dei termini di

un testo di media lunghezza che si ricava da questa legge è la

seguente:

27 La teoria dell’IR, http://www.volocom.it/doc/info_retrieval.pdf 28 G.K.Zipf, "Human Behaviour and the Principle of Least-Effort", 1949. 29 Legge di Zipf, http://it.wikipedia.org/wiki/Legge_di_Zipf.

47

� Elevatissima frequenza di pochi termini (sono gli articoli

e le congiunzioni di cui sopra);

� Un numero considerevole, anche se non elevatissimo, di

elementi che occupano posizioni intermedie sulla scala

delle frequenze d’utilizzo;

� Un altissimo numero di elementi con frequenza tendente

a zero. Se ci riferiamo al linguaggio, si tratta di tutte

quelle parole che non vengono quasi mai utilizzate.

Tali considerazioni, poi applicate da Luhn ai propri studi30,

hanno poi portato all’introduzione di due valori di soglia

(cut-off), uno superiore e uno inferiore. Le parole che stanno

oltre il valore di soglia superiore vengono considerate troppo

comuni, mentre quelle al di sotto della soglia inferiore

vengono considerate troppo rare; in entrambi i casi questi

termini non danno un contributo significativo al contenuto

del testo. Nella figura 10 osserviamo graficamente la curva

iperbolica che rappresenta la legge di Zipf: sulle ascisse

troviamo il rank delle parole, sulle ordinate la frequenza

delle stesse; la zona grigia al centro è costituita dai termini

rilevanti all’interno di un testo, che raggiungono il picco di

rilevanza all’apice della cosiddetta funzione di risoluzione,

rappresentata dall’iperbole tratteggiata .

30 H.P. Luhn, “The automatic creation of literature abstract”, IBM Journal, 1958.

48

Figura 10 Curva di Zipf e funzione di risoluzione

Giungiamo così all’assunzione che il resolving power delle

parole, ossia la loro facoltà di discriminare il contenuto dei

documenti, raggiunga un picco in una posizione nel rank order

circa a metà tra i due valori di cut-off e tenda a zero all’incirca in

corrispondenza dei due sopraccitati valori di soglia.

Ovviamente i valori di soglia non sono stabiliti univocamente,

ma vengono fissati di volta in volta in maniera convenzionale.

A questo punto, resta ancora da capire come vengano modellati i

documenti in modo che possano essere analizzati in un sistema

automatico di IR.

Potremmo pensare al nostro modello come a una lista di class

names, dove ogni class name rappresenta una classe di parole

presenti nel testo esaminato (vedremo più avanti in che modo)

che fanno tutte riferimento ad un medesimo concetto; tali class

names diventeranno poi le parole significative che rappresentano

il contenuto del documento.

La costruzione del modello avviene in tre fasi:

1. Rimozione delle parole che compaiono troppo

frequentemente;

2. Rimozione dei suffissi (suffix striping o stemming);

49

3. Individuazione delle radici (o stem) comuni a più parole

(questa operazione viene generalmente indicata come

conflation).

La rimozione delle parole con un’alta frequenza di occorrenze

(tali parole sono conosciute in letteratura come stop words) è un

modo per implementare il cut-off di cui si è parlato con

riferimento alla figura 10; l’eliminazione delle stop words

costituisce un passo necessario nella progettazione di un sistema

di IR. I vantaggi di questa operazione sono molteplici:

innanzitutto si rimuovono dei termini che non sono significativi

per il contenuto del testo in quanto compaiono praticamente in

tutti i documenti: tali termini non interferiranno

durante la fase di ricerca e recupero; in secondo luogo si

diminuisce la dimensione del documento, generalmente tra il

30% e il 50%, con un chiaro risparmio di risorse e tempi di

elaborazione.

La seconda fase consiste nella rimozione dei suffissi dalle

parole; tale operazione viene detta suffix striping oppure

stemming; l’approccio standard adottato negli algoritmi di suffix

striping più utilizzati consiste nell’avere una lista completa dei

suffissi e nel rimuovere il più possibile quelli più lunghi, ad

esempio le parole “smoke, smoker, smoking” diventano tutte

rappresentanti della radice “smok-”.

Purtroppo la rimozione incontrollata dei suffissi può produrre

degli errori grossolani:

EQUAL � EQ �???

Per evitare errori di questo tipo è opportuno introdurre delle

regole (di tipo quasi “grammaticale”) più restrittive: il suffisso

verrà rimosso soltanto se tali regole saranno rispettate. Ad

esempio si impedisce che lo stem ottenuto dalla rimozione del

50

suffisso sia più corto di un certo numero di caratteri, oppure che

termini con determinate lettere o sequenze di lettere.

L’assunzione che sta alla base del terzo passo (conflation) è che,

nel contesto dell’IR, se due parole hanno la stessa radice o stem,

allora si riferiscono al stesso concetto e possono essere

indicizzate come un’unica entità. Questa assunzione va bene

nella maggioranza dei casi, ma anche qui può portare talvolta ad

errori marchiani in quanto parole molto simili possono avere

significati completamente diversi (ad esempio “pain” e “paint”).

Poiché non esiste un metodo economico per effettuare una

simile distinzione, si mette in conto che permarrà una certa

percentuale di errore e si assume che tale percentuale di errore

non infici troppo l’efficacia del sistema. Si utilizzano dunque

degli algoritmi di conflation che generano una serie di classi,

una per ogni diverso stem che è stato ottenuto.

Alla fine si ottiene un modello dei documenti costituito da una