TECNOLOGIA DELLA DIMOSTRAZIONE - CleverCoder.net - Gil...

Transcript of TECNOLOGIA DELLA DIMOSTRAZIONE - CleverCoder.net - Gil...

Università degli Studi di Trieste

Facoltà di Scienze Matematiche, Fisiche e Naturali

Tesi di laurea in

MATEMATICA

TECNOLOGIA DELLA

DIMOSTRAZIONE

SVILUPPO DI UNO SCENARIO DI VERIFICA

AUTOMATICA

Relatore:

Laureando:

Prof. Eugenio Omodeo

Gil Vegliach

Correlatore:

Prof. Sergio Invernizzi

Anno accademico 2009-2010

[ 18 settembre 2010 at 15:34 ]

I N D I C E

1 Introduzione 5

2 Perché verificare le dimostrazioni? 7

3 Cos’è un proof assistant? 13

4 Il verificatore Referee 17

5 Dimostrare in Ref 19

6 Verso il teorema di Stone... 25

7 Algebre booleane in Ref 27

8 La dimostrazione classica del teorema di Stone 31

9 La parte topologica:caratterizziamo la compattezza 339.1 Le leggi di De Morgan 37

10 Risultati finali e sviluppi futuri ... 39

bibliografia 40

3

[ 18 settembre 2010 at 15:34 ]

1I N T R O D U Z I O N E

Nel corso della storia le dimostrazioni si sono fatte via via piùlunghe e complesse. La prima proposizione degli Elementi diEuclide, la costruzione di un triangolo equilatero dato un lato,riempiva poche righe (Euclide [2010]). Le dimostrazioni delleproposizioni non occupavano in generale più di una pagina. Iteoremi di oggi invece si estendono su svariati articoli tecnici,ognuno lungo decine di pagine. Si prenda ad esempio il teoremadell’indice di Atiyah-Singer1 oppure la più recente classificazionedei gruppi semplici finiti2. Come possiamo essere sicuri che que-ste dimostrazioni siano corrette? Come può aiutarci la tecnologiain questo compito?

Nel presente lavoro parleremo di proof-checking, cioè il pro-cesso di usare del software per controllare le dimostrazioni. Unadimostrazione scritta in un linguaggio formale viene data in pa-sto a un verificatore automatico, il quale la controlla e ci dice setutto è filato liscio oppure se qualcosa non va. In quest’ultimocaso viene generato un diagnostico con gli errori commessi, erroriche potranno venir corretti prima di una nuova esecuzione delverificatore.

Come particolare verificatore automatico useremo Ref, unsoftware sviluppato da Jacob T. Schwartz e E.Omodeo. Refè un verificatore automatico basato sulla teoria degli insiemi.

In Ref svilupperemo uno scenario che caratterizza la com-pattezza di uno spazio topologico attraverso le intersezioni diinsiemi chiusi.

Per quanto semplice, questo risultato è un primo passo versol’integrazione di un preesistente scenario sul teorema di Sto-ne sulla rappresentazione delle algebre di Boole con tutte leinformazioni topologiche del caso (Stone [1936]).

1 la dimostrazione del celeberrimo teorema dell’indice Atiyah-Singer compiutanegli anni ’60 era divisa in quattro lunghi articoli negli Annals of Mathematicse usava un sacco di strumenti da altre fonti

2 il teorema di classificazione dei gruppi semplici finiti è talmente lungo da esserechiamato teorema enorme

5

[ 18 settembre 2010 at 15:34 ]

2P E R C H É V E R I F I C A R E L E D I M O S T R A Z I O N I ?

La prima volta che una persona è introdotta al concetto didimostrazione questo viene spiegato più o meno così

ragionamento deduttivo che partendo da certe ipotesi ve-rifica una tesi, la cui validità è dovuta alla coerenza delragionamento

In pratica una dimostrazione è un certificato di garanzia, unaprova inconfutabile della validità della nostra tesi. Perché con-trollare il certificato allora? Nessuno si preoccupa degli errorid’ortografia nella garanzia di un cellulare, ma la matematica èuna cosa diversa. La matematica parla di certezza, una certezzaderivata dal fatto di costruire i propri concetti tramite un rigo-roso procedimento logico-deduttivo, partendo da pochi assiomiritenuti veri.

In teoria uno potrebbe scommettere la casa sulla correttezzadella classificazione dei gruppi finiti semplici. In teoria funziona.In pratica nessuno lo farebbe mai: noi matematici commettiamospesso degli errori. Basta un segno invertito, una lettera scrittamale o qualche piccola svista ed ecco partire una serie di deduzio-ni errate. Su queste deduzioni costruiamo intere teorie, magari lepubblichiamo, finché ci accorgiamo del nostro errore. Il nostrocastello concettuale distrutto dalla rimozione di un solo mattone.

Gli errori possono infiltrarsi anche in ciò che non vediamo.Spesso un passaggio ci sembra ovvio e sicuramente non vale lapena verificare tutte le parti, perciò non le scriviamo. E abbiamoi nostri buoni motivi per questo comportamento: quando AlfredNorth Whitehead e Bertrand Russel provarono a scrivere tutti ipassaggi anche solo di una parte elementare della matematica,produssero un libro di 2000 pagine (Whitehead e Russell [2009]).Lo stesso Russell ammise ad un amico

non credo che alcun essere umano lo leggerà mai per intero

Tra piccole sviste e passaggi dimenticati la nostra sicurezzacomincia a vacillare. Come possiamo essere sicuri che il nostrolavoro sia corretto?

La soluzione di oggi si basa sul peer-review, la revisione deipari. Un articolo, prima di esser pubblicato, viene inviato ano-nimamente ai referee, anonimi arbitri che lavorano nel nostrostesso campo. I referee credono che il materiale sia corretto eche contenga della sostanza? Sì, allora il giornale si occupa dipubblicare l’articolo. La correttezza viene dunque ad essere unprocesso sociale, un processo che soffre degli stessi svantaggidel fattore umano visti sopra: piccoli errori possono sfuggire, epiccoli errori portano a grandi disastri.

Per fortuna i nostri punti deboli sembrano essere coperti dallatecnologia. Il computer, benché sprovvisto di alcuna intelligenzapropria, è molto veloce nel controllare una miriade di passi

7

[ 18 settembre 2010 at 15:34 ]

2 Perché verificare le dimostrazioni?

semplici. Se una dimostrazione potesse essere scritta nei suoipassi più elementari, un computer potrebbe facilmente verificarnela correttezza.

Questa è l’idea del proof-checking: scrivere una dimostrazionein tutti i suoi dettagli e poi farla controllare a un computer. Intutti i suoi dettagli significa ridurre una dimostrazione a livello dilogica proposizionale, in cui le regole di inferenza sono semplicie indiscutibili: la validità è garantita. Controllarla a computersignifica meccanizzare quello che è il peer-review di oggi: ilfattore umano può esser impiegato nel discutere il senso e l’utilitàdelle dimostrazioni invece che perder tempo sulla parte logica.

Per capire come il computer possa aiutarci in questo compitovedremo alcuni esempi di errori storici e come la tecnologia ci siavenuta in aiuto.il teorema dei 4

colori,il teorema piùverificato della storia

Nel 1852 Francis W. Guthrie, laureato al University Collegedi Londra, propose il seguente problema al fratello Frederick(Krantz [2007]):

Immagina una mappa sulla superficie della terra, una map-pa suddivisa in regioni. Non ci sono fiumi o laghi a divi-dere le regioni, né altre zone d’acqua. L’unica regola èche ogni regione sia un’unica massa contigua senza bu-chi. In qualità di cartografi, vorremmo colorare la mappain modo che nessuna regione adiacente abbia lo stesso co-lore. Quanti colori dobbiamo comprare? Quanti coloridobbiamo comprare per colorare una qualsiasi mappa?

Il problema passò di man in mano a molti matematici illu-stri: primo tra tutti Augustus De Morgan, 1 un professore diGuthrie, poi W. R. Hamilton 2 e infine A. Cayley 3 ne parlò inuna pubblicazione del 1878. Le voci arrivarono fino a Göttingendove Felix Klein4 dichiarò che l’unica ragione per cui il problemaera irrisolto era che nessun matematico capace ci aveva ancoralavorato. Lui ci provò e fallì. Ma la storia non finisce qui: nel 1879A. Kempe5 pubblicò una soluzione. La dimostrazione resistetteper undici anni quando P.Heawood6 trovò un errore. Purtroppol’errore di Kempe non era eliminabile anche se Heawood riuscìa tirare fuori molti concetti carini, come ad esempio il numerocromatico di una superficie. Un altro tentativo fallito fu a operadel matematico Tait: dimostrazione presentata nel 1880, erroretrovato nel 1891 da Peterson.

Dopo tutti questi tentativi falliti il teorema dei quattro colori di-ventava celebre: contributi parziali furono dati da Birkhoff, Frank-lin, Heesch e Stromquist ma nessuna dimostrazione completa eraancora conosciuta.

Così quando nel 1974 Kenneth Appel7 e Wolfgang Haken8

annunciarono di avere una dimostrazione la notizia si scontrò

1 Augustus De Morgan, 1806–1871. È l’autore delle famose leggi di De Morgan2 William Rowan Hamilton, 1805-1865. È l’autore del teorema di Cayley-Hamilton3 Arthur Cayley, 1821-18954 Felix Klein, 1849-19255 Alfred Bray Kempe, 1845-19226 Percy John Heawood,1861-19557 Kenneth Ira Appel, 1932–8 Wolfgang Haken, 1928–

8

[ 18 settembre 2010 at 15:34 ]

con un pubblico incerto e dubbioso. Era forse questa la voltabuona? La tecnica di Appel e Haken era di ridurre la casistica dimappe a 1936 configurazioni fondamentali, dimostrando indivi-dualmente il teorema per ogni configurazione. Fin qui niente dieccezionale, tranne per il fatto che le 1936 configurazione eranostate dimostrate dai supercomputer dell’università dell’Illinois,in circa 1200 ore di computer-time. Nessun essere umano sa-rebbe mai riuscito a controllare una dimostrazione così lunga ecomplicata e molto si dibattè se questa fosse una dimostrazionefilosoficamente accettabile. Finora per quanto una dimostrazionefosse stata una lunga e intricata sequenza di passaggi logici erasempre stato possibile che un altro essere umano la controlli.

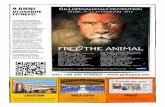

I piccoli errori trovati nel programma

4-colorazione

negli anni a venire – sempre prontamen-te corretti – contribuirono ad aumentare isospetti.

Nel 1994 Paul Seymour e il suo grup-po all’università di Princeton trovarono unnuovo algoritmo più stabile per dimostrareil teorema. L’approccio soffriva dei stessiproblemi di quello di Appel e Haken manel 2004 Gonthier, uno scienziato alla Mi-crosoft Research a Cambridge, usò un proofassistant per controllare la dimostrazione

(Gonthier [2008]). La dimostrazione non era stata controllata daun essere umano ma almeno era stata controllata 9.

Una domanda però sorse spontanea: Se il verificatore avessedei bug la verifica non sarebbe stata valida. La correttezza delladimostrazione sarebbe nuovamente incerta. Come possiamoescludere questa eventualità?

Enunciato delteorema dei 4-coloriscritto da Gonthierin Coq v7.3.1

Variable R : real_model.Theorem four_color : (m : (map R))(simple_map m) -> (map_colorable (4) m). Proof.Exact (compactness_extension four_color_finite). Qed.

La risposta di Gonthier fu servirsi di un verificatore con unkernel il più corto possibile, con il minor numero possibile diassiomi e di regole d’inferenza. Anche se il software non sarà maiin grado di garantire la certezza assoluta la dimostrazione delteorema dei quattro colori diventò così una delle dimostrazionipiù scrupolosamente verificate della storia, citazione di Hales.

Hales è un professore di Pittsburgh che fu direttamente coinvol-to nel proof-checking quando dimostrò la congettura di Kepleronel ’98. la congettura di

KepleroLa congettura di Keplero nasce ingenuamente da una domandadi Sir Walter Releigh 10, al matematico inglese Thomas Harriot:

9 In cosa differisce l’uso del computer di A.& H. da quello di Gonthier? Usiamouna metafora, supponiamo di dover mostrare 1 + 1 = 2 usando un computer.A.&H. avrebbero lanciato l’applicazione Calcolatrice ed eseguito il conto. Gon-thier avrebbe assiomatizzato l’aritmetica, dimostrato che il successore di 1 sia 2e controllato il tutto con un software ad hoc

10 Sir Walter Releigh, 1552-1618. Navigatore, corsaro e poeta inglese

9

[ 18 settembre 2010 at 15:34 ]

2 Perché verificare le dimostrazioni?

”qual è il modo più efficiente per disporre le palle di cannone sulponte della mia nave” La domanda risultò di notevole interessematematico e fu passata da Harriot a Johannes Kepler 11 chela pubblicò nel 1611 in un libricino intitolato Strena seu de nivesexangula (Sul fiocco di neve e sei angoli)

Messa in uno stile più matematico la domanda non riguardaval’artiglieria ma suonava più o meno così: qual è il modo piùefficiente possibile di impacchettare sfere uguali nello spazio?

Può sembrare più astratto ma il problema è in pratica quelloche si trova ad affrontare un fruttivendolo ogni giorno: disporreil maggior numero di arance nel minor spazio possibile.

Facile da enunciare, ma non altrettanto da risolvere questoproblema ha una lunga storia: i primi contributi furono dati nelcaso bidimensionale da Carl Friedrich Gauss e Axel Thue.

Gauss provò che la disposizione regolare che garantisce ladensità più alta è il reticolo esagonale. Thue provò che il reticoloesagonale garantisce la densità più alta sia tra le disposizioniregolari, sia tra quelle irregolari (1890).

Il passo successivo verso una soluzione fu fatto dal matematicoungherese László Fejes Tóth 12. Nel 1953 Fejes Tóth mostrò cheil problema di determinare la massima densità di tutte le dispo-sizioni di sfere, regolari ed irregolari, poteva essere ridotto a unnumero finito, anche se molto grande, di calcoli. Questo signifi-cava che era possibile, almeno in linea di principio, trovare unadimostrazione per esaustione. Un computer sufficientemente po-tente avrebbe potuto fornire un approccio pratico alla risoluzionedel problema.

Nel frattempo vennero fatti tentativi per trovare un estremosuperiore per la massima densità di un qualunque impacchetta-mento di sfere. Il matematico inglese Claude Ambrose Rogersstabilì un limite superiore di circa 78% nel 1958, e tentativi succes-sivi fatti da altri matematici ridussero leggermente questo valore,che era comunque di molto superiore alla densità dell’impacchet-tamento cubico, cioè 74%. Furono anche prodotte dimostrazionierrate. L’architetto e geometra statunitense Buckminster Fulleraffermò di essere in possesso di una dimostrazione nel 1975, masi scoprì poco dopo che non era corretta. Nel 1993 Wu-Yi-Hsiang,all’University of California, Berkeley pubblicò un articolo in cuiaffermava di aver dimostrato la congettura di Keplero usandometodi geometrici. Alcuni esperti affermarono di non aver tro-vato motivazioni sufficienti per alcune delle sue affermazioni.Sebbene non fosse stato trovato nulla di scorretto nel lavoro diHsiang, la maggioranza del mondo matematico si trovò d’accor-do nell’affermare che la dimostrazione di Hsiang era incompleta.Uno dei critici più attivi fu proprio il nostro Thomas Hales, cheall’epoca stava lavorando a una sua dimostrazione.

Seguendo l’approccio suggerito da Fejes Tóth, Thomas Hales,all’epoca all’University of Michigan, determinò che la massi-ma densità di tutti gli impacchettamenti poteva essere trovataminimizzando una funzione di 150 variabili. Nel 1992, assisti-to dal suo allievo laureato Samuel Ferguson, diede inizio a un

11 Johannes Kepler (Giovanni Keplero), 1571-163012 László Fejes Tóth, 1915-2005

10

[ 18 settembre 2010 at 15:34 ]

programma di ricerca per applicare sistematicamente i metodidella programmazione lineare alla ricerca di un limite inferioreper il valore di questa funzione relativo a un insieme di più di5000 differenti configurazioni di sfere. Se, per ognuna di questeconfigurazioni, fosse riuscito a trovare un limite inferiore chesuperasse il valore relativo all’impacchettamento cubico, allorala congettura di Keplero sarebbe stata dimostrata. La ricerca ditutte queste limitazioni inferiori avrebbe richiesto la soluzionidi circa 100.000 problemi di programmazione lineare. Quandopresentò i progressi del suo progetto nel 1996, Hales affermò diessere in vista della fine, ma che avrebbe avuto ancora bisogno diun anno o due. Nell’agosto del 1998 Hales annunciò che la dimo-strazione era completa: 250 pagine di annotazioni e 3 gigabyte diprogrammi per computer, dati e risultati.

Hales non mandò la sua dimostrazione a una rivista qualsiasi,mandò la sua dimostrazione agli Annals of Mathematics. GliAnnals of Mathematics (Annali della matematica) è la rivistamatematica più prestigiosa al mondo e, come ci si aspetterebbe,è quella con le regole di pubblicazione più rigide. Non consideraarticoli troppo lunghi, cerca solo problemi di effettivo interessee pubblica solamente scritti in forma tradizionale. In breve, ladimostrazione di Hales non rispettava nessun standard dellarivista. Ciononostante Robert MacPherson, il Managing Editordella rivista, era interessato alle dimostrazioni fatte a computer.Credeva che il computer potesse risolvere i soliti vecchi problemi.E così considerò lo scritto. Fu istituita una commissione di dodicireferee e nel 2003, dopo quattro anni di lavoro, il capo della com-missione Gábor Fejes Tóth (figlio di László Fejes Tóth) annunciòche la commissione era certa al 99% che la dimostrazione eracorretta, ma che non poteva garantire la correttezza di tutti icalcoli fatti al computer.

Hales decise che certa al 99% non era abbastanza. Così ini-ziò il progetto FlysPecK, dove le lettere F, P e K sono le inizialidelle parole che compongono la frase Formal Proof of Kepler. Lasua stima è che ci vorranno 20 anni-persona di lavoro, cioè unlavoro di 20 anni per una singola persona, oppure 10 anni perdue persone. Ora progetto sembra essere a metà strada. L’im-portanza di questo anedotto riesiede nel fatto che nonostante ladimostrazione sia considerata sufficientemente corretta da unarivista prestigiosa come gli Annals of Mathematics lo stesso Halesnon è soddisfatto. Se possiamo citare con disinvoltura i teoremicontenuti negli Elementi di Euclide è perché la matematica sibasa su certezze assolute. E così, per ottenere la certezza assoluta,Hales si rivolse al mondo dei verificatori automatici.

Un altro esempio in cui i proof-assistant giocarono un ruolodecisivo fu quando il professore del Lynchburg College, ThomasNicely, scoprì un bug nell’istruzione di divisione del primo pen-tium della Intel nel ’94. Questa volta non si trattava di astrattiteoremi matematici ma di migliaia di computer nel mondo cheogni giorno sbagliavano di fare le divisioni. L’errore compariva il bug nei Pentiumsoltanto dopo svariate cifre decimali ed era sfuggito agli ingegne-ri della Intel. Nessun problema, dunque, per dividere il contodi una pizza, ma da un computer non ci si può aspettare questa

11

[ 18 settembre 2010 at 15:34 ]

2 Perché verificare le dimostrazioni?

superficialità.E la Intel l’aveva capito: quando Nicely mandò il suo report

nell’ottobre del ’94, l’azienda già si era accorta da qualche mesedel problema, ma aveva segretamente taciuto fino ad allora. Cosasarebbe successo se il grande pubblico si fosse accorto che iloro processori sbagliavano? Il danno economico sarebbe statoenorme.

Nicely aveva bisogno del computer nelle sue ricerche sui nu-meri primi: stava enumerando tabelle di numeri primi, coppiee triplette di primi quando notò delle discrepanze nei risultati.Le discrepanze erano cominciate quando era stato introdotto ilprimo Pentium nell’arsenale computazionale. Nicely continuòad inviare mail i suoi colleghi e amici chiedendo se anche lororisconstrassero lo stesso problema.

E così pian piano la storia si diffuse: comparsa in un articolodel Electronic Engineering Times il 7 novembre 1994, fu successi-vamente mandata in onda dalla cnn il 21 novembre dello stessoanno. La notizia ormai era giunta al grande pubblico tanto cheil bug si conquistò addirittura un nome–laddove di solito i bugsono catalogati con un banale numero di identificazione: Pentiumfdiv bug, dove fdiv è l’istruzione per la Floating-point Divisionnel linguaggio assembly x86.

Un duro colpo per la Intel, un danno eco-nomico e d’immagine. Molti utenti recla-marono la sostituzione del loro processori.

Intel rispose con un colpo d’ingegno: do-po aver ritirato i processori difettosi li tra-sformò in graziosi portachiavi con sopraincisa una citazione di Andy Grove, unodei fondatori della stessa Intel:

Bad companies are destroyed by crisesgood companies survive themgreat companies are improved by them

E così da quel giorno, un po’ per tenere fede alla frase ad effetto,un po’ per il colpo subito costato 475.000.000$, Intel migliorò sulserio: si affidò a software di verifica automatica per gli algoritmidei suoi processori. (La intel usa Hol light, lo stesso verificatoredel teorema dei quattro colori di Hales, vedi articolo di Geuvers[2009])

12

[ 18 settembre 2010 at 15:34 ]

3C O S ’ È U N P R O O F A S S I S TA N T ?

Un proof assistant è un programma che serve per formalizzareteorie matematiche. Formalizzare una teoria matematica significaesprimerla in un linguaggio logico-formale elaborabile da uncomputer, includendo tutti i teoremi, dimostrazioni e definizionidi cui la teoria stessa ha bisogno. Ogni dettaglio deve essereincluso: vietato etichettare un passaggio come ovvio o lasciarloal lettore.

Nella pratica un proof assistant legge un lungo file di testo,comprendente migliaia di righe di enunciati e definizioni e dicese il contenuto è corretto. Il file di input si chiama proof script, ela modalità di lavoro si dice batch. Il proof assistant fa il lavoro diun diligente ragioniere, ma invece che verificare pian piano unamiriade di conti, verifica per noi una lunga catena di inferenzelogiche.

Ogni proof assistant è distinto dalla sue caratteristiche, tra lepiù importanti c’è la sintassi. La sintassi determina il modo incui l’utente scriverà le dimostrazioni e può essere procedurale odichiarativa.

Una dimostrazione in stile dichiarativo è strutturata in blocchi.Ogni blocco dichiara una serie di affermazioni ognuna derivantedalle precedenti. Il sistema è responsabile di riempire i dettaglidi basso livello tra i vari passaggi. In sostanza, l’utente dice alverificatore dove vuole arrivare. Questo sistema, usato ad esempioda Mizar e Isabelle, è il modo naturale di pensare dei matematici,ma è poco efficiente e produce dimostrazioni molto prolisse.

Una dimostrazione in stile procedurale contiene invece tutti ipassaggi. Ogni passaggio è come un comando di basso livelloal proof assistant. In sostanza, l’utente dice al proof assistantcosa vuole fare. Questo è lo stile adottato da Gonthier quandoformalizzò la dimostrazione del teorema dei quattro colori inCoq (Wiedijk [2007]).

Quale sia il miglior approccio è in fase di discussione: laddoveuno stile dichiarativo e classico assomiglia molto al modo natu-rale di pensare di un matematico, produce dimostrazioni moltolunghe e tediose. Uno stile procedurale è meno naturale, mapermette di scrivere meno, fattore chiave in dimostrazioni lunghecome quella del teorema dei quattro colori. Per una discussionesi veda l’articolo di F. Wiedijk (Wiedijk [2007])

La prima volta che si utilizza un proof assistant, subito ci sirende conto del livello di dettaglio necessario: leggi insiemisticheconsiderate ovvie come la distributività dell’intersezione rispettol’unione oppure le leggi di De Morgan vanno dimostrate passo apasso (vedi appendice), e in generale ogni dimostrazione è cinquevolte più lunga della sua controparte informale. Per questo è difondamentale importanza la costruzione di una libreria standardcon i risultati più comuni della matematica: ciò permetterebbe dinon dover riscrivere ogni volta i risultati più comuni.

13

[ 18 settembre 2010 at 15:34 ]

3 Cos’è un proof assistant?

Un progetto in questa direzione si può trovare al sito (Wiedijk[2010]). È una specie di top 100 della matematica, una lista di100 teoremi ben noti di cui ogni matematico riconoscerebbe ilvalore. I teoremi spaziano in complessità e difficoltà: si partedall’irrazionalità di radice di 2 al teorema fondamentale dell’alge-bra, passando per il teorema del punto fisso di Brouwer e per ladisuguaglianza media geometrica vs media aritmetica. Lo scopoè creare una lista standard di teoremi da formalizzare, un fermopunto di partenza su cui poi costruire altri teoremi. La statoattuale del progetto (settembre 2010) copre l’84% dei teoremi,nello specifico abbiamo i seguenti risultati:

Verificatore % th. formalizzatiHol Light 75Mizar 51Coq 49C-CoRN 10Isabelle 46ProofPower 42PVS 15nqthm/ACL2 12NuPRL/MetaPRL 8

Nella lista, notiamo che la maggior parte del lavoro è stata fattaper i primi tre verificatori. Non è un caso, infatti questi sono iproof assistant più diffusi: Hol light, Mizar e Coq. Ne faremoun rapido confronto, in cui emergeranno altre funzionalità chepuò avere un verificatore.Hol light

Hol light (High Order Logic) è un dimostratore interattivodiscendente dal progetto lcf (Logic for Computable Functions),un altro dimostratore automatico sviluppato da Robert Milner nel1972. Hol è interattivo, cioè i comandi possono essere immessiuno alla volta, senza ricorrere alla modalità batch. La sintassi èdichiarativa, usa la logica classica e quindi ben si presta per chi èalle prime armi.

Il punto forte di Hol Light è la leggerezza: solo dieci rego-le d’inferenza e un kernel da meno di 500 righe di codice. Isostenitori sono così soddisfatti di questa caratteristica che stam-parono delle magliette con il codice sorgente in toto in segno dipropaganda.Mizar

Mizar è un sistema sviluppato da Trybulec a partire dal 1973all’università di Bialystock. Il linguaggio di Mizar ricalca quellodella matematica informale: è dichiarativo come Hol, ed è basatosu una teoria degli insiemi tipo Zermelo Fraenkel.

Lo progetto Mizar prevede non solo lo sviluppo del software,ma anche lo sviluppo di una libreria di articoli matematici formali,chiamata Mizar Mathematics Library (mml). Attualmente (omeglio al tempo della pubblicazione dell’articolo Mizar: Animpression, di Freek Wiedijk) la libreria contiene 587 articoli,occupanti uno spazio totale di 41 megabyte.Coq

Coq non solo fa il verificatore ma può anche descrivere spe-cifiche formali per lo sviluppo software o essere usato comelinguaggio funzionale di programmazione. È stato sviluppato

14

[ 18 settembre 2010 at 15:34 ]

in Francia, nel progetto TypiCal (ex progetto LogiCal) in siner-gia dalla inria, dalla École Polytechnique, dalla Paris-Sud 11University e dalla cnrs.

Coq implementa un linguaggio d’ordine superiore chiamatoGallina. Gallina è un linguaggio funzionale tipato basato sulcalcolo delle costruzioni induttive, cioè una variante d’ordinesuperiore del lambda calcolo tipizzato sviluppata da ThierryCoquand. Coq è stato utilizzato da Gonthier nella dimostrazionedel teorema dei quattro colori, la dimostrazione formale piùlunga fino ad oggi.

Dopo questa carrellata sui maggiori verificatori, vediamo comefunziona il nostro verificatore Ref. In Ref svilupperemo i proof-script che ci porteranno verso il teorema di Stone.

Tre pionieri. . .1954 M.Davis implementa l’algoritmo di Pre-

sburger per l’addizione aritmetica nelcomputer “Johniac” all’Institute for Ad-vanced Study. Johniac dimostrò chela somma di due numeri pari è pa-ri iniziando l’era della dimostrazione acomputer

1956 Inizia la formalizzazione dei PrincipiaMathematica di Russel e White. Entro lafine del 1959, la procedura di Wang avevagenerato dimostrazioni per ogni teoremadel calcolo predicativo contenuta nel libro

1968 N.G de Bruijn progetta il primo program-ma per verificare dimostrazioni matema-tiche. Il programma di nome Automa-th controllò ogni proposizione di un te-sto che Landau scrisse per la figlia sul-la costruzione dei numeri con i tagli diDedekind

1

1 tabella presa da Hales [2008]

15

[ 18 settembre 2010 at 15:34 ]

4I L V E R I F I C AT O R E R E F E R E E

Ætnanova, Refeeree o più semplicemente Ref, è un verificatoreautomatico basato sulla teoria degli insiemi sviluppato da JacobT. Schwartz (Omodeo et al. [2006]). Funziona nel seguente modo:l’utente scrive la propria dimostrazione su un file, la carica sulweb e lancia il verificatore. Il verificatore si preoccuperà di pro-cessare l’intero file–lavora in modalità batch–e ritornerà la paginadei tempi di verifica e degli eventuali errori.

Un errore sintattico fermerà immediatamente il verificatore: ilparser non riconoscerebbe più gli altri comandi. Un errore logicopermetterà comunque al verificatore di terminare l’esecuzione,generando una lista diagnostica con i problemi da correggere. Inquesta ottica Ref è più vicino a un compilatore di un linguaggiodi programmazione che ad un interprete: possiamo dargli inpasto molte righe alla volta piuttosto che doverlo lanciare dopoogni comando.

Un tipico scenario in Ref contiene un mix delle seguenti cose:teoremi più dimostrazioni, definizioni, teorie. Ogni dimostra-zione può citare solamente teoremi già verificati, che precedanol’attuale teorema in fase di verifica. Stessa sorte per le definizioni:gli oggetti da usare devono essere stati definiti precedentemente.

Quando abbiamo un sostanziale numero di teoremi e definizio-ni possiamo riunirli in una teoria, cioè in una struttura di livellopiù alto che serve a modularizzare il lavoro. Le teorie conferi-scono un tocco del secondo ordine su un sistema che altrimentisi baserebbe su una logica del primo. Esempi di teorie possonoessere la teoria sugli spazi topologici (topologicalSpace) o quellasul principio d’induzione finita (finiteInduction).

Illustriamo ora le caratteristiche di Ref tramite una dimostra-zione esemplificativa.

17

[ 18 settembre 2010 at 15:34 ]

5D I M O S T R A R E I N R E F

Prendiamo il seguente semplice teorema

Teorema 1:�{Y ∩ X : X ∈ C} = Y ∩

�{X : X ∈ C}

Il teorema dice che l’intersezione binaria d’insiemi distribuiscesull’unione arbitraria di insiemi. Niente di difficile. Il nostrocompito è tradurre la dimostrazione standard in una formaledigeribile da Ref.

Il primo passo è scrivere l’enunciato in modo formale. Nell’e-nunciato compare l’unione di una collezione d’insiemi e poichéRef non ha un simbolo built-in per tale scopo, la nostra primamissione è fornire questa definizione. Questo può essere fattosemplicemente con le seguenti righe

Def unionset: [unionset di una famiglia d’insiemi]Un(C) := { w: Y in C, w in Y }

La sintassi è molto naturale e ricalca la definizione che si puòtrovare in un libro di matematica. Le specifiche dell’istruzioneDef, come si può leggere nel manuale, sono

Def definitionName: symbolName(params): definisce il simbolo sym-bolName: può essere una costante, una funzione o un predicato

Ora possiamo scrivere l’enunciato del teorema

Theorem 1: [distrib. dell’intersezione sull’unione]Un({ Y * X : X in C }) = (Y * Un(C)). Proof:Suppose_not(Y0,C0) ==> AUTO

Tsomehow ==> falseDischarge ==> QED

Qui notiamo le prime caratteristiche vere e proprie di Ref: i teo-remi vengono annunciati dalla parola Theorem, segue un numeroo un nome identificativo e un facoltativo commento tra parentesiquadre. Scritto l’enunciato si mette un punto “.” e quindi laparola chiave Proof:. Dopodiché si inizia la dimostrazione vera epropria.

Le dimostrazioni si dividono in passi. Ogni passo ha la seguen-te struttura: Hint ⇒ Expr. Hint indica il meccanismo inferenzialeusato, Expr è la conclusione parziale che abbiamo raggiunto.

Il primo passo in una dimostrazione è sempre la negazionedella tesi, cioè la dimostrazione è “per assurdo”. L’Hint che ser-ve allo scopo è la Suppose_not. Questa istruzione, come la sua

19

[ 18 settembre 2010 at 15:34 ]

5 Dimostrare in Ref

cugina Suppose, apre una sottodimostrazione (in questo caso ladimostrazione principale) e svolge lo stesso ruolo che le espres-sioni supponiamo che non. . . e supponiamo che. . . svolgerebbero inun ordinario testo matematico.

La dicitura seguente, AUTO, svolge il compito più naturale cheviene suggerito dall’Hint prima della freccia (⇒). In questo casonega automaticamente la tesi.

Ogni sottodimostrazione deve essere chiusa da una Dischargeche scarica le ipotesi temporanee e mostra le conclusioni rag-giunte. Nel caso si chiuda la Suppose_not della dimostrazioneprincipale, la conclusione raggiunta sarà la fine della dimostra-zione, segnalata con la parola chiave QED. Da questo momento ilteorema sarà utilizzabile nella dimostrazione di altri teoremi.

Capita spesso di dover scrivere degli enunciati e di dimostrarlisolo in seguito: in questa situazione la prassi è scrivere una rigadel tipo

Tsomehow ==> false

Questa riga cita un inesistente teorema somehow che dovrebbeportare a una contraddizione. In questo modo possiamo concen-trarci sui teoremi più importanti lasciando in sospeso i lemmiaccessori.

Prima di vedere la dimostrazione matematica e trasformarlain una di Ref, riportiamo le specifiche delle istruzioni fin quiutilizzate

• Suppose: introduce un’ipotesi e relativa sottodimostrazione

• Discharge: chiude una sottodimostrazione

• Suppose_not: versione particolare della suppose per le di-mostrazioni per assurdo. È sempre il primo passo in unadimostrazione

• AUTO: introduce della assunzioni in modo implicito chevengono ricavate automaticamente dall’Hint utilizzata

• QED: chiude una dimostrazione e rende citabile il teorema

Faremo un parallelo tra dimostrazione usuale e formale. Que-sto aiuterà il lettore sia a capire come funziona Ref partendo daun punto di vista a lui noto, sia a sviluppare le dimostrazioni perconto proprio. La dimostrazione usuale suonerebbe più o menocosì

Dimostrazione. “⊆”: Sia z ∈ �{Y ∩ X : X ∈ C}, per definizionedi unione abbiamo ∃X0 ∈ X : z ∈ Y ∩ X0.

Dato che Y ∩ X0 ⊆ Y ∩�{X : X ∈ C} otteniamo z ∈ Y ∩�{X :X ∈ C}.

20

[ 18 settembre 2010 at 15:34 ]

“⊇”: Sia z ∈ Y ∩ �{X : X ∈ C}, per definizione di intersezioneed unione abbiamo: z ∈ Y ∧ ∃X0 ∈ X : z ∈ X0.

Quindi z ∈ Y ∩ X0 e dato che Y ∩ X0 ⊆�{X ∩ Y : X ∈ C}

otteniamo z ∈ �{X ∩Y : X ∈ C}

Tuttavia Ref accetta solo dimostrazioni per assurdo e quindidovremmo modificare leggermente la nostra dimostrazione. Lalunghezza non varia di molto.

Dimostrazione. “ �⊆”: Dato che vale “ �⊆” abbiamo che ∃z : z ∈�{Y ∩ X : X ∈ C} ∧ z �∈ Y ∩�{X : X ∈ C}.Per definizione di unione abbiamo ∃X0 ∈ X : z ∈ Y ∩ X0.

Assurdo perché Y ∩ X0 ⊆�{X : X ∈ C}

“ �⊇”: Dato che vale “ �⊇” abbiamo che ∃z : z ∈ Y ∩ �{X : X ∈C} ∧ z �∈ �{Y ∩ X : X ∈ C}

Per definizione di intersezione ed unione abbiamo z ∈ Y ∧∃X0 ∈ C : z ∈ X0, dunque z ∈ Y ∩ X0. Assurdo perché Y ∩ X0 ⊆�{Y ∩ X : X ∈ C}

Ora possiamo finalmente arrivare alla dimostrazione formale.Riportiamo lo scenario completo, per provarlo basta copiarlo neldimostratore.

--BEGIN HEREDef unionset: [unionset di una famiglia d’insiemi]Un(C) := { w: Y in C, w in Y }

Theorem 1: [distrib. dell’intersezione sull’unione]Un({ Y * X : X in C }) = (Y * Un(C)). Proof:Suppose_not(Y0,C0) ==> Stat0: AUTO

z-->Stat0 ==> AUTOUse_def(Un({ Y0 * X : X in C0 })) ==> AUTO

SIMPLF ==> Un({ Y0 * X : X in C0 })= { w: X in C0, w in (Y0 * X) }

Use_def(Un(C0)) ==> AUTO

Suppose ==> (z notin (Y0 * Un(C0)))& Stat1: (z in { w: X in C0, w in (Y0 * X) })

(X0,w)-->Stat1 ==> (z in (Y0 * X0)) & (X0 in C0)& Stat3: (z notin { w: X in C0, w in X })

(X0,z)-->Stat3 ==> falseDischarge ==> (z in Y0)

& (z notin Un({Y0 * X : X in C0 }))& Stat4: (z in { w: X in C0, w in X })

(X1,w1)-->Stat4 ==> (z in X1) & (X1 in C0)& Stat5: (z notin { w: X in C0, w in (Y0 * X)})

(X1,z)-->Stat5 ==> falseDischarge ==> QED--END HERE

21

[ 18 settembre 2010 at 15:34 ]

5 Dimostrare in Ref

La prima riga è una novità: ogni scenario completo inizia conla riga

--BEGIN HERE

Questo comando fa partire il verificatore. Un’istruzione simileper fermarlo compare alla fine

--END HERE

L’istruzione per metterlo in stand-by sarebbe

--PAUSE HERE

ma non ne avevamo bisogno in uno scenario così corto.Le righe seguenti, come abbiamo già visto, sono la definizione

di unione e l’enunciato del teorema. Un’altra novità comparedopo la Suppose_not: prima della parola AUTO figura un’etichet-ta. Un’etichetta battezza un passo della dimostrazione con unnome, nome che si potrà usare per sostituire variabili all’internodel passo stesso. Infatti, nella riga successiva, introduciamo unelemento z nello Stat0, con

z --> Stat0 ==> AUTO

Lo Stat0 negava la tesi, cioè diceva che i due insiemi erano diversi.Inserire un elemento z in questo Stat significa trovare un z chedifferenzia i due insiemi.

Un uso più avanzato delle etichette è la restrizione del conte-sto in cui operano le regole d’inferenza. Ad esempio, quandooperiamo con una ELEM (inferenza insiemistica elementare), l’i-struzione tenta di derivare la conclusione voluta prendendo aipotesi tutti i passaggi precedentemente dimostrati. Con un’op-portuna restrizione del contesto suggeriamo alla ELEM le ipotesispecifiche che le servono. È facile dare questo tipi di suggeri-menti: basta scrivere (Statx), dove Statx è lo statment che indical’ipotesi cercata. Così facendo acceleriamo parecchio la verifica,ma lo sforzo vale la fatica solamente se lo scenario è di una cer-ta consistenza: per questo motivo non abbiamo incluso questatecnica in questa dimostrazione.

L’istruzione Use_def che troviamo subito sotto espande la defi-nizione di unione. L’espansione delle definizioni è necessaria perdire al verificatore come sono fatti gli oggetti che stiamo usando:per dire che un elemento sta nell’unionset bisogna prima saperecom’è fatto l’unionset.

Ref non può indovinare il simbolo da espandere tra l’enormenumero di possibilità disponibili, ma con dati sufficienti puòespandere la definizione di un simbolo dato senza doverla riscri-verla esplicitamente. Questo è il senso della parola chiave AUTO:diamo un simbolo e dei parametri su cui lavora il simbolo a unaUse_def e Ref espande per noi la definizione

22

[ 18 settembre 2010 at 15:34 ]

Da qui in poi la dimostrazione formale ricalcalca quella stan-dard. La prima Suppose tratta il caso “ �⊆” : a destra della frecciaabbiamo la nostra ipotesi con le definizione espanse.

Riprendiamo in mano le sostituzioni, vedremo come le gestisceRef. Quando affermiamo un’appartenenza come

Stat1: z in { w: X in C0, w in (Y0 * X) }

Ref traduce l’espressione in una formula con quantificatoreesistenziale:

Stat1: (EXISTS X,w|(z=w) & (X in C0) & (w in (Y0 * X)))

Ora il senso di

(X0,w) -->Stat1 ==> (z in (Y0 * X0)) & (X0 in C0)

dovrebbe essere chiaro: al posto della variabili quantificate creia-mo due costanti (X0, w) che hanno le proprietà a destra dellabarra, i.e. z = w ∧ X0 ∈ C0 ∧ w ∈ Y0 ∩ X0. Eseguendo un ra-gionamento basato sulla teoria degli insiemi, come se avessimorichiamato una ELEM, otteniamo la conclusione a destra dellafreccia, i.e. z ∈ Y0 ∩ X0 ∧ X0 ∈ C

La seconda sostituzione è essenzialmente diversa. Quandoaffermiamo la non-appartenenza

Stat3: (z notin { w: X in C0, w in X })

Ref traduce l’espressione in una formula con quantificatoreuniversale:

(FORALL X,w | (z /= w) or (X notin C0) or (w notin X))

La sostituzione

(X0,z) --> Stat3 ==> false

dunque non crea dei nuovi nomi di costante come sopra, ma inse-risce quelli già esistenti nella formula a destra della barra. Il falsedopo la freccia indica che siamo arrivati a una contraddizione.

La seconda parte della dimostrazione è analoga, tranne perun’unica cosa ancora da notare: Ref non può riutilizzare i nomidelle costanti definite in sottodimostrazioni. Dunque non pos-siamo più usare X0 e w come nomi, ma dobbiamo inventarne dinuovi, X1 e w1.

A conclusione del capitolo riportiamo la descrizione delleultime istruzioni più importanti.

In particolare la ELEM è di fondamentale importanza: esegueragionamenti insiemistici elementari e viene automaticamenterichiamata dopo ogni istruzione. Per questo motivo non comparenella nostra dimostrazione: viene tacitamente adoperata dopo lesostituzioni.

23

[ 18 settembre 2010 at 15:34 ]

5 Dimostrare in Ref

THEORY e ENTER_THEORY sono le direttive per creare edaccedere alle teorie. Senza creare inutili teorie giocattolo qui, lespiegheremo più avanti quando parleremo di algebre booleane edel teorema di Stone.

• ELEM : dimostrazione usando ragionamenti elementari su-gli insiemi

• EQUAL : dimostrazione usando sostituzioni di uguali-per-uguali

• (e1, . . . , en) → Statn: introduce espressioni e/o costanti nel-l’etichetta Statn

• (e1, . . . , en) → Ttheorem: introduce espressioni e/o costantinel teorema theorem

• Use_def(symbol): espande la definizione di un simbolo

• Loc_def symbolName(params): simile a Use_def, ma la defi-nizione dura soltanto una dimostrazione

• THEORY theoryName : introduce una nuova teoria, pre-sentando i nuovi simboli di funzione e i nuovi simboli dicostante assunti dalla teoria e gli eventuali presupposti chegli argomenti della teoria devono soddisfare

• ENTER_THEORY theoryName : definisce l’inizio del con-testo di una teoria, dove vengono date le definizioni e ledimostrazioni interne alla teoria stessa

• APPLY : deriva delle conclusioni da teoremi precentementeprovati in una teoria. Svolge anche compiti di meccanismodefinitorio di alto livello

24

[ 18 settembre 2010 at 15:34 ]

6V E R S O I L T E O R E M A D I S T O N E . . .

Lo scopo del mio lavoro era trovare un modo per unire i risultatiprecedenti sulle algebre booleane ai risultati elementari di topolo-gia, in vista della dimostrazione del teorema di Stone. Il teoremadi Stone dice

Teorema 2: Ogni algebra booleana B è isomorfa all’algebra dei sot-toinsiemi chiusaperti del suo spazio di Stone S(B). Per ogni alge-bra booleana B il suo spazio di Stone S(B) è uno spazio di Hausdorffcompatto e totalmente sconnesso.

Il teorema di Stone si può dividere in due grosse parti: la primadice che ogni algebra booleana è isomorfa ad un campo d’insiemi,la seconda che questo campo d’insiemi è un particolare spaziotopologico. Un preesistente scenario conteneva già la dimostra-zione della prima parte ma mancava della seconda. Occorrevasviluppare una teoria degli spazi topologici che contenesse glienunciati utili per il nostro scopo. Ma la topologia è vasta, svi-luppare la teoria nella sua interezza sarebbe lungo e senza scopo:cosa ci serve per la dimostrazione formale del teorema di Stone?

Per capirlo dobbiamo fare tre cose:

• capire cosa abbiamo già in mano, i.e. vedere la teoria dellealgebre booleane in Ref

• studiare la dimostrazione classica e vedere dove entra ingioco la topologia

• implementare in Ref la parte topologica

Prima di iniziare però, riportiamo velocemente qualche defini-zione sulle algebre booleane, sugli spazi topologici e sugli spazidi Stone. Il lettore che le ricorda può tranquillamente saltarle.

Definizione 1: Un’algebra booleana è un reticolo completo distribu-tivo con unità. Un reticolo è una coppia (L,≤) in cui L è un insieme,≤ è un ordinamento parziale su L e per ogni coppia x, y ∈ L esistonoil sup, denotato con x ∨ y, e l’inf, denotato con x ∧ y. Completo si-gnifica che ogni sottoinsieme di L limitato superiormente deve avere ilsup. Distribuitivo significa che per ogni x, y, z ∈ L vale

x ∧ (y ∨ z) = (x ∧ y) ∨ (x ∧ z)

Avere un’unità 1 significa che 1 ∈ L e per ogni x ∈ L vale x ≤ 1

Definizione 2: Lo spazio di Stone S(B) di un’algebra booleana B èdefinito come l’insieme degli omomorfismi da B in 2, dove 2 è l’algebrabooleana con due elementi. Definiamo ora la base per la topologia delteorema di Stone: sia x ∈ B consideriamo l’insieme Sx(B) degli omo-morfismi che mandano x in 1 ∈ 2. La collezione {Sx(B) : x ∈ B} è lanostra base. Infine uno spazio topologico è di Hausdorff quando ogni

25

[ 18 settembre 2010 at 15:34 ]

6 Verso il teorema di Stone...

sua coppia di punti può esser separata da intorni disgiunti. Uno spaziotopologico è connesso quando ha sconnessioni. Una sconnessione è unacoppia di aperti disgiunti e non vuoti che uniti insieme danno tutto lospazio. Uno spazio topologico è totalmente sconnesso quando le unichecomponenti connesse sono i singoletti e l’insieme vuoto. Uno spaziotopologico è compatto quando da ogni suo ricoprimento aperto si puòestrarre un sottoricoprimento finito.

26

[ 18 settembre 2010 at 15:34 ]

7A L G E B R E B O O L E A N E I N REF

Siamo al primo passo del nostro piano di battaglia: capire lateoria già sviluppata in Ref. Nel farlo spiegheremo velocementecome funzionano le teorie. Riportiamo il codice per la teoria dellealgebre booleane.

Theory booleanAlgebra�bb, U · V, U + V + ee

�

-- assunzioni di non vacuità

ee ∈ bbee �= ee, ee

-- proprietà di chiusura

�∀x, y | {x, y} ⊆ bb → x · y ∈ bb��∀x, y | {x, y} ⊆ bb → x + y ∈ bb�

-- leggi associative

�∀x, y, z | {x, y, z} ⊆ bb → x · (y · z) = (x · y) · z��∀x, y, z | {x, y, z} ⊆ bb → x + (y + z) = (x + y) + z�

-- leggi distributive

�∀x, y, z | {x, y, z} ⊆ bb → (x + y) · z = (z · y) + (z · x)�

-- zero additivo

�∀x, y | {x, y} ⊆ bb → (x + x) = (y + y)�

-- legge di auto-eliminazione

�∀x, y | {x, y} ⊆ bb → x + (y + x) = y�

-- idempotenza della moltiplicazione

�∀x | x ∈ bb → x · x = x�

-- unità moltiplicativa

⇒ (cmpΘ, IdealΘ, BooHomΘ, hhΘ, phiΘ)

[. . . ]

�∀x, y | x, y ∈ bb → phiΘ�x · y = phiΘ�x ∩ phiΘ�y & phiΘ�(x + y) = phiΘ�x�phiΘ�y�phiΘ�ee =

�range(phiΘ) & phiΘ�zzΘ = ∅ & phiΘ�ee �= phiΘ�zzΘ

�∀x | x ∈ bb → phiΘ�cmpΘ(x) = phiΘ�ee\phiΘ�x�One_1_map(phiΘ) & domain(phiΘ) = bbBooHomΘ(phiΘ)

End booleanAlgebra

Le teorie sono dei meccanismi designati per agevolare lo svi-luppo di dimostrazioni su larga scala, cioè proprio quello che ci

27

[ 18 settembre 2010 at 15:34 ]

7 Algebre booleane in Ref

serve per sviluppare il nostro scenario. Una teoria si dichiara conla parola chiave THEORY a cui seguono il nome e i parametrisu cui si basa la teoria stessa. I parametri in questo caso sono ilsupporto (bb), le due operazioni (· e +) e l’unità moltiplicativa(ee). L’unità additiva invece è implicita poiché viene ricavata dalleassunzioni della teoria. Le assunzioni sono le righe che seguonola dichiarazione della teoria fino alla freccia ⇒ e corrispondonoagli assiomi delle algebre booleane.

Enunciata una teoria con i suoi parametri e scritti gli assiomiotteniamo i simboli specifici della teoria (cmpΘ, IdealΘ, BooHomΘ,hhΘ, phiΘ), contraddistinti con un Θ, e una serie di teoremiverificati da tutti gli oggetti istanziati da tale teoria.

I simboli specifici di una teoria devono essere dimostrati dentroil contesto della teoria. Stessa sorte per i teoremi di una teoria.Per entrare nel contesto di una teoria possiamo usare la paro-la chiave ENTER_THEORY (si veda il capitolo 5 per la sintassidell’istruzione): i simboli e i teoremi qui definiti saranno visibilisolamente all’interno di tale ambito. Entrati in un contesto, abbia-mo a disposizione anche tutti gli assunti di una teoria. Gli assuntipossono essere usati come ipotesi aggiuntive richiamandoli conl’istruzione Assump.

Abbiamo abbreviato la lista (lunghissima) dei teoremi sullealgebre booleane per evidenziare unicamente quelli importantiper il teorema di Stone.

Il primo dice che l’immagine di ogni prodotto è intersezionedelle immagini dei fattori e che l’immagine della somma booleanaè la differenza simmetrica delle immagini degli addendi. Sono leproprietà esplicitate caratteristiche di un omomorfismo: servonoper mettere in luce che il codominio sia un campo d’insiemi.

Il secondo dice che l’unità moltiplicativa ee dell’algebra corri-sponde al massimo insieme nel codominio dell’omorfismo e chel’unità additiva zzΘ corrisponde all’insieme vuoto.

Il terzo dice l’operazione di complemento booleano corrispon-de alla complementazione insiemistica.

Il quarto dice che phiΘ è iniettiva e il quindi che phi è unomomorfismo booleano.

Questi quattro teoremi uniti assieme implicano il teorema diStone in cui campo d’insiemi è l’immagine dell’omomorfismophiΘ.

Non ci dilungheremo a commentare altri risultati della teoria,in quanto per usarla ci basta conoscere i suoi assiomi e le sueproprietà. Questo infatti è un altro vantaggio delle teorie: crearescatole chiuse che possono essere usate senza conoscerne il conte-nuto. Il lettore interessato potrà consultare lo scenario completoin appendice.

Una cosa interessante da notare, anche se non è stata esplicita-mente scritta, è il lemma di Zorn. La dimostrazione del teoremail lemma di Zorndi Stone richiede la proprietà d’esistenza di un ideale massimale,teorema che richiede il lemma di Zorn. Ciò è ovviamente statodimostrato nella parte della teoria delle algebre booleane masarebbe prolisso ora mostrarne tutte le dipendenze (da notare inparticolare l’uso dell’induzione transfinita). Si possono trovare i

28

[ 18 settembre 2010 at 15:34 ]

dettagli in appendice e nel libro di Schwartz (Dunford e Schwartz[1958])

Il lemma di Zorn in Ref è enunciato così

Theorem 412: [Zorn’s lemma]�∀x ⊆ T | �∀u ∈ x, v ∈ x | u ⊇ v ∨ v ⊇ u�→ �∃w ∈ T, ∀y ∈ x | w ⊇ y��→ �∃y ∈ T, ∀x ∈ T |¬(x ⊇ y & x �= y)�.

L’uso di questo lemma, equivalente all’assioma della scelta,rende la dimostrazione non costruttiva.

29

[ 18 settembre 2010 at 15:34 ]

8L A D I M O S T R A Z I O N E C L A S S I C A D E LT E O R E M A D I S T O N E

Siamo al secondo passo del nostro piano di battaglia: capire ladimostrazione del teorema di Stone. Per la dimostrazione delteorema ci ispiriamo al testo di Schwartz (Dunford e Schwartz[1958]) che riportiamo brevemente

Dimostrazione della parte topologica. [. . . ] Ci rimane da mostra-re che S(B) può essere topologizzato in maniera che gli insie-mi Sx(B) al variare di x ∈ B siano esattamente i sottoinsiemichiusaperti di S(B). ecco cosa ci serve

↓Prendiamo un omomorfismo h ∈ S(B): per le proprietà dell’al-gebra booleana 2 abbiamo che h(xy) = 1 se e solo se h(x) = 1e h(y) = 1. Da questo, usando la definizione di Sxy(B) ottenia-mo la proprietà Sxy(B) = Sx(B) ∩ Sy(B). Inoltre per definizionedi omomorfismo è facile verificare che vale anche la proprietàS1(B) = S(B). Queste due proprietà messe insieme permettonofacilmente di verificare la definizione di base per la collezione{Sx(B) : x ∈ B}.

Mostriamo che ogni insieme della base è un chiusaperto: daciò segue che S(B) è totalmente sconnesso. Dato che ogni tale totale sconnessioneinsieme è aperto per definizione basta mostrare che è anchechiuso, i.e. che è il complementare di un aperto. Questo segueda S(B)− Sx(B) = Sx+1(B), visto che un omomorfismo h fa 1 sux se e solo se fa 0 su x + 1. Dunque S(B) è totalmente sconnesso.

Mostriamo che S(B) è compatto: per farlo useremo la caratte-rizzazione con la proprietà delle intersezioni finite (vedi Munkres[2000], p.169). Dato che ogni chiuso in S(B) è intersezione di caratterizzazione

della compattezzainsiemi in {Sx(B) : x ∈ B} è sufficiente mostrare che:se A1 ⊆ B tale che per ogni {x1, . . . , xn} ⊆ B valga

�ni=1 Sxi(B) �=

∅ allora deve valere�

x∈A1 Sx(B) �= ∅. Per un lemma precedente1

esiste h1 ∈ S(B) con h1(x) = 1, x ∈ A1 tale che h1 appartiene aogni Sx(B), x ∈ A1. Dunque S(B) è compatto.

Mostriamo che ogni G ⊆ S(B) chiusaperto è della forma Sx(B)per qualche x ∈ B. Dato che G è aperto è unione arbitraria dielementi della base. Dato che G è anche chiuso in uno spaziocompatto, G è compatto e dunque basta un numero finito dielementi della base. Abbiamo ottenuto G = Sx1(B) ∪ . . . ∪ Sxn(B)Ora basta dimostrare che ogni unione binaria di elementi dellabase può esser scritta come un unico elemento della base. Perquesto ci serve la seguente proprietà di S(B): denotato il comple-mentare in S(B) con una barra verticale, vale Sx(B) = Sx+1(B).Grazie alle leggi di De Morgan vale leggi di De Morgan

1 Più che un lemma era un’affermazione presente nella prima parte della dimo-strazione. Si può trovare nel libro di Schwart a pagina 42. L’affermazione dice:se B1 ⊆ B tale che 0 /∈ B1 e x, y ∈ B1 ⇒ xy ∈ B1 allora esiste un omomorfismoh1 : B → 2 tale che ∀x ∈ B1 . h1(x) = 1

31

[ 18 settembre 2010 at 15:34 ]

8 La dimostrazione classica del teorema di Stone

Sx(B) ∪ Sy(B) = Sx(B) ∩ Sy(B)

= Sx+1(B) ∩ Sy+1(B)

= S(x+1)(y+1)(B)= S(x+1)(y+1)+1(B)

da cui segue che G è della forma Sx(B) per qualche x ∈ B.

Nei graffiti a lato notiamo i prerequisiti del teorema di Stone:l’uso dei concetti di totale sconnessione, e di una teoria suglispazi topologici in generale, il teorema sulla caratterizzazionedella compattezza e le leggi di De Morgan.

Per iniziare ho caratterizzato la compattezza. Non è statosemplicissimo, mi ha impegnato parecchi giorni ed è emersauna forte dipendenza dalle leggi di De Morgan. Le leggi diDe Morgan sono state implementate strada facendo. Per motividi tempo non sono riuscito a gestire la parte sulla connessione,che ultimerebbe la parte topologica verso il teorema di Stone.Vediamo come ho proceduto.

32

[ 18 settembre 2010 at 15:34 ]

9L A PA RT E T O P O L O G I C A :CARATTERIZZIAMO LA COMPATTEZZA

Tradizionalmente uno spazio topologico X si dice compatto seda ogni suo ricoprimento aperto si riesce ad estrarre un sottori-coprimento finito. Nella dimostrazione di Stone si usa però unacaratterizzazione sulle intersezioni. Riprendiamo un attimo ledefinizioni dal Munkres (Munkres [2000])

Definizione 3: Una collezione C di sottoinsiemi di X è detta averela proprietà delle intersezioni finite (fip dall’inglese Finite Intersec-tion Property) sse per ogni sottocollezione finita {C1, . . . , Cn} di Cl’intersezione C1 ∩ . . . ∩ Cn è non vuota.

Questa definizione porta al seguente teorema

Teorema 3: Sia X una spazio topologico. Allora X è compatto see solo se per ogni collezione C di chiusi in X che hanno la fip vale�

C∈C C �= ∅ fip

Dimostrazione. Data una collezione A di sottoinsiemi di X defi-niamo C = {X− A : A ∈ A}.

Valgono le seguenti affermazioni

• A è una collezione di aperti se e solo se C è una collezionedi chiusi

• la sottocollezione {Ai} di A ricopre A se e solo se l’interse-zione dei corrispettivi elementi Ci = X− Ai è vuota

leggi di De MorganLa prima affermazione segue dalle definizioni, la seconda dallalegge di De Morgan: X− (

�α∈J Aα) =

�α∈J(X− Aα).

Prendendo il contrapositivo della definizione di compattezzaabbiamo: ”X è compatto sse data A collezione di aperti, senessuna sua sottocollezione finita ricopre X allora neanche Aricopre X.

Usando le due affermazioni su quest’ultimo enunciato ottenia-mo la tesi.

Come notiamo immediatamente abbiamo bisogno di un predi-cato che definisca la fip e della definizione di ricoprimento. InRef si traduce così

Def : [Ricoprimento] Covers(C, X) ↔Def

�C = X

Def : [Proprietà intersezioni finite]HasFip(C) ↔Def {D ⊆ C | Finite(D) & D �= ∅ & inters(D) = ∅} = ∅

È interessante notare come abbiamo definito la fip: Ref èbasato sulla teoria degli insiemi per cui gestisce con naturalezzale sostituizioni nei set-former. Riscrivendo la fip come insieme

33

[ 18 settembre 2010 at 15:34 ]

9 La parte topologica: caratterizziamo la compattezza

vuoto aiuteremo il dimostratore quando farà delle sostituzioni divariabili alla ricerca di una contraddizione.

def. tradizionale: ∀D. D ⊆ C finita ⇒ �D �= ∅↓

doppia negazione: ¬(∃D. D ⊆ C ∧D finita∧�D = ∅)↓

def. per insiemi: { D ⊆ C|D finita∧�D = ∅ } = ∅

La definizione di compattezza ricalca invece quella classica

Def : [compattezza] IsCompactΘ(supportΘ) ↔Def

�∀u ⊆ open | Covers(u, supportΘ) → �∃d ⊆ u | Finite(d) & Covers(d, supportΘ)��

Anche un predicato può far parte di una teoria: infatti ilpredicato IsCompactΘ possiede un curioso pedice Θ.

Riportiamo la dimostrazione formale

Theorem topologicalSpace20: [caratterizz. della compattezza]IsCompactΘ(supportΘ)

↔�∀c ⊆ closedΘ | c �= ∅ & HasFip(c) → inters(c) �= ∅�. Proof:Suppose_not ⇒ Auto

Suppose ⇒ IsCompactΘ(supportΘ) &Stat0 : ¬�∀c ⊆ closedΘ | c �= ∅ & HasFip(c) → inters(c) �= ∅�

�c0��→Stat0 ⇒ c0 ⊆ closedΘ & c0 �= ∅ & HasFip(c0) & inters(c0) = ∅Use_def(HasFip) ⇒ Stat1 : {x ⊆ c0 | Finite(x) & x �= ∅ & inters(x) = ∅} = ∅

Use_def(IsCompactΘ) ⇒ Stat2 : �∀u ⊆ open |Covers(u, supportΘ) →�∃d ⊆ u | Finite(d) & Covers(d, supportΘ)��

Loc_def ⇒ Stat22 : u0 = {supportΘ\k : k ∈ c0}

-- c0 = ∅

Suppose ⇒ u0 = ∅�z0��→Stat22 ⇒ false; Discharge ⇒ u0 �= ∅

�c0��→TtopologicalSpace13 ⇒ u0 ⊆ open�u0��→Stat2 ⇒ Covers(u0, supportΘ)→�∃d ⊆ u0 |Finite(d) & Covers(d, supportΘ)�

�c0��→TtopologicalSpace14 ⇒ Covers({supportΘ\k : k ∈ c0} , supportΘ)EQUAL ⇒ Covers(u0, supportΘ)ELEM ⇒ Stat3 : �∃d ⊆ u0 | Finite(d) & Covers(d, supportΘ)�

�d0��→Stat3 ⇒ d0 ⊆ u0 & Finite(d0) & Covers(d0, supportΘ)�d0��→TtopologicalSpace16 ⇒ inters({supportΘ\k : k ∈ d0}) = ∅�d0��→TtopologicalSpace15 ⇒ d0 �= ∅

Loc_def ⇒ Stat4 : k0 = {supportΘ\k : k ∈ d0}EQUAL ⇒ inters(k0) = ∅

Suppose ⇒ k0 = ∅

34

[ 18 settembre 2010 at 15:34 ]

�b0��→Stat4 ⇒ false; Discharge ⇒ k0 �= ∅

-- d0 ⊆ u0 ed u0 ⊆ open

�d0��→TtopologicalSpace11 ⇒ �∀w ∈ d0 | w ⊆ supportΘ��d0��→TtopologicalSpace18 ⇒ Finite({supportΘ\k : k ∈ d0})EQUAL ⇒ Finite(k0)

�d0, u0��→TtopologicalSpace19 ⇒ {supportΘ\k : k ∈ d0} ⊆ {supportΘ\k : k ∈ u0}EQUAL ⇒ k0 ⊆ {supportΘ\k : k ∈ u0}EQUAL ⇒ k0 ⊆ {supportΘ\k : k ∈ {supportΘ\k : k ∈ c0}}SIMPLF ⇒ k0 ⊆ {supportΘ\(supportΘ\k) : k ∈ c0}

-- c0 ⊆ closedΘ

�c0��→TtopologicalSpace11 ⇒ �∀w ∈ c0 | w ⊆ supportΘ��c0��→TtopologicalSpace17 ⇒ k0 ⊆ c0

�k0��→Stat1 ⇒ false;

Discharge ⇒ ¬IsCompactΘ(supportΘ) &Stat5 : �∀c ⊆ closedΘ | c �= ∅ & HasFip(c) → inters(c) �= ∅�

Use_def(IsCompactΘ) ⇒Stat6 : ¬�∀u ⊆ open | Covers(u, supportΘ) → �∃d ⊆ u | Finite(d) & Covers(d, supportΘ)��

�u1��→Stat6 ⇒u1 ⊆ open & Covers(u1, supportΘ) & ¬�∃d ⊆ u1 | Finite(d) & Covers(d, supportΘ)�

Loc_def ⇒ Stat7 : c1 = {supportΘ\k : k ∈ u1}�u1��→TtopologicalSpace12 ⇒ {supportΘ\k : k ∈ u1} ⊆ closedΘEQUAL ⇒ c1 ⊆ closedΘ

�u1��→TtopologicalSpace15 ⇒ u1 �= ∅Suppose ⇒ c1 = ∅�b1��→Stat7 ⇒ false; Discharge ⇒ c1 �= ∅

�c1��→Stat5 ⇒ HasFip(c1)→ inters(c1) �= ∅ELEM ⇒ inters(c1) = ∅→¬HasFip(c1)�u1��→TtopologicalSpace16 ⇒ inters({supportΘ\k : k ∈ u1}) = ∅EQUAL ⇒ ¬HasFip(c1)

Use_def(HasFip) ⇒ Stat8 : {x ⊆ c1 | Finite(x) & x �= ∅ & inters(x) = ∅} �= ∅ELEM ⇒ Stat9 : ¬�∃d ⊆ u1 |Finite(d) & Covers(d, supportΘ)��x1��→Stat8 ⇒ x1 ⊆ c1 & Finite(x1) & x1 �= ∅ & inters(x1) = ∅

Loc_def ⇒ Stat10 : d1 = {supportΘ\k : k ∈ x1}

ELEM ⇒ x1 ⊆ c1�x1, c1��→TtopologicalSpace19 ⇒ {supportΘ\k : k ∈ x1} ⊆ {supportΘ\k : k ∈ c1}EQUAL ⇒ d1 ⊆ {supportΘ\k : k ∈ {supportΘ\k : k ∈ u1}}SIMPLF ⇒ {supportΘ\k : k ∈ {supportΘ\k : k ∈ u1}} = {supportΘ\(supportΘ\k) : k ∈ u1}

-- u1 ⊆ open

�u1��→TtopologicalSpace11 ⇒ �∀w ∈ u1 | w ⊆ supportΘ��u1��→TtopologicalSpace17 ⇒ {supportΘ\k : k ∈ {supportΘ\k : k ∈ u1}} = u1

35

[ 18 settembre 2010 at 15:34 ]

9 La parte topologica: caratterizziamo la compattezza

EQUAL ⇒ d1 ⊆ u1

-- c1 ⊆ closedΘ x1 ⊆ c1

�x1��→TtopologicalSpace11 ⇒ �∀w ∈ x1 | w ⊆ supportΘ��x1��→TtopologicalSpace18 ⇒ Finite({supportΘ\k : k ∈ x1})EQUAL ⇒ Finite(d1)

�x1��→TtopologicalSpace14 ⇒ Covers({supportΘ\k : k ∈ x1} , supportΘ)EQUAL ⇒ Covers(d1, supportΘ)

�d1��→Stat9 ⇒ false;

Discharge ⇒ Qed

La dimostrazione formale a differenza di quella classica dividel’implicazione in due parti. Questa scelta è dovuta a leggereasimmetrie.

Ad esempio una collezione vuota U non può ricoprire il sup-porto (teorema topologicalSpace15) ma cosa si può dire dell’inter-sezione di una collezione vuota C?il problema di

�∅

Nella dimostrazione vista sopra la collezione C era formataprendendo i complementari degli insiemi di U , dunque se U eravuota anche C lo era. Ma mentre l’unionset di una collezionevuota è facile da definire (se andiamo a vedere la definizione diUn data in precedenza si vede che è vuoto), l’intersezione è piùproblematica.

Nella topologia generale l’intersezione vuota viene posta perdefinizione uguale al supporto. Questo prevede che ci sia un in-sieme “grande” dal quale partire, una specie di insieme universo.Un insieme universo funziona bene in un ambito ristretto qualela topologia, ma Ref si occupa di tutta la teoria degli insiemi enella teoria degli insiemi un insieme universo è un problema.

Il problema nasce dal paradosso del barbiere, enunciato daRussel nel 1918. Sia U l’insieme universo e R = {X ∈ U : X �∈ X},vale R ∈ R? In un linguaggio più pittoresco ci si chiede: ”In unvillaggio c’è un unico barbiere. Il barbiere rade tutti (e solo) gliuomini che non si radono da sé. Chi rade il barbiere?” Questafrase porta inevitabilmente a una contraddizione che escludel’esistenza dell’insieme universo.

Per la nostra dimostrazione è un problema. Vediamo comepossiamo risolverlo. L’intersezione arbitraria l’abbiamo definitacosì, non essendo un operatore built-in di Ref

Def : [Intersezione unaria]inters(C) ↔Def

�z ∈ arb(C) | �∀y ∈ C | z ∈ y�

�

Con questa definizione l’intersezione di una collezione vuotaè vuota. Infatti arb è una funzione predefinita che sceglie unelemento di un insieme, ma se l’insieme di partenza è vuototorna vuoto. Partendo da una C = ∅ otteniamo che non ci sonoz ∈ arb(C) e anche l’intersezione risulta vuota. Ora, se entrambeU e C sono vuote, la prima non ricopre X ma la seconda ha

36

[ 18 settembre 2010 at 15:34 ]

9.1 Le leggi di De Morgan

intersezione vuota. Ma questo va contro la prima affermazionedella dimostrazione del teorema della compattezza!

Come possiamo dimostrare l’enunciato formalmente allora?Gestendo con dei condizionali il caso dell’intersezione vuota. Iltutto si traduce nell’aggiungere una serie di ipotesi nel lemmiprecedenti e in un condizionale if. . .then. . .else nelle leggi di DeMorgan.

Per la parte restante la dimostrazione ricalca quella standard,solamente è specificato ogni dettaglio. Per questioni di stileho diviso la dimostrazione in blocchi: l’ultima riga mostra laconclusione a cui si voleva arrivare, di solito per citare un lemmao un teorema.

9.1 le leggi di de morgan

La caratterizzazione della compattezza che abbiamo visto usainevitabilmente la seconda legge di De Morgan. Ci si potrebbestupire che Ref non includa dei teoremi così basilari, ma pen-sandoci un attimo ci si rende conto che non è poi così stranodato che non erano definite nemmeno le unioni e le intersezioniarbitrarie d’insiemi.

La maggior difficoltà con le leggi di De Morgan è gestire l’in-tersezione vuota. Abbiamo già parlato del problema quindi cilimiteremo a riportare la dimostrazione formale. Come si vedeabbiamo usato un condizionale if. . . then. . . else.

Theorem 23a: [seconda legge di De Morgan]X\�

Y = if Y = ∅ then X else�

({X\z : z ∈ Y}) fi. Proof:Suppose_not(x0, y0) ⇒ Auto

-- Ragionando per assurdo, cominciamo semplificandoil lato destro della disuguaglianza e con l’escludere lapossibilità che il controesempio x0, y0 possa avere y0 = ∅.Da ciò segue subito che {x0\z : z ∈ y0} �= ∅.

�y0��→T3 f ⇒ y0 �= ∅ & Stat1 : x0\�

y0 �=�

({x0\z : z ∈ y0})Suppose ⇒ Stat2 : {x0\z : z ∈ y0} = ∅�arb(y0) ��→Stat2 ⇒ false; Discharge ⇒ Auto

-- Richiamando la prima legge di De Morgan, troviamoche x0 ∩

�({x0\z : z ∈ y0}) = x0\

� {x0 ∩ z : z ∈ y0}.

�x0, {x0\z : z ∈ y0} ��→T23 ⇒ x0 ∩�

({x0\z : z ∈ y0}) =x0\

� {x0\z : z ∈ {x0\z : z ∈ y0}}SIMPLF ⇒ {x0\z : z ∈ {x0\z : z ∈ y0}} = {x0\(x0\z) : z ∈ y0}Suppose ⇒ Stat3 : {x0\(x0\z) : z ∈ y0} �= {x0 ∩ z : z ∈ y0}�c0��→Stat3(Stat3�) ⇒ false;Discharge ⇒ {x0\(x0\z) : z ∈ y0} = {x0 ∩ z : z ∈ y0}�x0, y0��→T3h ⇒ x0\

� {x0 ∩ z : z ∈ y0} = x0\�

y0EQUAL ⇒ x0 ∩

�({x0\z : z ∈ y0}) = x0\

�y0

-- Il lato sinistro di quest‘ultima uguaglianza si sempli-fica in inters ({x0-z: z in y0}), il che contraddice il passoStat1.

37

[ 18 settembre 2010 at 15:34 ]

9 La parte topologica: caratterizziamo la compattezza

Suppose ⇒ Stat4 :�

({x0\z : z ∈ y0}) �⊆ x0 ∩�

({x0\z : z ∈ y0})�c1��→Stat4(Stat4�) ⇒

Stat5 : c1 ∈�

({x0\z : z ∈ y0}) & c1 /∈ x0Use_def (

�) ⇒Stat6 : c1 ∈

�z ∈ arb({x0\z : z ∈ y0}) | �∀y ∈ {x0\z : z ∈ y0} | z ∈ y�

�

Loc_def ⇒ a = arb({x0\z : z ∈ y0})� ��→Stat6(Stat6) ⇒ Stat7 : a ∈ {x0\z : z ∈ y0} & c1 ∈ a�z0��→Stat7(Stat5, Stat7�) ⇒ false; Discharge ⇒ falseDischarge ⇒ Qed

La dimostrazione cita due teoremi: il 3f e il3h. I teoremi sonodelle leggi di distribitutività dell’unione arbitraria, prima rispettola differenza e poi rispetto all’intersezione.

Theorem 3 f : (Y ⊆ {∅} ↔ �Y = ∅) &

�Y ∈ Z → �

Z = Y ∪�

(Z\ {Y})�.

Theorem 3h:� {X ∩ z : z ∈ Y} = X ∩

�Y.

38

[ 18 settembre 2010 at 15:34 ]

10R I S U LTAT I F I N A L I E S V I L U P P I F U T U R I . . .

Siamo in conclusione del lavoro: cosa abbiamo ottenuto e cosaresta da fare? cosa abbiamo

ottenuto. . .L’obiettivo finale era creare uno scenario indipendente in Refche includesse un risultato non banale. Il risultato che abbiamoscelto è il teorema di rappresentazione di Stone. Questo teoremaha il pregio di essere un risultato non puramente insiemistico,cioè mostra come Ref possa essere usato in contesti al di fuoridalla teoria degli insiemi, ma allo stesso tempo non richiedegrandi prerequisiti, come la costruzione dei reali in un teoremad’analisi.

In questa ottica abbiamo ripreso in mano le teorie delle al-gebre booleane sviluppate precedentemente e abbiamo inizia-to a sviluppare il primo concetto topologico che ci serviva: lacompattezza.

In particolare, riprendendo la dimostrazione di Schwartz, èrisultato fondamentale darne una caratterizzazione alternativa.Questa caratterizzazione utilizza insiemi chiusi invece che apertiperché la base dello spazio Stone si comporta bene rispetto alleintersezioni, cioè vale Sxy(B) = Sx(B) ∩ Sy(B).

Per dimostrare questa caratterizzazioni abbiamo definito deglioperatori su unioni e intersezioni arbitrarie e quindi dimostratole leggi di De Morgan e di altri lemmi insiemistici. . . . cosa resta da fare

Cosa manca ora? Come accennato nel capitolo apposito bi-sogna integrare la teoria degli spazi topologici con i concetti diconnessione e di spazio di Hausdorff. L’integrazione dovrebbeessere fatta modellando i concetti di connessione e spazio diHausdorff su predicati come IsCompactΘ. Ottenuti questi duepredicati avremo bisogno di alcuni lemmi, come il fatto che unospazio di Hausdorff compatto con una base di chiusaperti siaautomaticamente totalmente sconnesso.

Dimostrati tutti i lemmi che ci servono e integrati nella teoriatopologicalSpace potremmo finalmente finire la dimostrazionedel teorema di Stone.

39

[ 18 settembre 2010 at 15:34 ]

B I B L I O G R A F I A

Dunford, N. e Schwartz, J. T. (1958), Linear Operators, Part IGeneral Theory, Interscience Publishers. (Citato alle pagine 29e 31.)

Euclide (2010), «Gli elementi di Euclide, Libro I», URLhttp://aleph0.clarku.edu/~djoyce/java/elements/bookI/propI1.html, online, controllata in settembre 2010. (Citato apagina 5.)

Geuvers, H. (2009), «Proof assistants: History, ideas and future»,Sadhana Journal, vol. 34. (Citato a pagina 12.)

Gonthier, G. (2008), «Formal Proof—The Four-Color Theorem»,Notices of the AMS, vol. 55 (11). (Citato a pagina 9.)

Hales, T. C. (2008), «Formal Proof», Notices of the AMS,vol. 55 (11). (Citato a pagina 15.)

Krantz, S. G. (2007), The Proof is in the Pudding. The ChangingNature of Mathematical Proof, Springer. (Citato a pagina 8.)

Munkres, J. (2000), Topology (2nd edition), Prentice Hall. (Citatoalle pagine 31 e 33.)

Omodeo, E. G., Cantone, D., Policriti, A. e Schwartz, J. T.(2006), «A Computerized Referee», in Stock, O. e Schaerf, M.,curatori, «Reasoning, Action and Interaction in AI Theoriesand Systems — Essays Dedicated to Luigia Carlucci Aiello»,vol. 4155, p. 117–139, Springer. (Citato a pagina 17.)

Stone, M. H. (1936), «The Theory of Representations of BooleanAlgebras», Transactions of the American Mathematical Society,(40), p. 37–111. (Citato a pagina 5.)

Whitehead, A. N. e Russell, B. (2009), Principia Matematica, vol.1–3, Merchant Books. (Citato a pagina 7.)

Wiedijk, F. (2007), «The QED Manifesto Revisisted», STUDIESIN LOGIC, GRAMMAR AND RHETORIC 10 (23). (Citato apagina 13.)

Wiedijk, F. (2010), «Formalizing 100 Theorems», URL http://www.cs.ru.nl/~freek/100/. (Citato a pagina 14.)

41

[ 18 settembre 2010 at 15:34 ]

Theorem 1a. S ⊇ X → PX ∪ {∅,X} ⊆ PS. Proof:Suppose not(s0, x0) ⇒ AutoSet monot ⇒ {x : x ⊆ x0} ⊆ {x : x ⊆ s0}Use def (P) ⇒ Stat1 : ∅ /∈ {x : x ⊆ s0} ∨ x0 /∈ {x : x ⊆ s0}�∅, x0��→Stat1 ⇒ false; Discharge ⇒ Qed

Theorem 1b. P∅= {∅} & P {X} = {∅, {X}} . Proof:Suppose not(x0) ⇒ AutoSuppose ⇒ P∅ �= {∅}�∅, ∅��→T1a ⇒ Stat0 : P∅ �⊆ {∅}�y0��→Stat0(Stat0�) ⇒ Stat1 : y0 ∈ P∅ & y0 /∈ {∅}�∅, y0��→T1 (Stat1�) ⇒ false; Discharge ⇒ P {x0} �= {∅, {x0}}� {x0} , {x0} ��→T1a ⇒ Stat2 : P {x0} �⊆ {∅, {x0}}�y1��→Stat2 ⇒ Stat3 : y1 ∈ P {x0} & y1 /∈ {∅, {x0}}� {x0} , y1��→T1 (Stat3�) ⇒ false; Discharge ⇒ Qed

Theorem 3a. Z = {X,Y}→�

Z = X ∪ Y &�

{Y} = Y. Proof:Suppose not(z0, x0, y0) ⇒ Auto

-- La seconda parte dell’enunciato di questo teorema discende direttamente dalla prima epotremmo posporne la dimostrazione; preferiamo invece trattare per primo questo casospeciale per illustrare una linea dimostrativa lievemente diversa e piu semplice.

Suppose ⇒�

{y0} �= y0

Use def (S

) ⇒ {z : y ∈ {y0} , z ∈ y} �= y0

SIMPLF ⇒ {z : z ∈ y0} �= y0

ELEM ⇒ false; Discharge ⇒ Stat0 : z0 = {x0, y0} &�

z0 �= x0 ∪ y0

-- Nell’altro caso, cioe sotto l’assurda ipotesi che z0 = {x0, y0} &�

z0 �= x0 ∪ y0, duecitazioni del Theorem 3 ci pemettono di ricavare da z0 = {x0, y0} che x0 ⊆

�z0 ed

y0 ⊆�

z0

�x0, z0��→T3 ⇒ Auto�y0, z0��→T3 ⇒ Auto

-- Una terza citazione dello stesso Theorem 3 ci permette di ricavare da�

z0 �= x0 ∪ y0 chequalche elemento di z0 = {x0, y0} non e incluso in x0 ∪ y0, il che e palesemente assurdo.

�x0 ∪ y0, z0��→T3 (Stat0�) ⇒ Stat1 : ¬�∀y ∈ z0 | y ⊆ x0 ∪ y0��v��→Stat1(Stat0,Stat0�) ⇒ v ∈ {x0, y0} & v �⊆ x0 ∪ y0

(Stat1�)Discharge ⇒ Qed

Theory imageOfDoubleton�f(X), x0, x1

�

End imageOfDoubleton

Enter theory imageOfDoubleton

-- the image of a doubleton is a doubleton or singletonTheorem imageOfDoubleton. {f(v) : v ∈ ∅} = ∅ & {f(v) : v ∈ {x0}} = {f} (x0) & {f(v) : v ∈ {x0, x1}} = {f(x0), f(x1)} . Proof:

Suppose not() ⇒ AutoSIMPLF ⇒ Stat1 : {f(v) : v ∈ {x0, x1}} �= {f(x0), f(x1)}�c��→Stat1(Stat1�) ⇒ c ∈ {f(v) : v ∈ {x0, x1}} �= c ∈ {f(x0), f(x1)}Suppose ⇒ Stat2 : c /∈ {f(v) : v ∈ {x0, x1}}�x0��→Stat2(Stat1�) ⇒ c = f(x1)�x1��→Stat2(Stat1�) ⇒ false; Discharge ⇒ Stat3 : c ∈ {f(v) : v ∈ {x0, x1}} & c /∈ {f(x0), f(x1)}�x���→Stat3 ⇒ x� ∈ {x0, x1} & f(x�) /∈ {f(x0), f(x1)}Suppose ⇒ x� = x0

EQUAL ⇒ f(x0) /∈ {f(x0), f(x1)}(Stat3�)Discharge ⇒ x� = x1

EQUAL ⇒ Stat4 : f(x1) /∈ {f(x0), f(x1)}(Stat4�)Discharge ⇒ Qed

Enter theory Set theory

-- unione di unioneTheorem 3b.

�(�

X) =�

{�

y : y ∈ X} . Proof:Suppose not(x0) ⇒ AutoUse def (

S) ⇒ {z : y ∈ {u : v ∈ x0, u ∈ v} , z ∈ y} �= {s : r ∈ {

�y : y ∈ x0} , s ∈ r}

SIMPLF ⇒ Stat1 : {z : v ∈ x0, u ∈ v, z ∈ u} �= {s : y ∈ x0, s ∈�

y}�z0��→Stat1 ⇒ Stat2 : z0 ∈ {z : v ∈ x0, u ∈ v, z ∈ u} �= z0 ∈ {s : y ∈ x0, s ∈

�y}

Suppose ⇒ Stat3 : z0 ∈ {z : v ∈ x0, u ∈ v, z ∈ u} & z0 /∈ {s : y ∈ x0, s ∈�

y}Use def (

Sv0) ⇒ Auto

�v0, u0, z, v0, z0��→Stat3(Stat2�) ⇒ Stat4 :z0 /∈ {z : u ∈ v0, z ∈ u} & v0 ∈ x0 & u0 ∈ v0 & z0 ∈ u0

�u0, z0��→Stat4(Stat4�) ⇒ false; Discharge ⇒ Stat5 : z0 ∈ {s : y ∈ x0, s ∈�

y}Use def (

Sy0) ⇒ Auto

�y0, s0��→Stat5(Stat5�) ⇒ Stat6 : z0 ∈ {s : u ∈ y0, s ∈ u} & y0 ∈ x0

�u1, s1��→Stat6(Stat5,Stat2�) ⇒ Stat7 : z0 /∈ {z : v ∈ x0, u ∈ v, z ∈ u} & z0 ∈ u1 & u1 ∈ y0

�y0, u1, z0��→Stat7(Stat6�) ⇒ false; Discharge ⇒ Qed

-- additivita e monotonicita dell’unione monadicaTheorem 3c.

�(X ∪ Y) =

�X ∪

�Y & (Y ⊇ X →

�Y ⊇

�X). Proof:

Suppose not(x0, y0) ⇒ AutoSuppose ⇒

�(x0 ∪ y0) �=

�x0 ∪

�y0

� {x0, y0} ��→T3b ⇒�

(�

{x0, y0}) =�

{�

v : v ∈ {x0, y0}}APPLY � � imageOfDoubleton

`f(X) �→

SX, x0 �→ x0, x1 �→ y0

´⇒

{�

v : v ∈ {x0, y0}} = {�

x0,�

y0}� {x0, y0} , x0, y0��→T3a ⇒

�{x0, y0} = x0 ∪ y0

� {Sx0,

Sy0} ,

Sx0,

Sy0��→T3a ⇒

�{�

x0,�

y0} =�

x0 ∪�

y0

EQUAL ⇒ false; Discharge ⇒�

(x0 ∪ y0) =�

x0 ∪�

y0 & y0 = x0 ∪ y0 &�

y0 �⊇�

x0

EQUAL ⇒�

y0 =�

x0 ∪�

y0

Discharge ⇒ Qed

-- Anche se puo apparire inutilmente contorto, l’enunciato del teorema che segue ha ilpregio della versatilita ; visto che, per semplice citazione, puo essere utilmente declinatoin almeno tre modi: �

(X ∪ {Y}) = Y ∪�

X ,

Y ∈ Z →�

Z = Y ∪�

(Z\ {Y}) ,

Z �= ∅ →�

Z = arb(Z) ∪�

(Z\ {arb(Z)}) .

-- unione di unione, 2Theorem 3d. Y ∈ Z & X ∈ {Z,Z\ {Y}}→

�Z = Y ∪

�X. Proof:

Suppose not(y0, z0, x0) ⇒ AutoELEM ⇒ z0 = x0 ∪ {y0}EQUAL ⇒

�(x0 ∪ {y0}) �= y0 ∪

�x0

�∅, ∅, y0��→T3a ⇒ Auto�x0, {y0} ��→T3c ⇒ false; Discharge ⇒ Qed

Theorem 3e.�

(X ∪ {Y}) = Y ∪�

X. Proof:Suppose not(x0, y0) ⇒ Auto�y0, x0 ∪ {y0} , x0��→T3d (�) ⇒ false; Discharge ⇒ Qed

Theorem 3f. (Y ⊆ {∅} ↔�

Y = ∅) &�Y ∈ Z →

�Z = Y ∪

�(Z\ {Y})

�. Proof:

Suppose not(x0, z0) ⇒ AutoSuppose ⇒ x0 ⊆ {∅} �=

�x0 = ∅

Use def (S

x0) ⇒ AutoSuppose ⇒ x0 ⊆ {∅}ELEM ⇒ Stat1 : {z : y ∈ x0, z ∈ y} �= ∅�y0, z1��→Stat1 ⇒ false; Discharge ⇒ Stat2 : x0 �⊆ {∅} & {z : y ∈ x0, z ∈ y} = ∅

�y1, y1,arb(y1) ��→Stat2 ⇒ false; Discharge ⇒ x0 ∈ z0 &�

z0 �= x0 ∪�

(z0\ {x0})�x0, z0, z0\ {x0} ��→T3d (�) ⇒ false; Discharge ⇒ Qed

Theorem 3g. Z �= ∅→�

Z = arb(Z) ∪�

(Z\ {arb(Z)}). Proof:Suppose not(z0) ⇒ Auto�arb(z0) , z0, z0\ {arb(z0)} ��→T3d ⇒ false; Discharge ⇒ Qed

Theory doubleUnion�f(X), x0

�

End doubleUnion

Enter theory doubleUnion

-- double union of a setformerTheorem doubleUnion.

���{f(w) : w ∈ x0}

�=

�{�

f(w) : w ∈ x0} . Proof:Suppose not() ⇒ Auto� {f(w) : w ∈ x0} ��→T3b ⇒

�{�

v : v ∈ {f(w) : w ∈ x0}} �=�

{�

f(w) : w ∈ x0}SIMPLF ⇒ false; Discharge ⇒ Qed

Enter theory Set theory

-- distributivita dell’intersezione sull’unioneTheorem 3h.

�{X ∩ z : z ∈ Y} = X ∩

�Y. Proof:

Suppose not(x0, y0) ⇒ Stat0 : Auto�c1��→Stat0 ⇒ c1 ∈

�{x0 ∩ z : z ∈ y0} �= c1 ∈ x0 ∩

�y0

Use def (S

{x0 ∩ z : z ∈ y0}) ⇒ AutoSIMPLF ⇒

�{x0 ∩ z : z ∈ y0} = {w : z ∈ y0,w ∈ x0 ∩ z}

Use def (S

y0) ⇒ AutoSuppose ⇒ Stat1 : c1 ∈ {w : z ∈ y0,w ∈ x0 ∩ z} & c1 /∈ x0 ∩

�y0

�z1, w��→Stat1 ⇒ c1 ∈ x0 ∩ z1 & z1 ∈ y0 & Stat3 : c1 /∈ {w : y ∈ y0,w ∈ y}�z1, c1��→Stat3 ⇒ false; Discharge ⇒ Stat5 : c1 ∈ {w : y ∈ y0,w ∈ y} & c1 ∈ x0 & c1 /∈

�{x0 ∩ z : z ∈ y0}

�y2, c��→Stat5 ⇒ c1 ∈ x0 & c1 ∈ y2 & y2 ∈ y0 & Stat6 : c1 /∈ {w : z ∈ y0,w ∈ x0 ∩ z}�y2, c1��→Stat6 ⇒ false; Discharge ⇒ Qed

-- intersezione monadicaDef intersection.

�(X) =Def

�z ∈ arb(X) | �∀y ∈ X | z ∈ y��

-- prima legge di De MorganTheorem 23. X\if Y = ∅ then X else

�(Y) fi =

�{X\z : z ∈ Y} . Proof:

Suppose not(x0, y0) ⇒ Auto

-- Ragionando per assurdo, cominciamo semplificando il lato destro della disuguaglianzae con l’escludere la possibilita che il controesempio x0, y0 possa avere y0 = ∅.

Use def (S

{x0\z : z ∈ y0}) ⇒ AutoSIMPLF ⇒

�{x0\z : z ∈ y0} = {z : w ∈ y0, z ∈ x0\w}

Loc def ⇒ w1 = arb(y0)Suppose ⇒ y0 = ∅� {x0\z : z ∈ y0} ��→T3f ⇒ Stat1 : {x0\z : z ∈ y0} �= ∅�z1��→Stat1 ⇒ false; Discharge ⇒ Stat2 : x0\

�(y0) �= {z : w ∈ y0, z ∈ x0\w} & w1 ∈ y0

-- Escluso quel caso banale, l’assurda ipotesi si e ridotta alla disuguaglianza che leggiamoqui sopra. Sia e0 un elemento che differenzia i due membri della disuguaglianza.

�e0��→Stat2 ⇒ e0 ∈ x0\�

(y0) �= e0 ∈ {z : w ∈ y0, z ∈ x0\w}Use def

`T(y0)

´⇒ Auto

-- Se e0 appartiene al primo membro (e dunque non al secondo), allora e chiaro che deveappartenere a un generico elemento w1 di y0 . . .

Suppose ⇒ e0 ∈ x0\�

(y0)(Stat2�)ELEM ⇒ Stat3 : e0 /∈

�z ∈ arb(y0) | �∀y ∈ y0 | z ∈ y�� & e0 ∈ x0 & Stat4 : e0 /∈ {z : w ∈ y0, z ∈ x0\w}

Suppose ⇒ e0 /∈ w1

�w1, e0��→Stat4(Stat2�) ⇒ false; Discharge ⇒ Auto

-- . . .ma di qui a una contraddizione il passo e breve.

�w1��→Stat3 ⇒ Stat5 : ¬�∀w ∈ y0 | e0 ∈ w��w2��→Stat5 ⇒ w2 ∈ y0 & e0 /∈ w2

�w2, e0��→Stat4 ⇒ false; Discharge ⇒ Stat6 : e0 ∈ {z : w ∈ y0, z ∈ x0\w} & e0 /∈ x0\�

(y0)

-- Consideriamo ora l’altro caso, che e0 appartenga al secondo membro ma non al primo.Di nuovo giungeremo a una contraddizione, col che la dimostrazione sara completa.

�w0, z0��→Stat6 ⇒ Stat7 : e0 ∈�z ∈ arb(y0) | �∀y ∈ y0 | z ∈ y�� & w0 ∈ y0 & e0 ∈ x0\w0

� ��→Stat7 ⇒ Stat8 : �∀y ∈ y0 | e0 ∈ y��w0��→Stat8(Stat7�) ⇒ false; Discharge ⇒ Qed

-- seconda legge di De MorganTheorem 23a. X\

�Y = if Y = ∅ then X else

�({X\z : z ∈ Y}) fi. Proof:

Suppose not(x0, y0) ⇒ Auto

-- Ragionando per assurdo, cominciamo semplificando il lato destro della disuguaglianzae con l’escludere la possibilita che il controesempio x0, y0 possa avere y0 = ∅. Da cio seguesubito che {x0\z : z ∈ y0} �= ∅.

�y0��→T3f ⇒ y0 �= ∅ & Stat1 : x0\�

y0 �=�

({x0\z : z ∈ y0})Suppose ⇒ Stat2 : {x0\z : z ∈ y0} = ∅�arb(y0) ��→Stat2 ⇒ false; Discharge ⇒ Auto

-- Richiamando la prima legge di De Morgan, troviamo chex0 ∩

�({x0\z : z ∈ y0}) = x0\

�{x0 ∩ z : z ∈ y0}.

�x0, {x0\z : z ∈ y0} ��→T23 ⇒ x0 ∩�

({x0\z : z ∈ y0}) =x0\

�{x0\z : z ∈ {x0\z : z ∈ y0}}

SIMPLF ⇒ {x0\z : z ∈ {x0\z : z ∈ y0}} = {x0\(x0\z) : z ∈ y0}Suppose ⇒ Stat3 : {x0\(x0\z) : z ∈ y0} �= {x0 ∩ z : z ∈ y0}�c0��→Stat3(Stat3�) ⇒ false; Discharge ⇒ {x0\(x0\z) : z ∈ y0} = {x0 ∩ z : z ∈ y0}�x0, y0��→T3h ⇒ x0\

�{x0 ∩ z : z ∈ y0} = x0\

�y0

EQUAL ⇒ x0 ∩�

({x0\z : z ∈ y0}) = x0\�

y0

-- Il lato sinistro di quest‘ultima uguaglianza si semplifica in inters ({x0-z: z in y0}), ilche contraddice il passo Stat1.

Suppose ⇒ Stat4 :�

({x0\z : z ∈ y0}) �⊆ x0 ∩�

({x0\z : z ∈ y0})�c1��→Stat4(Stat4�) ⇒ Stat5 : c1 ∈

�({x0\z : z ∈ y0}) & c1 /∈ x0

Use def (T

) ⇒ Stat6 : c1 ∈�z ∈ arb({x0\z : z ∈ y0}) | �∀y ∈ {x0\z : z ∈ y0} | z ∈ y��