Come alla Corte di Federico II · Il DNA ricombinante offre una capacità di intervento più...

Transcript of Come alla Corte di Federico II · Il DNA ricombinante offre una capacità di intervento più...

COME ALLA CORTE DI FEDERICO IIOVVERO

PARLANDO E RIPARLANDO DI SCIENZA

IL DNA RICOMBINANTE: UNA VERA RIVOLUZIONE? di Roberto Di Lauro 7

LAVOISIER: UN VERO RIVOLUZIONARIO? di Ugo Lepore 9

LA “RIVOLUZIONE” DEGLI INSIEMI di Roberto Tortora 11

LA RIVOLUZIONE INDUSTRIALE di Nicola De Ianni 13

L’ALBA DELLA SCIENZA: COPERNICO ED I MOTI PLANETARI di Giuseppe Longo 14

LA VERA RIVOLUZIONE! di Luciano Gaudio 16

I MODERNI SCENARI DI VALUTAZIONE DELLA PERICOLOSITA’ SISMICA di Antonio Rapolla 18

Il jazz ricombinante

Vi siete mai chiesti come “fa” un brano di jazz? Più semplice sarebbe pensare al suono e allo stile tipico del funk o del blues. Il punto è che il jazz non “fa”: non può essere identificato e classificato in categorie formali perché non ne ha. Il jazz non è una forma musicale ma un comportamento, con una memoria genetica in grado di riconoscere la sua natura, costituita da pulsione ritmica, interplay e improvvisazione. Queste caratteristiche, però, necessitano, al contempo, di un costante adeguamento e di una ricombinazione al nuovo, all’istantaneo per mezzo di terminazioni coesive che permettono a due frammenti di DNA…ops, di cellule melodiche, prodotti dallo stesso tipo di nucleari…riops, di linguaggio musicale, di essere facilmente uniti. Pensando alla forma come ad un virus, l’orecchio musicale sarà il nostro enzima di restrizione, in grado di difendersi dagli attacchi virali. Il jazzista non potrà mai suonare un brano allo stesso modo: quand’anche ci provasse, sugli stessi accordi e la stessa melodia e accompagnato dagli stessi musicisti, verrebbe fuori necessariamente qualcosa di diverso, dovuto a dinamiche improvvisative sempre nuove e, perfino, a stati d’animo perturbabili. Ancora una volta l’associazione Universo Musica, propone uno sguardo rivolto al jazz, nell’ambito degli appuntamenti di “Come alla Corte di Federico II”. Questa sera verranno estratti e tagliati in frammenti colori e suoni della tradizione afroamericana, per poi lasciare che questi frammenti si inseriscano singolarmente in piccole molecole circolari di musica (ad esempio plasmidi jazzistici) capaci di replicarsi autonomamente e anch’essi aperti dall’enzima (l’orecchio): il tutto darà vita al jazz ricombinante.

Nicoletta Ferace

ENSEMBLE FEDERICO II JAZZ ORCHESTRA

Laura (D. Raskin) Take the A train (Duke Ellington) Summertime (G. Gershwin)Estate (B. Martino)Night and day (Cole Porter) Stella by starlight (Young)Body and soul (Johnny Green) All of me (Gerald Marks) Triste (Jobim) Recordame (Henderson)All the things you are (Jerome Kern)

CARMEN VITIELLO voce GIULIO MARTINO sax FLAVIO GUIDOTTI pianoforteSTEFANO IRACE responsabile Federico II Jazz Orchestra

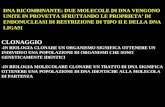

Un gran numero di specie animali e vegetali sono state create dall’Uomo per secoli

usando la Genetica in maniera poco controllata. Il DNA ricombinante offre una capacità di intervento

più preciso ma anche estremamente più potente, che supera il limite naturale delle barriere riproduttive. Quindi, con il DNA ricombinante l’Uomo ha raggiunto

una capacità di intervento sul vivente senza precedenti. Quanto, come e con quali limiti può usarli?

Scienza applicata o scienza di base? Scienza buona o scienza cattiva?

Il dibattito su se e come lo sviluppo delle scoperte scientifiche debba essere governato

e dove si possano spingere le loro applicazioni trova nel DNA ricombinante

un caso esemplare.

Roberto Di LauroNato il 22 Aprile 1948 a Boscotrecase (Napoli).

Carriera scientifica

Laureato in Medicina e Chirurgia presso all'Università “Federico II” di Napoli cum laude, 1972. Visiting Associate nel Laboratorio di Biologia Molecolare del National Cancer Institute, NIH, Bethesda(USA) 1974 -1978. Ricercatore presso il Consiglio Nazionale delle Ricerche, (Napoli), 1978 –1985. Visiting Scientist nel laboratorio di Biochimica del National Cancer Institute, NIH Bethesda, (USA), 1984 -1986. Group Leader, European Molecular Biology Laboratory (EMBL), Heidelberg, 1986 –1991. Professore Straordinario all'Università di Catanzaro, 1986. Professore ordinario di Genetica Medica dal 1987 ad oggi. Attualmente in servizio presso la facoltà di Medicina e Chirurgia dell'Università degli Studi di Napoli Federico II (Napoli).

Incarichi scientifici

Responsabile del laboratorio di Biochimica e Biologia Molecolare della Stazione Zoologica “Anton Dohrn” (Napoli) 1991-2001.

Membro del Comitato Esecutivo dell’European Thyroid Association (ETA),1992-1994. Presidente della Società Italiana di Biofisica e Biologia Molecolare (SIBBM),1998-2001. Coordinatore della Commissione di valutazione borse di studio della “Human Frontier Science Program”(HFSP), 2001-2003. Membro della “European Thyroid Association”. Editor della rivista GenePresidente della società consortile BioGeM, 2001-2005 Direttore Scientifico della società consortile BioGeM, 2005 ad oggi Membro del consiglio scientifico internazionale (ISAC) del “The Giovanni Armenise Harvard Foundation”(2005- 2007) Membro eletto dell’EMBO Council (2005-2007) Componente dello Scientific Advisory Council dell’EMBL (European Molecular Biology Laboratory) Componente di numerosi altri pannelli scientifici nazionali ed internazionali.

Premi e riconoscimenti

Fogarty Scholar National Institute of Health, (USA). Membro della “European Molecular Biology Organizzation” (EMBO). Premio Merck dalla European Thyroid Association (ETA), 2000. Spinoza Professor presso l’Università di Amsterdam, 2000. Premio “Giovan Battista Dalla Porta”, Napoli 2002.

Interessi di ricerca

Roberto Di Lauro ha lavorato principalmente sull'espressione del gene. I suoi interessi scientifici sono concentrati sulla genetica molecolare dello sviluppo e del differenziamento e delle loro alterazioni in patologia. Ha pubblicato più di 200 articoli su riviste scientifiche internazionali con comitato di redazione.

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

IL DNA RICOMBINANTE: UNA VERA RIVOLUZIONE?

Roberto Di Lauro

Professore di Genetica Medica Università degli Studi di Napoli Federico II

L’Uomo ha utilizzato la Genetica, senza

saperlo, per migliaia di anni, quando ha iniziato

la domesticazione di piante ed animali. Il

principio “like breeds like” (simile genera simile),

di immediata evidenza, si è poi spostato sulla

successiva osservazione che “simile” non è

“identico” e che, incrociando e reincrociando

potevano venire fuori organismi con caratteri

migliorati, o comunque diversi, rispetto ai

parenti di un incrocio. Ci sono voluti molti anni

prima che agricoltori ed allevatori ci capissero

qualcosa in quello che facevano, visto che

Mendel ha formulato solo 140 anni fa le prime

leggi rigorose sul controllo e la trasmissione dei

caratteri ereditari da parte dei geni. Ma

l’interesse ad usare la Genetica per scopi

applicativi c’era visto che Mendel, un campione

della ricerca di base, ha ricevuto finanziamenti

da agricoltori interessati a capire se e come si

potessero meglio utilizzare gli incroci per far

variare i caratteri di specie di interesse

commerciale in maniera controllata. Certo è che

l’uso della Genetica nel corso dei secoli, seppure

con una comprensione assai limitata dei suoi

meccanismi, ha modificato il mondo che ci

circonda creando organismi che senza una

certosina attenzione agli incroci non sarebbero

mai esistiti.

Da Mendel in poi la comprensione della

Genetica e, parallelamente, la capacità di

utilizzarla a fini conoscitivi ed applicativi ha visto

un’accelerazione impressionante. Sola qualche

decina d’anni dopo Mendel si è scoperto che i

geni sono fatti di DNA e, solo qualche anno

dopo, la comprensione della sua struttura ha

immediatamente rivelato i meccanismi con cui

questa molecola conserva e trasmette i caratteri

ereditari. I tempi erano ormai maturi per

ulteriori grandi avanzamenti della Genetica,

tant’è che ben 6 premi Nobel furono assegnati a

ricercatori del campo tra gli anni ’50 e ’70. Fino

ad allora però i progressi nella comprensione dei

modi di trasmissione e della natura chimica dei

geni avevano prodotto solo un modesto

incremento applicativo.

A questo punto interviene il DNA

ricombinante, il vero salto di qualità nella

capacità dell’uomo di intervenire in maniera

stabile sul vivente che ha trasformato la Biologia

da scienza analitica (comprensione del vivente)

a scienza creativa (modificazione del vivente).

Il tutto nasce da una curiosità scientifica

senza nessuna pretesa applicativa. Werner Arber

studiava virus batterici ed osservò che questi

virus imparavano a riconoscere il ceppo che

avevano infettato e non erano capaci di infettare

ceppi diversi, ma potevano impararlo.

Il meccanismo alla base di questo

fenomeno, noto come sistema di modificazione e

restrizione, portò alla scoperta di molecole

capaci di tagliare il DNA in maniera riproducibile

e controllata. Il premio Nobel per la Medicina e

Fisiologia ad Arber, Smith e Nathans ricapitola il

principio chiave del DNA ricombinante: il DNA si

può tagliare ed i pezzi così ottenuti possono

esser ricuciti (ricombinati) in provetta per creare

7

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

geni con nuove potenzialità. Da allora è stato

un susseguirsi di applicazioni che hanno

utilizzato questi principi fondamentali. Il genoma

umano, la terapia genica, gli organismi

geneticamente modificati, la produzione di

farmaci biologici, la scoperta dei geni

responsabili di malattie, sono tutti risultati che

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

non si sarebbero ottenuti senza il DNA

ricombinante. Ma, l’intervento sul vivente per

modificarlo in funzione dei propri bisogni, che

l’Uomo opera da millenni, ha solo trovato

strumenti più potenti o il DNA ricombinante è

una vera rivoluzione?

8

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

LAVOISIER: UN VERO RIVOLUZIONARIO?

Ugo Lepore

Professore di Chimica generale inorganica Università degli Studi di Napoli Federico II

Nel XVII e XVIII secolo la transizione tra

alchimia e chimica come scienza moderna era

ancora in pieno sviluppo; moltissimi fenomeni

erano interpretati in base a teorie che

dimostreranno in seguito la loro fragilità. Per

esempio, fino al 1770, era diffusa la convinzione

che il residuo solido che si trova in un recipiente

in seguito ad una lunga bollitura dell’acqua fosse

dovuto alla trasformazione dell’acqua in terra.

L’interpretazione delle osservazioni era confinata

all’interno dell’antica concezione dei quattro

elementi (terra, acqua, aria e fuoco) di

derivazione aristotelica.

Per la maggior parte del XVIII secolo,

sulla base di una teoria proposta da Becher nel

1669 e sviluppata da Stahl, il fenomeno della

combustione era interpretato in termini di

separazione del flogisto e di una sostanza

deflogistizzata (la cenere o un residuo). Così, ad

esempio, il legno era una combinazione di

flogisto e di cenere di legno. Analogamente, la

corrosione dei metalli in aria (come

l’arrugginimento del ferro) era ritenuta

anch’essa una forma di combustione, sicché

quando un metallo era convertito nella sua calce

(il suo ossido, in termini moderni) si perdeva

flogisto. Pertanto i metalli erano composti di

calce e flogisto: l’aria assicurava solo

l’allontanamento del flogisto liberato. L’obiezione

che le ceneri delle sostanze organiche pesavano

di meno dell’originale, mentre la calce era più

pesante del metallo era di scarsa importanza per

Stahl, che immaginava il flogisto come un

“principio” immateriale piuttosto che una

sostanza reale. Nonostante fosse completamente

sbagliata, per lungo tempo la teoria del flogisto

fornì un'ipotesi di lavoro che spiegava in modo

coerente molti fenomeni naturali. Allora, essa

appariva così chiara e perfetta da essere

catalogata come una delle più importanti

dell'epoca, rimanendo nella cultura dei chimici

per oltre un secolo.

Per confutare la teoria del flogisto

occorreva un approccio quantitativo alle

trasformazioni chimiche ben lontano sia dalla

mentalità dell'epoca che dai mezzi a

disposizione. La chimica del tempo, infatti, non

aveva teorie sufficientemente potenti per

interpretare la pur vasta moltitudine di dati

sperimentali accumulati e per interagire con

altre discipline, come la fisica, che aveva invece

già costituito da tempo la sua base teorica o la

matematica i cui strumenti entreranno in modo

significativo nella chimica solo in tempi

successivi. Inoltre, solo verso la fine del secolo si

diffuse l'uso di raccogliere i gas e di valutare con

la bilancia, in modo accurato, l'acquisto o la

perdita di peso durante combustioni o

calcinazioni. Non meraviglia, quindi, che solo nel

1770 Antoine-Laurent Lavoisier fu in grado di

affrontare il problema della bollitura dell’acqua

da un’angolazione completamente innovativa per

lo studio delle trasformazioni della materia:

conducendo una serie di esperimenti basati sulla

pesatura accurata del vapore condensato e del

residuo solido rimasto nel recipiente dimostrò

che non avveniva alcuna conversione di acqua in

9

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

terra. Il suo intervento fu determinante anche

per modificare radicalmente l’interpretazione dei

cambiamenti provocati dai vari tipi di

combustione: le sue indagini quantitative (1770-

1790) portarono alla conclusione che nei

processi di combustione partecipava una

sostanza materiale contenuta nell’aria

(l’ossigeno) e non una sostanza immateriale. Lo

studio quantitativo del comportamento del

mercurio all'aria, i cui risultati furono pubblicati

da Lavoisier in una memoria nel 1775, viene

considerato un “esperimento cruciale” nella

storia della chimica che permetterà il passaggio

dal “paradigma della teoria del flogisto” alla

legge della conservazione della massa.

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

Il contributo rivoluzionario di Lavoisier

alla scienza è consistito proprio in questo: aver

gettato le basi per “vedere” i fenomeni con un

occhio completamente diverso dal passato,

permettendo che la concezione pratico-

cosmologico-religiosa della realtà che era

l’alchimia fosse completamente abbandonata.

Non altrettanto “rivoluzionario” fu il suo

contributo all’altra rivoluzione in atto in Francia,

tanto che questa gli fu fatale. “È bastato un

momento per tagliare quella testa, e forse non

basterà un secolo per generarne un’altra pari

alla sua” (J. Lagrange).

10

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

LA “RIVOLUZIONE” DEGLI INSIEMI

Roberto Tortora

Professore di Matematiche complementari Università degli Studi di Napoli Federico II

La matematica, la più austera (?) delle

discipline, ha conosciuto vicende appassionate?

Certamente sì, tante volte, di quelle che in un

filmato sarebbero accompagnate da una colonna

sonora romantica. Qualcosa di davvero

straordinario è accaduto ad esempio tra fine

Ottocento e inizi Novecento nell’ambito della

Logica e dei Fondamenti, allorché si consuma

una vera e propria rivoluzione. E non parlo del

celeberrimo Teorema di Gödel, sul quale si è

detto tutto, ma della apparentemente modesta e

innocua nozione di insieme, introdotta in quegli

anni da Georg Cantor.

Gli insiemi si usano oggi con confidenza,

a partire dalle elementari, ma pochi forse sanno

quanto hanno cambiato la matematica.

Vediamo.

In primo luogo si è potuto per la prima

volta far luce nelle profondità dell’infinito,

consentendo di distinguere rigorosamente tipi

diversi di infinito. Già questo non è poco.

Ma il senso più profondo della rivoluzione

insiemistica sta nell’aver sostituito ad ogni

proprietà la sua estensione. Questa sostituzione

fornisce solo un modo diverso, magari più

generale e comodo, per descrivere situazioni

(non solo) matematiche? Dopo tutto, dire

“l’insieme dei multipli di 4 è contenuto

nell’insieme dei numeri pari” è equivalente a

dire, come si diceva prima che ci fossero gli

insiemi, “ogni multiplo di 4 è un numero pari”.

Fosse solo questo, sarebbe una novità di portata

alquanto modesta.

Non è così: il punto è che non c’è piena

corrispondenza tra insiemi e proprietà. In primo

luogo proprietà diverse possono dar luogo allo

stesso insieme. La nozione di insieme si fonda

infatti sul cosiddetto Principio di

Estensionalità: due insiemi coincidono se

hanno gli stessi elementi. Sembra una banalità e

difatti gli insiemi non li concepiremmo senza

questo requisito. Ma se ne ricava che sostituire

gli insiemi alle proprietà costituisce una

straordinaria semplificazione; e nello stesso

tempo elimina alla radice molti problemi

“concettuali” che avevano assillato per secoli gli

studiosi. Ad esempio che cosa è un numero

razionale? Si diceva: ciò (la proprietà) che hanno

in comune le infinite frazioni equivalenti ad una

data. Ma di che si tratta: una quantità, un

valore, e che significano queste parole? Con gli

insiemi, eludiamo l’insidia di queste domande:

un numero razionale è semplicemente l’insieme

di tutte le frazioni equivalenti ad una frazione

data.

In secondo luogo, ci sono insiemi

(nuovi!) che non possiamo descrivere con delle

proprietà. Ne garantisce l’esistenza l’Assioma

della Scelta. Prendiamo l’insieme dei numeri

reali o, che è lo stesso, l’insieme dei punti di una

retta (fra i due sussiste una corrispondenza

biunivoca). I numeri reali costituiscono un

insieme ordinato: a tutti è chiaro quando un

numero reale è minore di un altro o un punto di

una retta viene prima di un altro. Ma in certi casi

vogliamo poter ordinare gli elementi di un

insieme in modo diverso, facendo in modo che

ogni volta che tolgo degli elementi, ci sia sempre

11

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

un minimo (un punto di partenza) fra i

rimanenti. I matematici lo chiamano un buon

ordinamento, ed è quello che caratterizza ad

esempio i numeri naturali.

Volendo, anche i numeri razionali si

possono ordinare bene, partendo dai numeri che

si esprimono con frazioni “semplici” (con

numeratore e denominatore piccoli) e

proseguendo così. Si può fare la stessa cosa con

i numeri reali? La risposta è sì, ma è uno strano

sì, perché c’è un teorema che afferma che un

tale ordinamento sui numeri reali esiste

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

(il Teorema di Zermelo che si basa sull’Assioma

della Scelta), ma ce n’è un altro che esclude la

possibilità che lo si possa descrivere.

Dunque con gli insiemi cambia

l’ontologia in matematica: affermare l’esistenza

di qualcosa non è la stessa cosa che poterla

costruire. Era così prima: ad esempio un

teorema di esistenza di una soluzione di

un’equazione differenziale andava sempre di pari

passo con la sua costruzione. Ora si può

affermare l’esistenza anche di cose che in linea

di principio non si possono costruire.

12

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

LA RIVOLUZIONE INDUSTRIALE

Nicola De Ianni

Professore di Storia economica e Storia dell’Industria Università degli Studi di Napoli Federico II

Ad intere generazioni di studenti è stata

insegnata come una rivoluzione, sebbene il

termine non corrispondesse al significato politico

della parola. In effetti, tale può essere

considerata per le profonde trasformazioni che

ha messo in atto, sia pure all’interno di un

processo lungo ed articolato di decenni che dura

da circa 250 anni. Vera rivoluzione perché ha

indotto altrettante rivoluzioni nei comparti

attigui come l’agricoltura, i trasporti, il

commercio e la finanza. Vera rivoluzione perchè

ha introdotto la meccanizzazione ed il sistema di

fabbrica, ha fortemente accelerato i processi

produttivi ed ha prodotto modifiche sociali

rilevanti come la nascita di borghesi capitalisti e

proletari.

Nell’interpretazione marxiana, in

un'evoluzione deterministica, ciò avrebbe

necessariamente portato allo scontro di classe

ed alla dittatura degli oppressi. Il capitalismo

della mano invisibile di Smith e di quella visibile

di Keynes, ha però resistito e saputo rinnovarsi e

meglio di quanto non abbia fatto il socialismo

reale, nonostante la caduta relativa del saggio di

profitto, la tendenza alla concentrazione ed

all’imperialismo, lo sviluppo e la crisi della

grande impresa. L’esplosione dei mercati

finanziari, passati, nel cinquantennio 1930-1980,

da speculazione estrema ad efficace allocazione

di risparmio, la stupefacente crescita degli

strumenti di controllo di politica economica da

parte delle autorità, l’ampliamento del ruolo

delle banche centrali, la scomparsa dell’oro dagli

equilibri del sistema monetario internazionale e

la sua sostituzione con indici macroeconomici

(Pil, debito pubblico, tassi d’interesse, inflazione,

etc), hanno contribuito a produrre ricchezza

come mai nella storia dell’umanità. La forte

crescita ed il calo considerevole poi della

pressione fiscale nel lungo periodo, hanno avuto

il merito storico di imporre il problema della

gestione delle risorse, il costo dei servizi, la

condotta efficiente della pubblica

amministrazione.

L’affermazione della democrazia come

valore irrinunciabile, infine, ha creato una solida

base di condivisione, dopo due guerre mondiali,

la prima imperialista, la seconda totalitaria.

L’evoluzione tecnologica e scientifica, dal motore

a scoppio sino ad internet, ha accompagnato

questi processi in un quadro che certo potrebbe

apparire più convincente se comprendesse anche

un’equa distribuzione della ricchezza, una meno

approssimativa soluzione dei problemi

energetici, l’universale stringente

riconoscimento, oltre che delle quantità, anche

delle qualità, la convergenza verso la tolleranza

e la pace.

Fattori in grado di restituire il senso di

una competizione utile e dura, ma con regole

certe, e che, soprattutto, sappia non scadere in

una logica litigiosa. Il tutto nel contesto sociale

di una comunità globale a misura e prova di

persone. E con una forza rivoluzionaria come

quella industriale della seconda metà del

Settecento, compatibile col progresso e con una

libertà oggettivamente riconosciuti.

13

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

L’ALBA DELLA SCIENZA: COPERNICO ED I MOTI PLANETARI

Giuseppe Longo

Professore di Astrofisica Università degli Studi di Napoli Federico II

Leggenda vuole che la prima copia

ancora fresca di stampa del “De Revolutionibus

Orbium Coelestium” sia stata presentata al suo

autore, il canonico polacco Niccolò Copernico,

quando questi era in punto di morte. L’anno era

il 1543 e nessuno, neanche lo stesso Copernico,

avrebbe potuto sospettare che quel libro

avrebbe segnato la fine di oltre un millennio di

dominio pressoché assoluto dell’aristotelismo e

posto il seme di quella che oggi chiamiamo

rivoluzione scientifica.

Fino ad allora, l’universo era stato

descritto secondo i precetti codificati

nell’Almagesto dall’astronomo greco Claudio

Tolomeo, con una Terra immobile e gli altri astri,

incluso il Sole, in moto intorno ad essa su orbite

complesse descritte dalla sovrapposizione di

moti circolari. Nei circa tredici secoli trascorsi

dalla pubblicazione dell’Almagesto, la necessità

di adattarsi ad osservazioni sempre più

numerose ed accurate, aveva richiesto una

progressiva complicazione del sistema tolemaico

che, nelle sue varie versioni, si era trasformato

in quella che Copernico ebbe modo di definire

una vera e propria mostruosità matematica.

Eppure, questa mostruosità era così

inestricabilmente connessa con quasi ogni

aspetto della filosofia aristotelica e della teologia

scolastica, da apparire intoccabile. La Terra

occupava il centro dell’Universo. Quello era il suo

luogo naturale e essa non poteva muoversi,

altrimenti nulla sua superficie sarebbe rimasto

fermo al suolo. I moti dei pianeti dovevano

essere necessariamente circolari perché questa

era la forma perfetta e la “sfera delle stelle fisse”

delimitava il confine con l’empireo, sede di Dio e

degli angeli.

Copernico si era formato in questa

tradizione e non seppe mai abbandonarla del

tutto, ma a differenza dei suoi predecessori ed

anticipando di quasi un secolo la posizione di

Galileo, aveva una fede incrollabile nella capacità

della matematica di catturare e descrivere la

natura reale delle cose. Fu questa convinzione a

dare allo scienziato polacco l’audacia necessaria

a strappare la Terra dalle sue fondamenta e a

proiettarla nei cieli, in orbita intorno ad un Sole

finalmente riconosciuto come signore

incontrastato dell’Universo. Uno slancio

intellettuale titanico che se fosse stato

immediatamente compreso avrebbe suscitato

un’opposizione ancor più veemente e

intransigente di quella che si ebbe. Ma la fortuna

ed il genio di Copernico furono l’avere scritto il

“De Revolutionibus” per un pubblico di

specialisti, nascondendo gli aspetti rivoluzionari

nelle parti più tecniche e incomprensibili e

presentandone solo una sintesi divulgativa nel

capitolo introduttivo. Così, mentre la canea degli

eruditi, dei teologi e di tutti coloro che non

sapevano di matematica si accaniva sugli aspetti

marginali dell’opera, l’ipotesi eliocentrica fece in

tempo a penetrare con profonde radici nella

comunità degli specialisti. In altre parole,

quando ci si accorse della reale pericolosità

dell’eresia copernicana, essa era talmente

diffusa e condivisa da renderne pressoché

impossibile l’eliminazione.

14

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

Va però detto che Copernico pose solo il

seme di quella rivoluzione concettuale che

avrebbe trovato la sua piena maturazione solo

agli inizi del XVII secolo con la formulazione da

parte dell’astronomo tedesco Johannes Kepler

delle leggi del moto planetario in cui per la prima

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

volta veniva abbandonata l’ipotesi della

circolarità dei moti. L’opera di Keplero a sua

volta, fu il presupposto ineludibile che permise

ad Isaac Newton, di formulare, nel 1687, quella

teoria della gravitazione universale che avrebbe

segnato la nascita della fisica moderna.

15

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

LA VERA RIVOLUZIONE!

Luciano Gaudio

Professore di Genetica Università degli Studi di Napoli Federico II

Nell’introduzione alla conversazione

svolta alla società dei Naturalisti di Brünn nelle

date dell’otto febbraio ed otto marzo del 1865,

sull’ibridazione nelle piante (Versuche über

Pflanzenhybriden) Mendel, monaco agostiniano,

pose l’accento sul fatto che nessuno dei tanti

esperimenti condotti in precedenza sullo stesso

tema era stato pianificato in modo da definire il

numero delle varie forme in cui sono

classificabili i discendenti degli ibridi. Ordinare

queste forme nelle varie discendenze. Definire i

loro rapporti numerici.

E’ vero. Fin dal 1694 Camerarius, nella

sua Epistola de sexu plantarum, Fairchild,

Bradley, Mather e lo stesso Linneo, in altri scritti

o conversazioni, avevano descritto esperimenti

di ibridazione nelle piante.

Poi, nel 1761, in quel campo il punto di

riferimento divenne Koelreuter. Con le sue

osservazioni di quaranta anni di

sperimentazione.

Ancora nel 1823 Knight descriveva la

dominanza del colore rosso del fiore delle piante

di pisello. Negli stessi anni, indipendentemente,

Goss e Seton descrivevano il comportamento di

altre caratteristiche del seme delle piante di

pisello (e.g. seme verde, seme giallo). Gaertner

scriveva che la variabilità della progenie degli

ibridi è una forte indicazione della loro natura

ibrida e Naudine ribadiva le stesse conclusioni.

Mendel non aveva organizzato i suoi esperimenti

sul nulla. Vi era una numerosa comunità

scientifica che aveva lavorato e lavorava. Si

direbbe oggi sul miglioramento vegetale.

Però le conclusioni di Mendel furono

rivoluzionarie. Quelle furono vera rivoluzione.

Ma non vi arrivò per caso. Lavorò per otto anni,

due dei quali per saggiare le 34 varietà di pisello

e selezionare le 22 che utilizzò in seguito.

Produsse ed esaminò 28.000 piante. Il senso del

suo metodo viene da quanto scrive, egli stesso.

Il valore e la validità di ogni esperimento

sono determinati dall’individuazione di

strumenti adatti, e nel modo in cui vengono

applicati…..non può essere ininfluente quali

piante siano state scelte e come sono stati

condotti gli esperimenti. La scelta del

gruppo di piante…………..deve essere fatta

con la massima cura se non si vuole

mettere a rischio dall’inizio la possibilità di

successo.

E’ una perfetta dichiarazione di

impostazione di lavoro sperimentale e di scelta

accurata dell’organismo modello.

La storia dei suoi principi è nota.

Gregorio Mendel fece uscire dalle nebbie i

principi base della trasmissione dei caratteri

ereditari. Croce e delizia di ogni studente alle

prese con lo studio della genetica. Mendel

propose la spiegazione più semplice. Pluralitas

non est pondera sine necessitate.

Non è stato il primo, ma ha utilizzato

mirabilmente il rasoio di Occam. Il concetto di

parsimonia. Affermando che ogni carattere da lui

studiato fosse determinato da un fattore, da una

16

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

particella. Affermando che ogni genitore ne

possiede due e ne trasmette solo uno ad ogni

figlio. Affermando che ognuna delle

caratteristiche da lui studiate ha lo stesso

comportamento se presa da sola o insieme alle

altre. Fu un precursore. Solo nel 1900 i tre

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

botanici De Vries, Correns e Von Tschermak

riscoprirono i suoi principi, dandogliene merito. E

la genetica divenne scienza nota. Poi il suo lungo

cammino fino alle frontiere di oggi. Con tante

pietre miliari. Con tante date importanti. Ma

nessuna, forse, può eguagliare quella prima.

L’orto del monastero dove Mendel ha effettuato i suoi esperimenti sulla genetica delle piante.

17

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

Dalla previsione alla prevenzione: I MODERNI SCENARI DI VALUTAZIONE DELLA PERICOLOSITA’ SISMICA

Antonio Rapolla

Professore di Geofisica Università degli Studi di Napoli Federico II

Le recenti normative sul Rischio sismico

pongono in modo molto più attento, anche se

non ancora esaustivo, l’accento sulla importanza

di una nuova e moderna valutazione, da parte

dei tecnici delle Scienze della Terra, della

Pericolosità Sismica di un sito. Elemento

indispensabile per la valutazione quantitativa del

Rischio Sismico e, di conseguenza, per la

valutazione corretta delle azioni e delle opere a

carattere ingegneristico da intraprendere per il

necessario adeguamento e la messa in

sicurezza di edifici esistenti e per la corretta

progettazione antisismica di nuovi edifici.

Si abbandona in un certo senso il filone,

scientificamente interessante, ma praticamente

di scarsa utilità, della Previsione sismica per

affidarsi quasi unicamente alla linea della

Prevenzione.

Con la vecchia legge del 1974 i Comuni

dichiarati sismici venivano, sulla base dei

terremoti registrati nel passato, classificati

mediante decreti legislativi e ad essi veniva

assegnato un grado di sismicità ed uno Spettro

di Risposta in base a dati ricavati solo da studi

sismologici. L’intera normativa antisismica

nazionale non prevedeva in pratica studi ed

indagini geologiche e geofisiche indirizzate alla

zonazione sismica dei territori comunali ed

intercomunali e degli specifici siti di costruzione.

Oltretutto, lo spettro di risposta sismico veniva

determinato senza tenere in gran conto le

caratteristiche geologico-sismiche dello specifico

sito in esame. Ben presto ci si rese conto che la

sola classificazione sismica non era

assolutamente sufficiente a discriminare le

reali condizioni di pericolosità. Ed in effetti, i

terremoti dell’Irpinia, del Molise e i tanti altri del

recente passato, hanno prodotto danni

estremamente differenziati nei vari centri abitati

colpiti.

In Campania, a seguito delle leggi

regionali, si cominciò a dare un segnale positivo

verso una più corretta e significativa valutazione

della pericolosità sismica, indicando una serie di

indirizzi applicativi. Nel 1996 l’Ordine Regionale

dei Geologi pubblicava uno studio che suggeriva

ai professionisti interessati ed anche alle

strutture istituzionali competenti quali fossero le

azioni da compiere, quale la densità delle

indagini e quali le correlazioni da utilizzare. Più

recentemente, lo stesso Ordine e la Regione

Campania hanno predisposto un nuovo studio

teso a definire e ad omogeneizzare gli studi e le

indagini che i professionisti interessati e gli

Organi Istituzionali competenti devono effettuare

per rispondere correttamente alle nuove

disposizioni normative.

In realtà è, purtroppo, ancora ampiamente

diffuso il concetto che la Pericolosità Sismica,

necessaria con la Vulnerabilità Sismica a definire

il Rischio Sismico, sia tutto sommato definita e

modulata attraverso la Classificazione sismica.

In effetti la Pericolosità sismica può, ma solo in

primissima istanza, essere espressa attraverso

la definizione “una tantum” di un livello

18

COME ALLA CORTE DI FEDERICO II Il dna ricombinante: una vera rivoluzione?

energetico unico e costante che il sisma

mostrerebbe in tutto un territorio comunale e

quindi anche nel sito considerato. Nella realtà, il

livello energetico del terremoto atteso in un

territorio Comunale è solo indicativamente

rappresentato dalla Classificazione. Esso è

riferito solo al caso in cui siano in affioramento

rocce o terreni rigidi. Livelli ben maggiori

possono invece essere raggiunti in un

determinato sito in dipendenza delle

caratteristiche geosismologiche dei terreni non

rigidi di copertura. La presenza di tali terreni non

solo modifica il livello energetico del sisma

atteso, ma, principalmente, il suo spettro

amplificando o attenuando alcune sue

componenti, tanto da produrre azioni sismiche

notevolmente differenti anche per siti posti a

sole poche decine di metri di distanza tra loro.

Centro di Ateneo per la Comunicazione e l’Innovazione Organizzativa Università degli Studi di Napoli Federico II

E’ chiara la conclusione: la Pericolosità

sismica effettiva nei siti di edificazione in un dato

Comune classificato può essere molto diversa e,

quindi, perché siano efficaci, gli interventi di

ingegneria antisismica dovranno essere definiti

per ogni specifico caso. Bisognerà pertanto

fornire al progettista, perché possa

correttamente applicare le tecniche antisismiche,

le reali caratteristiche dell’evento sismico che

eventualmente colpirà lo specifico sito di

costruzione e cioè “definire per ogni specifico

sito di costruzione il livello energetico e le

caratteristiche spettrali dell’evento sismico

che colpirà quel particolare sito”.

Solo in tal modo potremo affermare di aver

effettuato una opera di Prevenzione efficace.

19